Apple, na keynote otwierającym WWDC 2023, zaprezentowało pierwszy produkt w nowej dla nich kategorii – VR/AR – i nazwali go Vision Pro. Ich pierwszy headset prezentuje się znakomicie od strony jakości wykonania i technologii w jego wnętrzu, zdając się przewyższać możliwości innych graczy na rynku pod niektórymi względami. Podsumujmy zatem wszystko, co o Vision Pro w tej chwili wiemy.

Spatial Computing

Apple w swojej historii, wprowadzając nowe produkty do nowych kategorii, szeroko reklamowało ich możliwości i z czasem zaczynało rozumieć ich przeznaczenie na podstawie oczekiwań i sposobu wykorzystania ich przez klientów. Dobrym przykładem tutaj jest Apple Watch, który dzisiaj jest fitnessowo-zdrowotnym urządzeniem, którego wszystkie pozostałe cechy są dodatkiem.

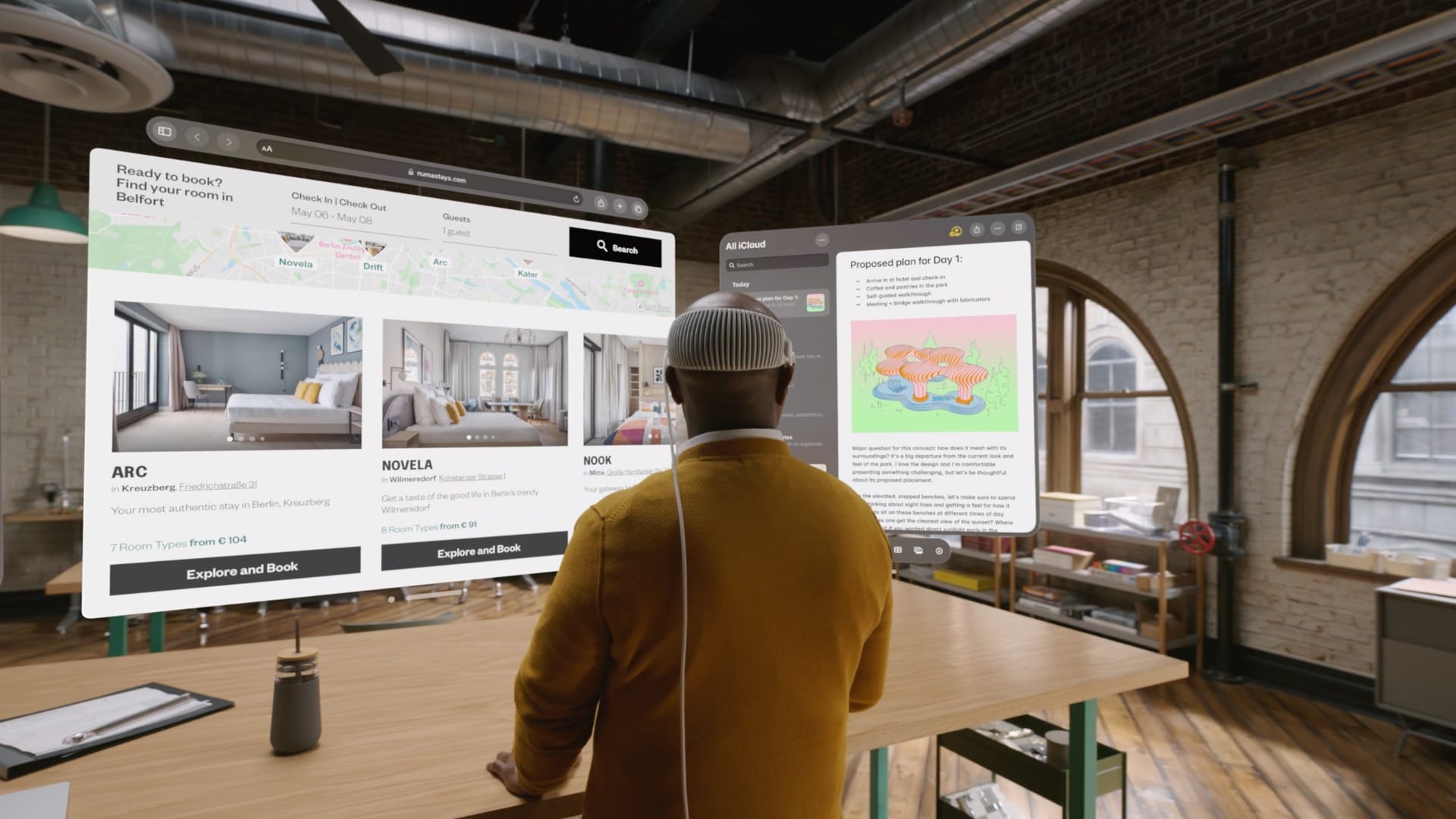

Hasłem przewodnim w przypadku Vision Pro to „spatial computing”, czyli po prostu przestrzenny system operacyjny i komputer, który wykorzystuje otoczenie wokół nas do wyświetlania wszystkich aplikacji i ich okien. Istotny tutaj jest fakt, iż Vision Pro to nie jest akcesorium dla iPhone’a – to pełnoprawny i wolnostojący komputer, w którego wnętrzu pracuje Apple M2, ten sam układ, który napędza najnowszego 15,3-calowego MacBooka Air. Sam system operacyjny to visionOS, oparty o fundamenty iOS-a, iPadOS-a i macOS-a, który potrafi uruchamiać aplikacje z iPhone’a i iPada, oraz komunikować się Macami, aby tworzyć dla nich wirtualne monitory (na obecną chwilę nie uruchamia aplikacji macOS-owych, ale można otworzyć iOS-owe lub iPadowe obok wirtualnego ekranu dla Maca). Jego pełne możliwości nie są nam jeszcze znane i prawdopodobnie w najbliższych dniach, tygodniach i miesiącach będziemy dowiadywali się coraz więcej.

Kiedy i ile?

Vision Pro będzie kosztował „od 3499 USD” i jego sprzedaż ma się rozpocząć „early 2024”, co w nomenklaturze Apple’a oznacza premierę w pierwszych czterech miesiącach 2024 roku, a więc w styczniu, lutym, marcu lub kwietniu.

Biorąc pod uwagę zastosowaną technologię w tym urządzeniu – wystarczy się zagłębić we wszystkim, aby dostrzec gigantyczny wysiłek w to włożony – cena naprawdę nie jest wygórowana. Niestety, dla większości z nas będzie nie do przełknięcia.

Wymiary

Wymiary ani waga nie są w tej chwili znane, ale dzięki rozszerzonej rzeczywistości możemy zobrazować sobie Vision Pro we własnym otoczeniu. Na dwóch powyższych zdjęciach widzicie go na moim biurku (120×60 cm), gdzie headset leży obok 11-calowego iPada Pro, pod 27-calowym Studio Display i obok Maca Mini.

Konstrukcja – z czego się Vision Pro składa?

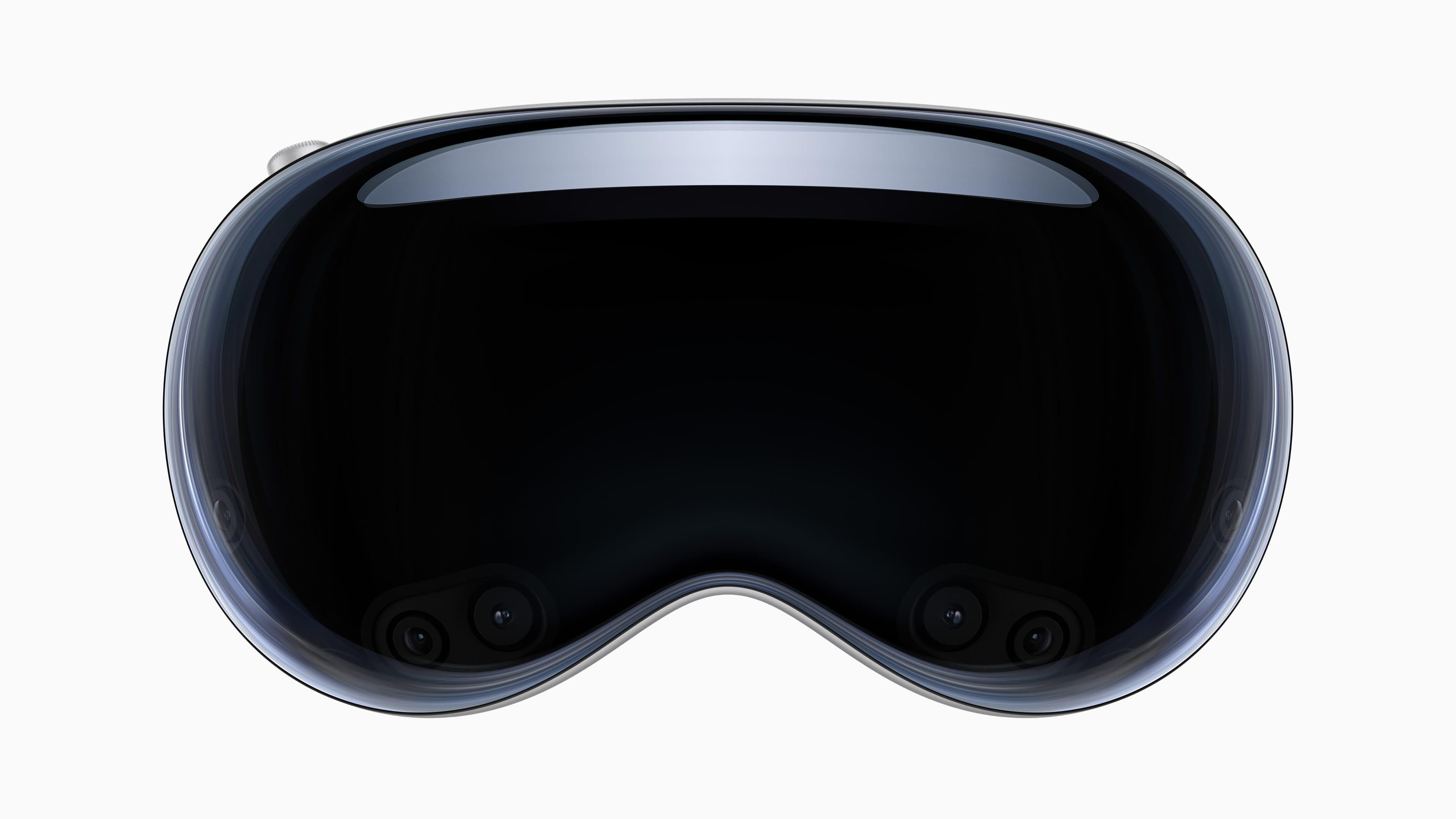

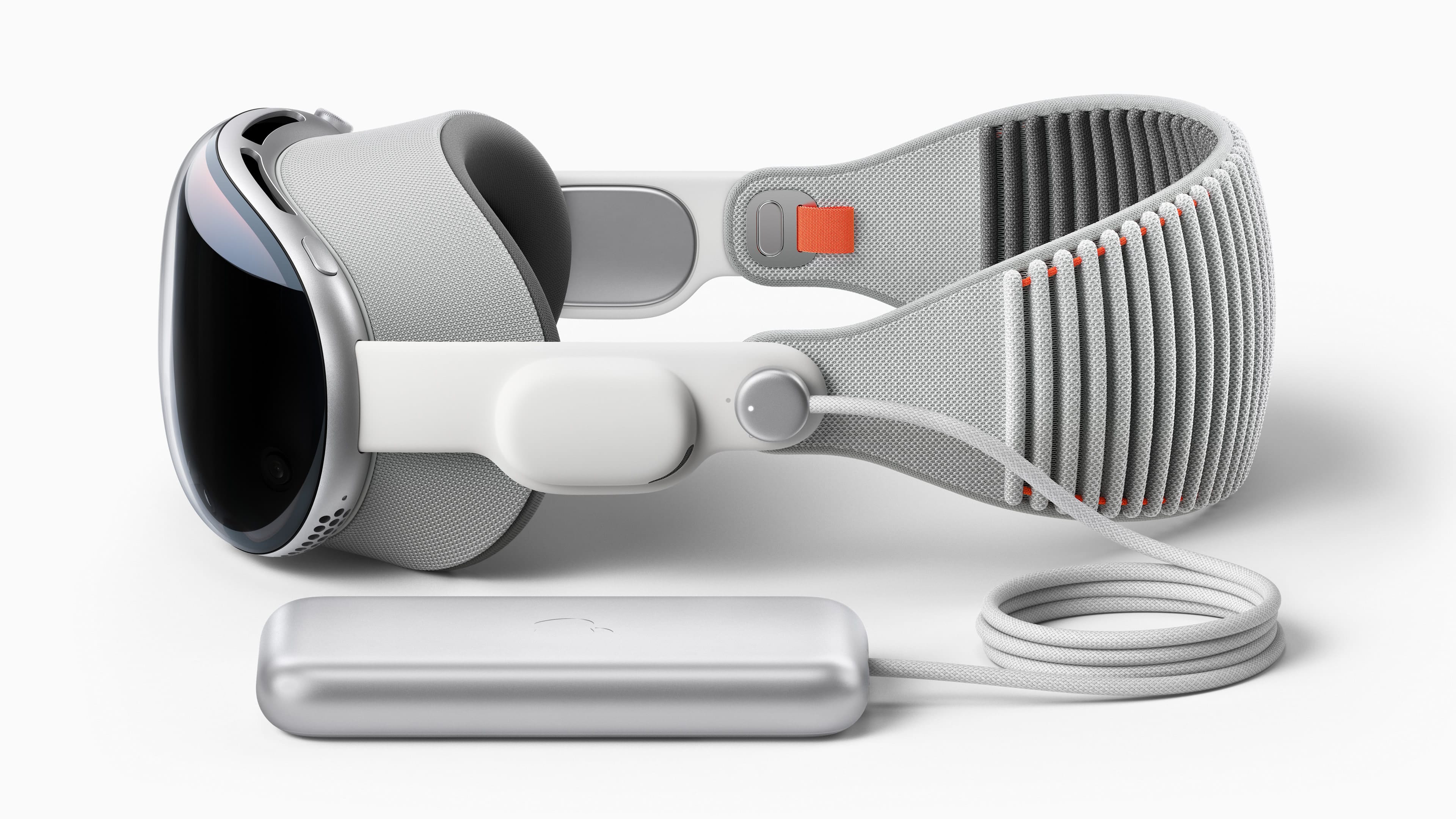

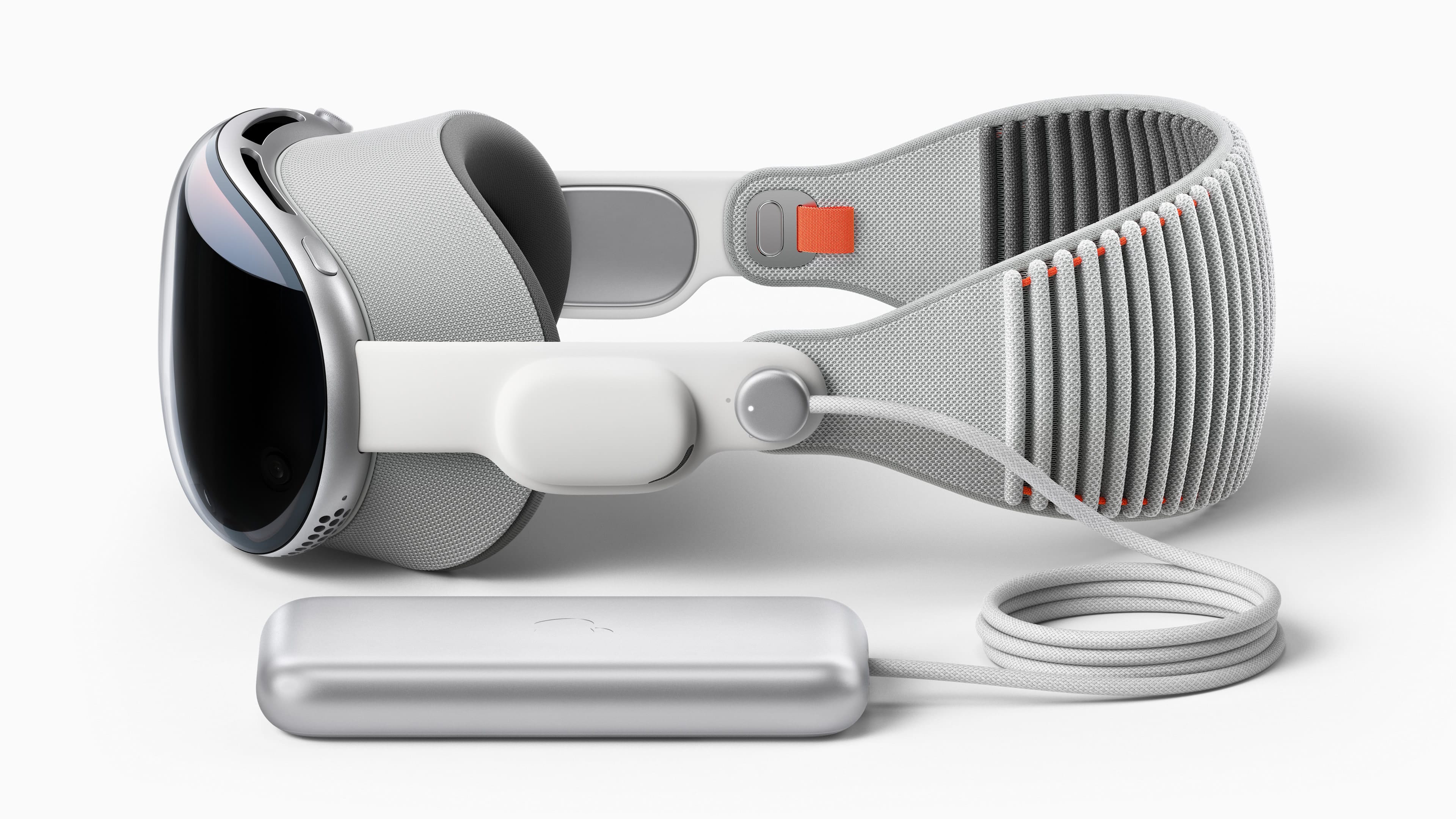

Vision Pro składa się z sześciu odrębnych elementów. Na przodzie znajdziemy szklaną, wygiętą powierzchnię, za którą schowany jest zewnętrzny ekran oraz spora liczba czujników i kamer. To szkło gładko łączy się z główną obudową, wykonaną ze stopu aluminium, z którego po bokach wychodzą dwa paski, do których wbudowane specjalnie głośniki – nazwano je Audio Straps.

Szklany przedni ekran wymagany jest do funkcji EyeSight, która wyświetla nasze oczy i twarz wokół nich dla osób w naszym otoczeniu. Apple twierdzi, iż to pierwszy lenticular display (ekran soczewkowy), który wyświetla nasze oczy w prawidłowej perspektywnie dla większej ilości osób wokół nas, w taki sposób, iż każdy je widzi bez zniekształceń. Szczegóły, jak to wszystko dokładnie działa, jeszcze nie są znane.

Pomiędzy aluminiową obudową, a naszą twarzą mieści się Light Seal – element, który będziemy prawdopodobnie zamawiali na wymiar naszej twarzy. Mówi się o pierwszym skanowaniu twarzy w 3D albo w Apple Store przed kupnem, albo dzięki własnego iPhone’a w domowym zaciszu. Szczegóły na temat tego procesu jeszcze nie są sfinalizowane, ale w tej chwili wygląda to podobnie do skanowania twarzy przy pierwszej konfiguracji Face ID. Apple pracuje też nad większą różnorodnością kształtów Light Seal, aby lepiej pasowało do twarzy ludzi – niektórzy testujący dziennikarze zgłaszali, iż ich miejscami uciska lub powoduje ból głowy. Inne źródła z kolei donoszą, iż kilka różnych w kształcie i/lub rozmiarze Light Seals będzie dostarczanych z każdym Vision Pro.

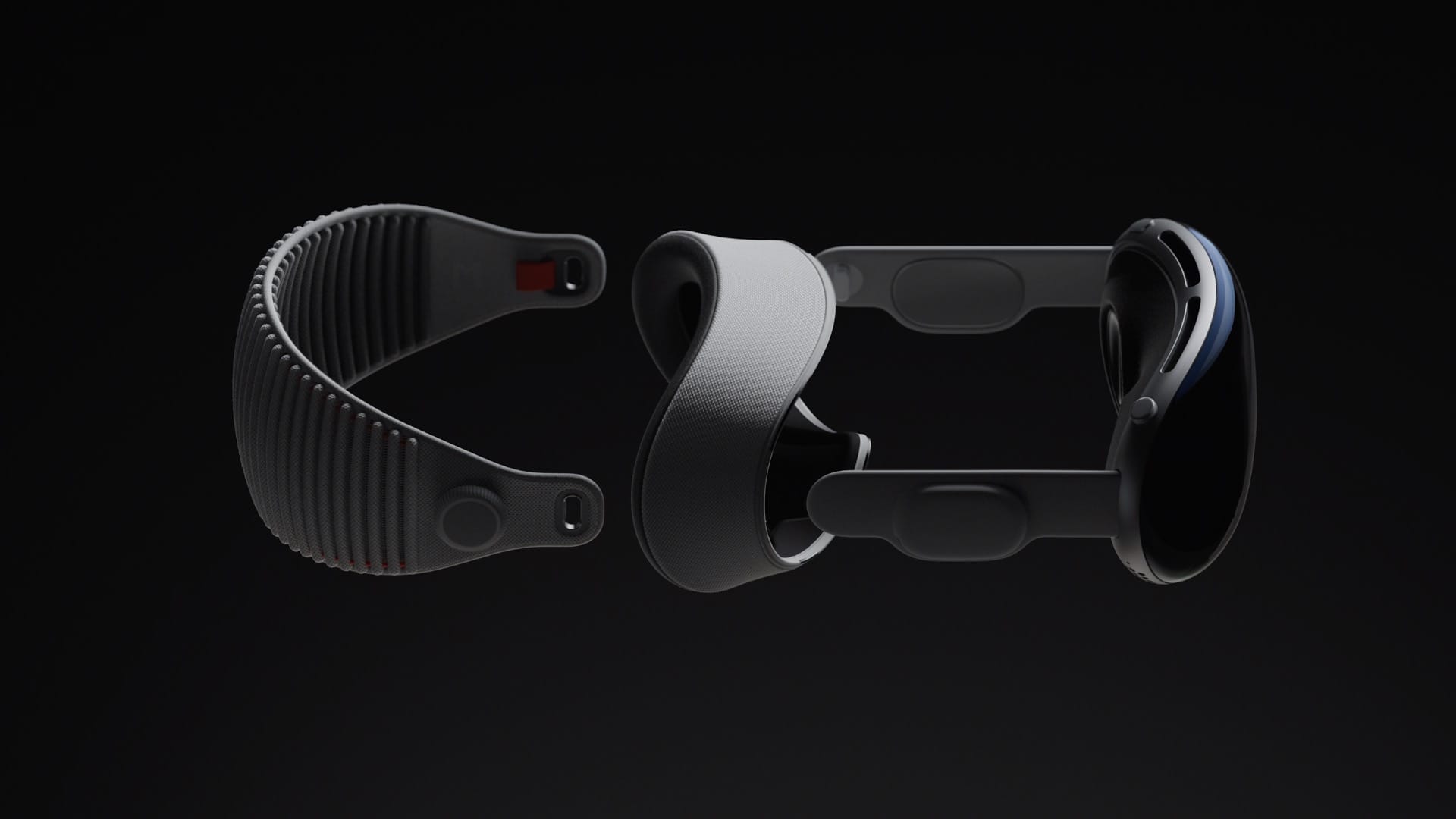

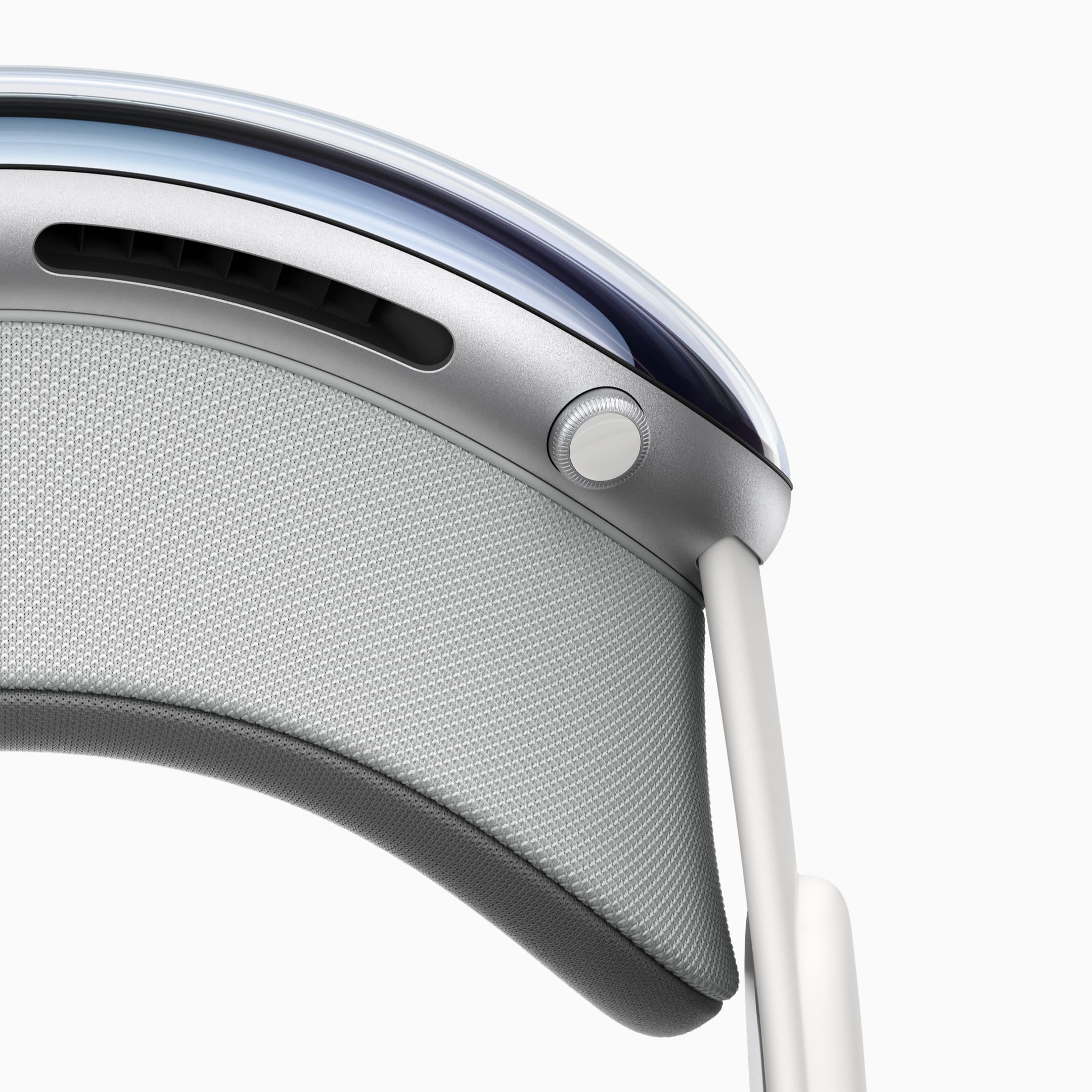

Ostatniem elementem samego Vision Pro to tylny elastyczny pasek, nazwany Head Band, wykonany z oddychającego materiału 3D, który ma niwelować pocenie się skóry. Niektóre elementy dla Vision Pro będą dostępne od firm trzecich, a Apple ma dwa razy do roku oferować inne wersje kolorystyczne Light Seal i Head Band. Jest też, prawdopodobnie opcjonalny, górny pasek, który może nas odciążyć – ten nie został pokazany w żadnych oficjalnych materiałach.

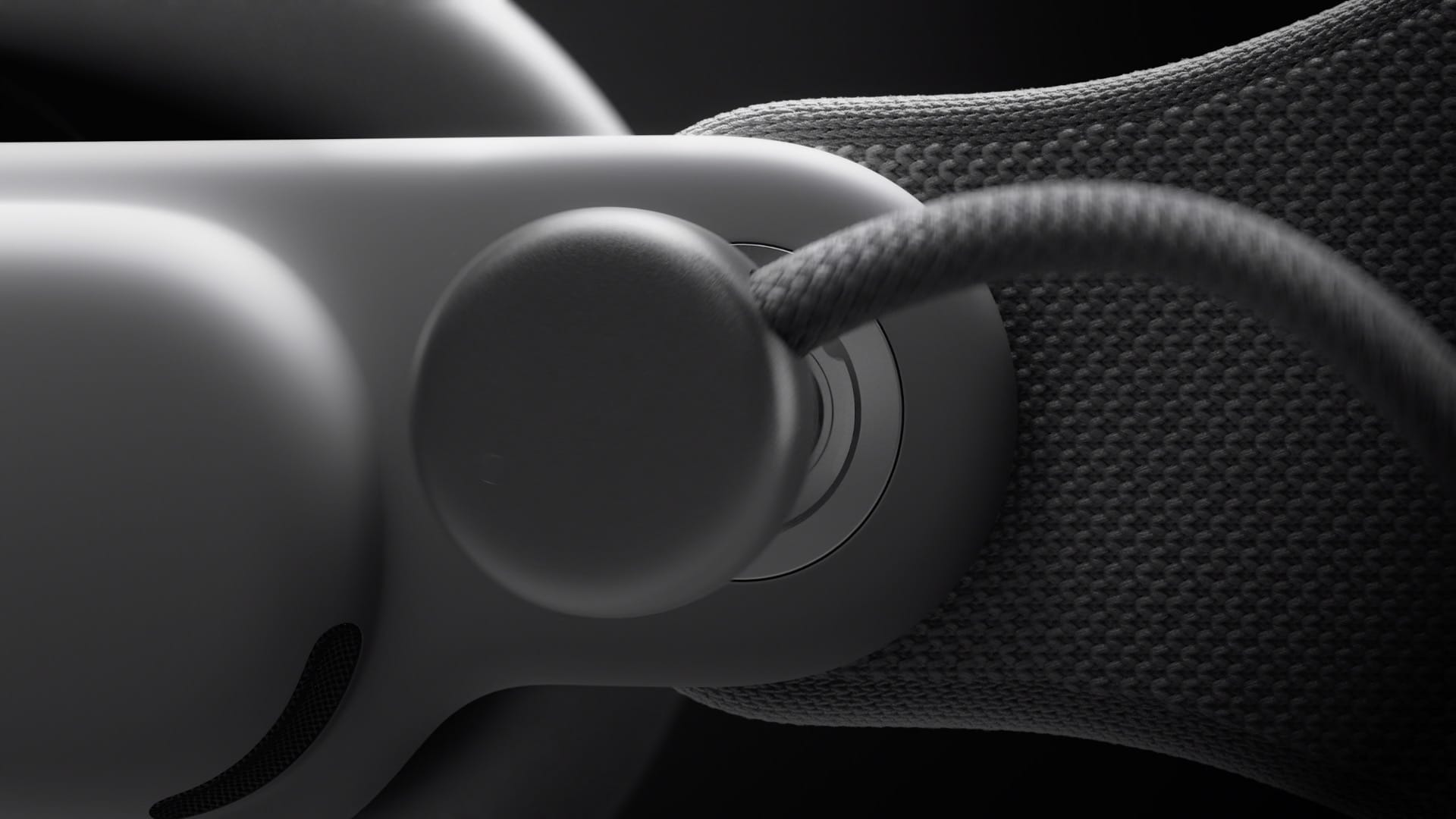

Na deser zostaje przewód do zewnętrznego akumulatora i sam akumulator, którego mamy kłaść obok siebie, albo trzymać w kieszeni. Sam przewód łączy się do headsetu dzięki mechanizmu z obrotową blokadą. Nie wątpię, iż zaraz pojawią się akcesoria, aby baterię montować do… wszystkiego. Sam akumulator ma port, prawdopodobnie USB-C, dzięki którego będziemy podłączeni do „ściany”, aby nie być ograniczonym do dwóch godzin pracy na jednym ładowaniu. Alternatywa, która wymagałaby odłączania baterii, aby podłączyć zasilanie zewnętrzne, wydaje się być absurdalna. Sam akumulator zdaje się też być odłączalny od przewodu łączącego go z headsetem.

Na kadrach z sesji deweloperskich, widać przejściówkę z wyjściem na prawdopodobnie kabel USB-C, podłączoną do prawej strony Vision Pro, dokładnie po przeciwnej stronie od miejsca podłączania baterii. Ludzie spekulują, iż dzięki tego złącza będzie można podłączać klasyczne powerbanki pod USB-C, ale osobiście podejrzewam, iż to po prostu sposób na podłączenie Vision Pro do Maca w celach deweloperskich.

Na górnych rogach ramki Vision Pro znajdziemy jeszcze jeden przycisk (po lewej) do wyzwalania nagrywania wideo lub robienia zdjęć w 3D oraz cyfrową koronkę (po prawej) do ustawiani przepuszczalności świata, w którym się znajdujemy, czyli w uproszczeniu do płynnego przełączania się pomiędzy światem AR (ten, w którym widzimy pokój w którym jesteśmy), a VR (ten, w którym wszystko jest generowane cyfrowo).

Czy można Vision Pro używać z okularami?

Nie. Przynajmniej oficjalnie. Między headsetem a naszą twarzą nie ma miejsce na okulary. Nie powinno być problemów z soczewkami kontaktowymi, ale Apple przygotował system magnetycznie montowanych i wymiennych szkieł, dla osób, które potrzebują korekty wzroku. w tej chwili nie wiemy jeszcze co to oznacza dla osób, które mają inne wady niż krótko czy dalekowzroczność, jak np. astygmatyzm.

Osoby, które miały okazję przetestować Vision Pro podczas WWDC23, raportują, iż Apple przepuszczało przez ich okulary wiązkę światła i na tej podstawie dobierali magnetycznie montowane soczewki do headsetu. Soczewki do headsetów, do podobnych urządzeń, kosztują w rejonie 60-100 USD za parę. Mark Gurman podejrzewa, iż Apple będzie żądało ok. 300-600 USD za parę, a inni spodziewają się cen w rejonie 200 USD. Wszystkiego dowiemy się bliżej lub podczas premiery Vision Pro, ale od siebie podpowiem, iż tłumaczenia cen Gurmana nie mają żadnego sensu – soczewki Zeissa kosztują w rejonie 100 USD za parę.

Pierwsze uruchomienie

Sama procedura pierwszego uruchomienia, jak opowiadali osoby uczestniczące w WWDC23, obejmowała dwie czynności, które Apple potrzebuje, aby efekt korzystania z headsetu był jak najlepszy. Pierwsza czynność to podniesienie rąk przed naszą twarz, aby Vision Pro mógł poznać ich kształt i strukturę. Druga to kalibracja systemu śledzenia naszego wzroku – w ciemności zostaniemy poproszeni o skierowania wzroku na białe kropki w różnych punktach w przestrzeni. To wszystko zajmuje dosłownie kilkadziesiąt sekund.

Pojawiła się też plotka, iż iPhone będzie wymagany, aby przeprowadzić pierwszą konfigurację, ale wygląda na to, iż to bzdura, przynajmniej na obecną chwilę. Wiele różnych osób obecnych WWDC23 zgłasza, iż iPhone nie jest w żadnym momencie wymagany. Być może plotka wzięła się stąd, iż iPhone’a można wykorzystać przy pierwszych uruchomieniu, podobnie jak można go wykorzystać do automatycznego skonfigurowania Apple TV, gdzie set-top-box Apple’a po prostu korzysta z naszych ustawień i Apple ID, abyśmy nie musieli manualnie wszystkiego wpisywać.

Jak się używa Vision Pro?

Vision Pro to wolnostojący komputer, który nie wymaga dodatkowych urządzeń. Działa pod kontrolą visionOS, który opiera się o iOS/iPadOS, więc wspiera uruchamianie aplikacji z iPhone’ów i iPadów. Dodatkowo wspiera łączenie się z Macami, abyśmy mogli wyświetlić w wirtualnej przestrzeni ekran w rozdzielczości 4K i pracować na nim.

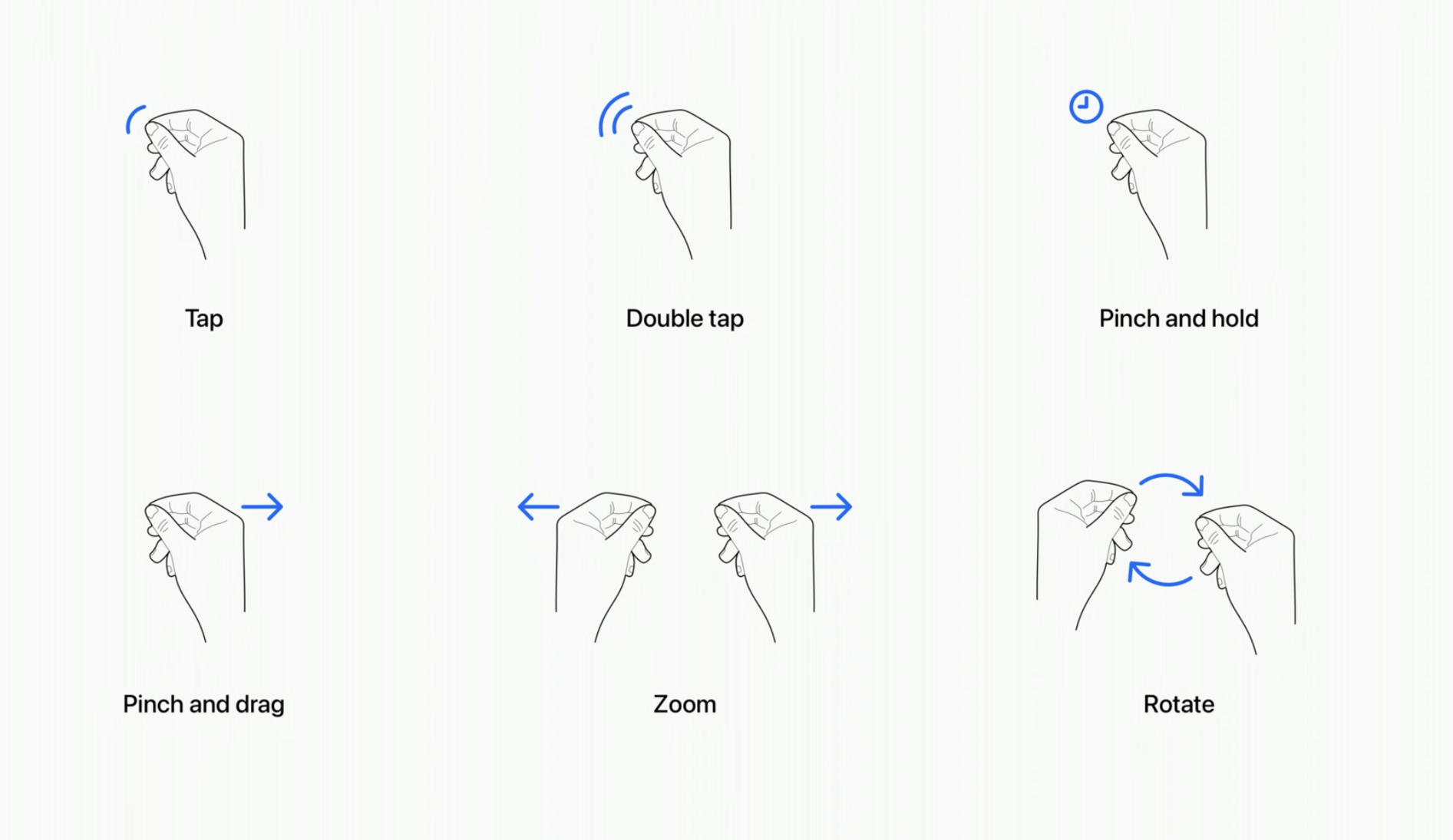

Vision Pro sterujemy dzięki oczu, gestów i głosu oraz opcjonalnie dzięki zewnętrznych urządzeń sterujących, jak klawiatura, myszka czy Trackpad. Gesty, obok oczu, będą stanowiły absolutną podstawę naszych interakcji z visionOS. w tej chwili wiemy o sześciu:

- złożenie palca wskazującego i kciuka to tapnięcie,

- j.w. ale dwukrotnie to podwójne tapnięcie,

- można ścisnąć palec wskazujący z kciukiem i przytrzymać je dla pinch and hold,

- po ściśnięciu palców można też je tak przytrzymać i przesunąć dłoń, aby coś przeciągnąć,

- dwoma ściśniętymi palcami z kciukami, oddalając lub przybliżając je do siebie, wywołujemy zoom,

- a obracając je j.w. obracamy danym elementem.

Wydaje się to być to wszystko proste i intuicyjne, ale deweloperzy będą mieli dostęp do pełnej wirtualnej rekonstrukcji tego, co robią nasze palce i dłonie, włączając w to zginanie stawów palców. Na podstawie tego będą mogli tworzyć własne gesty i akcje, np. do gier lub specjalistycznych aplikacji.

Dzięki Dostępnosći / Accessibility będzie można też alternatywnie konfigurować gesty czy choćby ruch głowy, dla osób niepełnosprawnych.

W przypadku braku klawiatury podłączonej do headsetu po Bluetooth, będzie można również korzystać z wirtualnej klawiatury, która albo wisi przed nami w powietrzu.

Szczegóły działania visionOS

System operacyjny – visionOS – który jest odpowiedzialny za obsługę Vision Pro, zbudowano na podstawie iOS-a i iPadOS-a. Obsługuje więc sporo aplikacji z App Store dla mobilnych urządzeń Apple’a już dzisiaj, a przy drobnych korektach deweloperów, będą potrafiły więcej.

To wstępne skanowanie naszych rąk ma również umożliwić wyświetlanie ich pod oknami czy innych elementami – nie będą całkowicie zakryte przez np. okno Safari, jeżeli coś będziemy chcieli w nim dotknąć i z jakiegoś powodu ręka nasza znajdzie się za tym oknem.

Oglądanie wideo

Headset jest już dzisiaj gotowy do obsługi wszystkich dostępnych treści wideo, np. z aplikacji Apple TV. Idealnie też nadaje się do oglądania treści 3D, które na headsetach VR zaczynają mieć sens. Seans oglądania wideo można albo odbywać w trybie mixed reality, gdzie wirtualny ekran kinowy wisi nam w cyfrowo przyciemnionym pomieszczeniu, w którym się znajdujemy, albo w pełnej wirtualnej rzeczywistości – Apple na keynote pokazało, jak siedzimy na brzegu jeziora, w którym odbija i nocne niebo, a na środku tego wszystkiego wisi kolosalny ekran kinowy.

Aplikacje 2D, czyli Windows

Aplikacje napisane dla iPhone’a i iPada będą mogły wyświetlać się w przestrzeni wokół nas, w pomieszczeniu, w którym się fizycznie znajdujemy, i będziemy je mogli dowolnie umieszczać tam, gdzie chcemy. Wszystkie aplikacje Apple’a, jak Telefon, Wiadomości, Przypomnienia, Notatki czy Safari, będą tak funkcjonowały, obok wielu aplikacji trzecich. Apple nazywa to Windows w dokumentacji technicznej.

Aplikacje będą mogły mieć dodane elementy 3D, np. wyobraźmy sobie, iż czytamy stronę z encyklopedii o dinozaurach – obrazek dodany jako ilustracja tekstu może być elementem 3D, którym możemy manipulować, np. obracając go.

Aplikacje 3D, czyli Volumes

Drugą kategorią aplikacji, które mogą istnieć (czyli być otwartymi) obok aplikacji 2D, to Volumes. To są programy 3D, np. gra w szachy, którą możemy umieścić przykładowo na stoliku kawowym w naszym salonie. Można nimi oczywiście manipulować i przesuwać je tam, gdzie nam to odpowiada.

Aplikacje „pełnoekranowe”, czyli Full Space

Ostatnią kategorią aplikacji to są tzw. Full Space, które otwierają się we własnej przestrzeni, czyli nie są obok innych aplikacji 2D czy 3D (Windows i Volumes) wymienionych powyżej. Te ustawiają własną przestrzeń, w ramach której mogą otwierać własne Windows i Volumes. Przykładem może tutaj być jakaś duża aplikacja, jak Final Cut Pro, która wypełnia swoimi oknami np. nasz pokój. Przy okazji zdradzę, iż wiemy już, iż Final Cut Pro w wersji na Vision Pro zadebiutuje razem z headsetem od pierwszego dnia. Drugim przykładem może być Apple TV app w trybie „pełnoekranowym” (teoretycznie mogłaby też działać jako okno w trybie 2D).

Dla aplikacji „pełnoekranowych” stworzono Environments / Środowiska, np. podczas oglądania filmów. Jednym jest Cinema Environment (Środowisko kinowe), gdzie siedzimy po prostu w kinie, ale jeżeli chcemy, możemy zmienić je na jedno z wielu innych, które Apple przygotowało, gdzie ekran „może mieć 100 stóp (30 m) szerokości”.

Mac

visionOS będzie również potrafił rozpoznać nasze Maki i po połączeniu się z nimi, będzie mógł wyświetlić wirtualny ekran. Apple twierdzi, iż ten ekran ma rozdzielczość 4K i wiemy, iż możemy zmieniać jego wymiary oraz położenie.

Spodziewam się zatem, bo nie można przecież zmieniać wymiarów okna/wirtualnego ekranu bez zmiany jego rozdzielczości, iż chodzi o jego przestrzeń roboczą, czyli właśnie 3840×2160 px, co przetłumaczoną na punkty oznacza albo 1920×1080 pt przy Retina 2x lub 2560×1440 pt przy Retina 1.6.

Obecnie jesteśmy ograniczenie do jednego (słownie: JEDNEGO!) wirtualnego monitora dla naszego Maca. To potencjalnie spore ograniczenie, które najprawdopodobniej wynika z przepustowości – w tej chwili nie da się więcej danych przepchnąć bez kabla. Pamiętajmy jednak, iż skoro wszystkiego Apple’owe aplikacje będą natywnie otwierane na Vision Pro, to nie ma przeszkód, aby obok wirtualnego monitora otworzyć sobie okno z Safari, Mailem, Wiadomościami itp.

Spatials Personas, czyli nasze avatary w 3D

Vision Pro, dzięki swoich zewnętrznych kamer, potrafi stworzyć naszego wirtualnego i trójwymiarowego avatara, którego Apple nazywa Spatial Persona. w tej chwili będzie służyła do rozmów wideo przez FaceTime, ale w przyszłości będzie miało więcej zastosowań, również podczas SharePlay.

Aparat i kamera 3D

Vision Pro to nie tylko pierwszy headset AR/VR od Apple, ale to jednocześnie pierwsza kamera i aparat, które potrafią rejestrować obraz w trzech wymiarach. Spustem migawki jest wspomniany przycisk na górnym lewym rogu ramki Vision Pro, a EyeSight, czyli zewnętrzny ekran, jasno wskazuje wszystkim dookoła, iż nagrywamy.

EyeSight

Jedną z kluczowych cech Vision Pro, która ma zapobiegać izolowania osoby od innych w ich otoczeniu, to zewnętrzny ekran, przedstawiający wizualnie stan immersji osoby z Vision Pro. jeżeli użytkownik jest całkowicie zanurzony w świecie VR i nie widzi swojego otoczenia, to jego oczy będą zamglone, za coś przypominającego rzekę kolorów. jeżeli inna osoba wejdzie w kadr użytkownika Vision Pro, to ta osoba przedrze się przez wirtualny świat VR i zostanie jej pokazana, z fragmentem jej otoczenia.

Szczegóły techniczne

M2 i R1

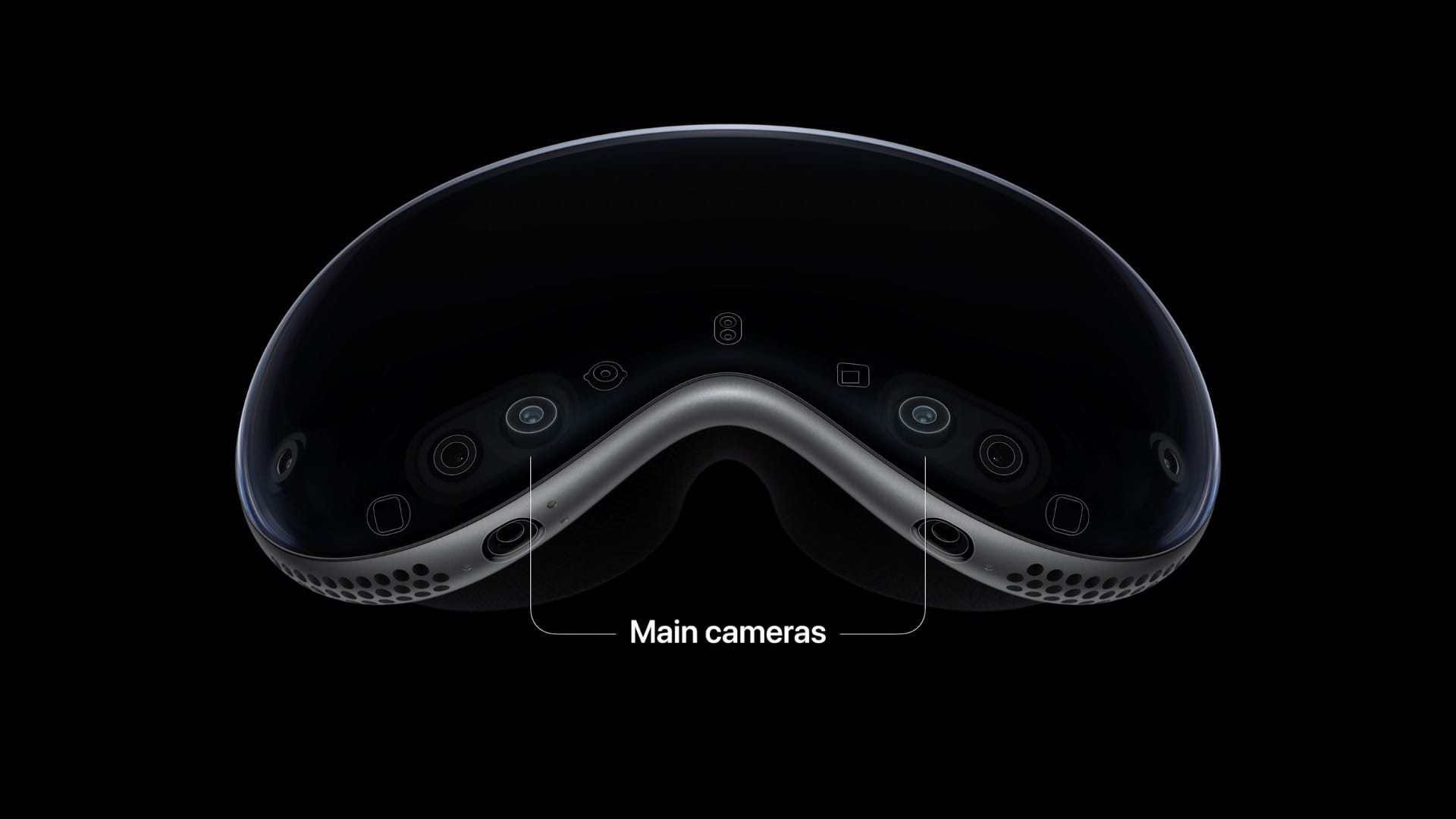

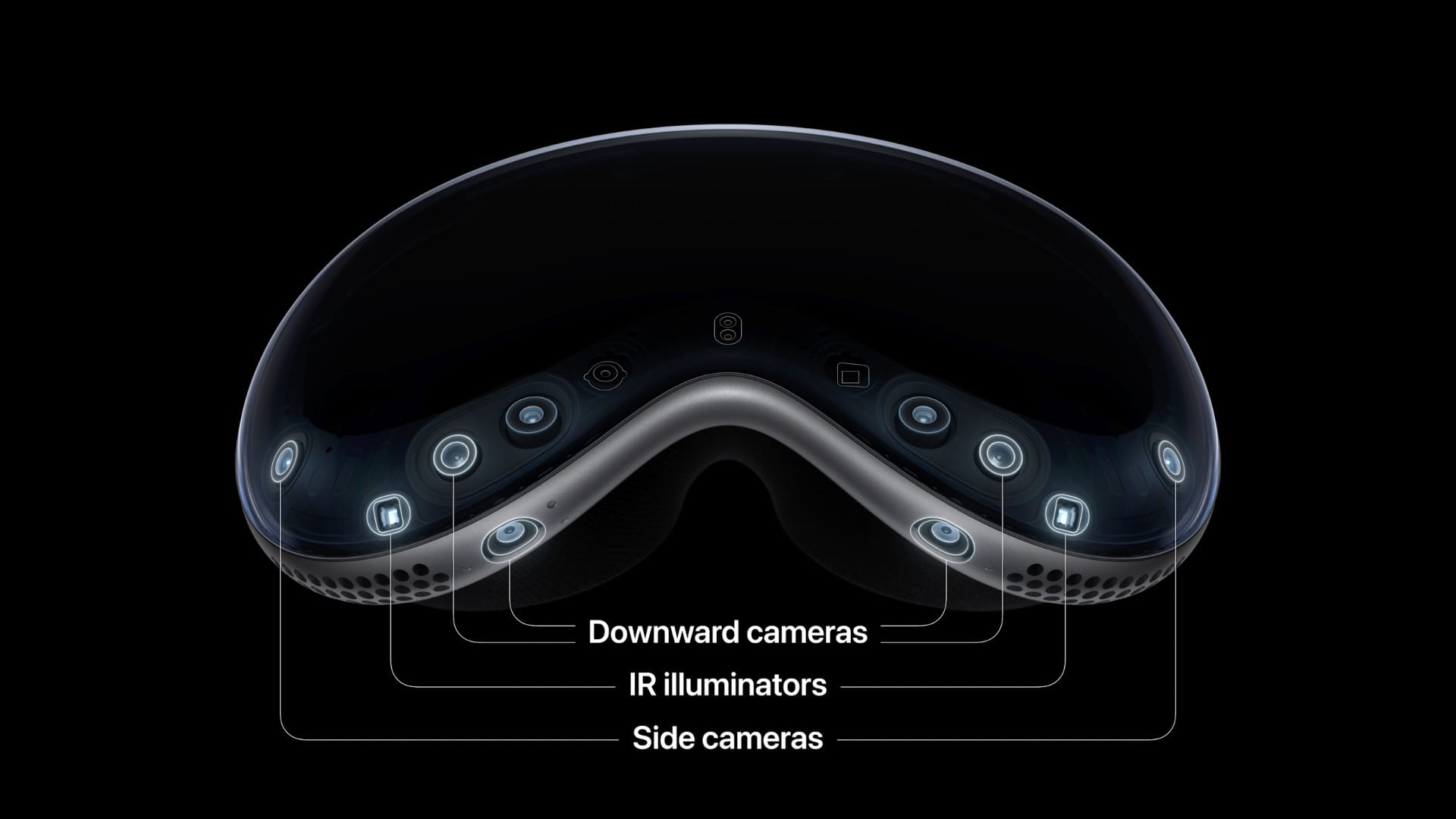

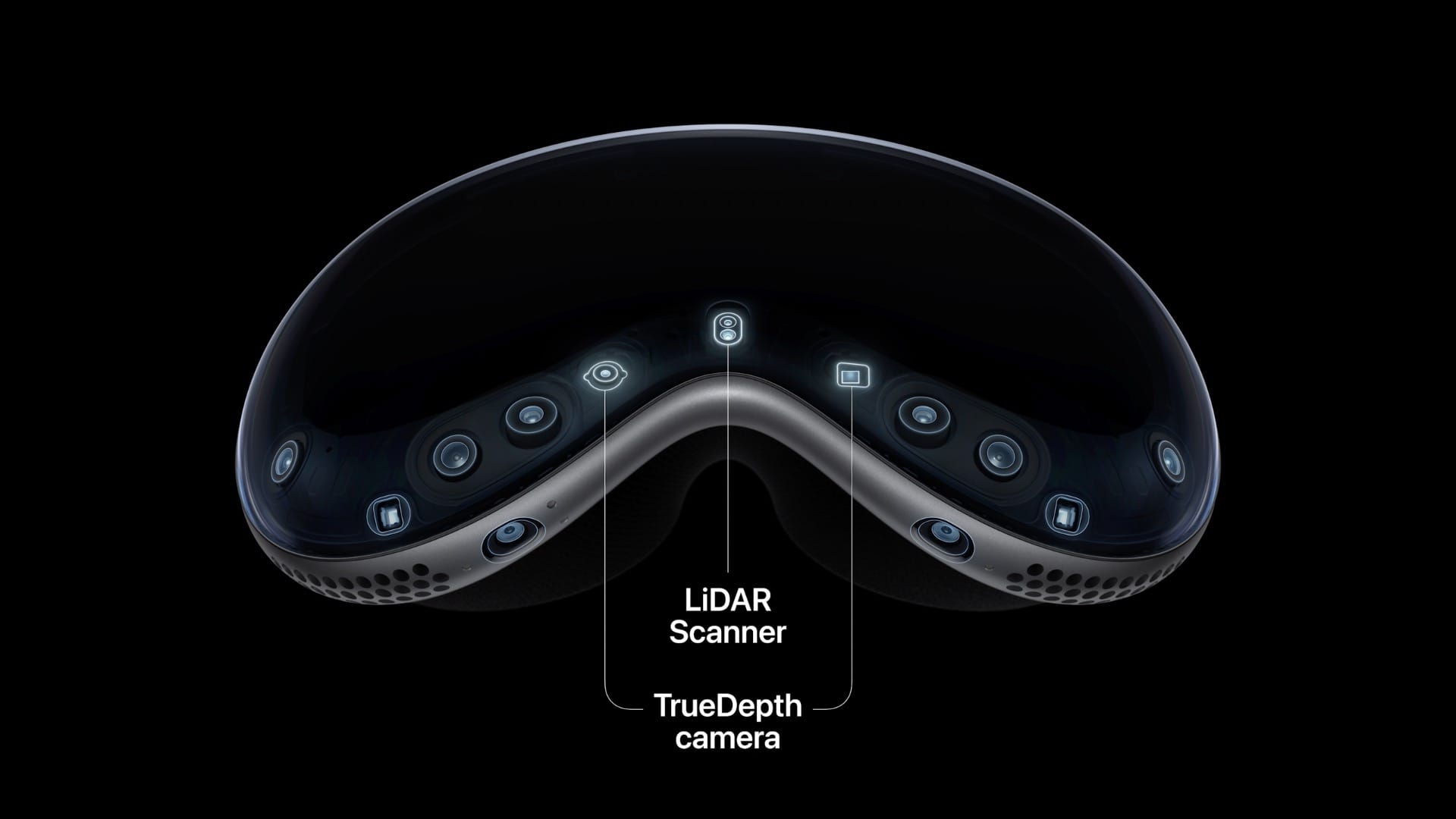

Na pokładzie Vision Pro znajdziemy Apple M2, znany układ z MacBooków Air czy Maców Mini, który zapewnia pokaźne pokłady mocy. Wspomaga go układ Apple R1, który odpowiada za przetwarzanie strumieni z 12 kamer, pięciu czujników i sześciu mikrofonów. R1 dostarcza też nowe obrazki dla ekranów Vision Pro z opóźnieniem 12 milisekund (co jest 8x szybciej niż mrugnięcie okiem, wg Apple; ChatGPT podpowiada, iż mrugnięcie trwa od 100 do 150 ms, czyli mniej więcej się zgadza).

Skoro headset ma debiutować dopiero w miesiącach styczeń-kwiecień 2023 roku, to możemy też spodziewać się, iż Vision Pro dostanie upgrade do Apple M3 lub nowszego.

Micro-OLED

Sercem Vision Pro jest wspomniana para układów M2 i R1, ale my spędzimy czas na patrzeniu na ekrany Micro-OLED. Te dwa wyświetlacze razem mają 23 mln subpikseli oraz „po 4K na oko”. To oznacza, iż to odpowiednik Retiny w świecie ekranów stosowanych przez Apple, gdzie nasze oko nie dostrzeże pikseli, pomimo ich bliskiej odległości.

Śledzenie wzroku

Wokół ekranów Micro-OLED znaleziono miejsce dla systemów LED-ów oraz podczerwonych kamer, które rzucają niewidzialne wzory na nasze oczy i dzięki temu odczytują je niesamowicie precyzyjnie – każda osoba, które miała okazję przetestować Vision Pro zwracała uwagę na to.

Zewnętrzne czujniki i kamery

Zewnętrzne czujniki i kamery odpowiedzialne są za śledzenie gestów naszych rąk i przez to, iż są kamery skierowane w dół, to nie musimy podnosić rąk przed twarz, aby gesty były rejestrowane prawidłowo – możemy je trzymać np. na udach. Poza tym muszą nie tylko rejestrować nasze otoczenie, aby te zostało odwzorowane na wewnętrznych Micro-LED-ach, ale również analizują kształt otoczenia, jakie przedmioty w nim są i z jakich materiałów je wykonano. Jest też kamera TrueDepth, znana z iPhone’ów z Face ID.

To wszystko po to, aby visionOS mógł rzucać odpowiednie cienie na nasze meble, żeby odpowiednio dostosował dźwięk przestrzenny do materiałów w naszym otoczeniu, żeby śledził ruch naszych dłoni i palców. Ten headset pod tymi względami nie ma sobie równych.

Optic ID

Do Touch ID i Face ID dołącza Optic ID – system rejestrujący tęczówkę naszego oka. Matematyczne odwzorowanie tęczówki jest trzymane w Secure Enclave na pokładzie układu M2. Secure Enclave to zamknięty „sejf”, do którego nikt nie ma dostępu, poza systemem weryfikującym naszą tożsamość, np. podczas płacenia kartą kredytową albo gdy logujemy się dzięki hasła zapisanego w iCloud Keychain. Informacje biometryczne, podobnie jak w przypadku Touch ID i Face ID, nie opuszczają urządzenia, na którym zostały stworzone, czyli nie ma ich Apple, ani nie wędrują przez internet.

Prywatność

W kwestii prywatności naszego otoczenia i ruchów naszych oczu – te dane nie są widziane przez aplikacje ani firmy trzecie, ani nie są nigdzie wysyłane.

Na koniec

Vision Pro zapowiada się na naprawdę niesamowite urządzenie, wyposażone w najnowsze technologie, co jest odzwierciedlone ceną. jeżeli jednak spojrzymy na „konkurencyjne” i jeszcze droższe headsety od firmy Varjo, to gwałtownie okazuje się, iż Vision Pro ma możliwości i taką integrację z ekosystemem Apple, iż jeszcze długo nie będzie bezpośredniej konkurencji w tak mnogiej liczbie zastosowań.

Do premiery jeszcze zostało wiele miesięcy i wiele może się zmienić. Nie mogę się już doczekać, aż będę mógł to założyć na głowę i doświadczyć tego osobiście.

2 lat temu

2 lat temu