Nowa klasa modeli tego powodu

Modele rozumowania to nowa klasa dużych modeli językowych (LLMS) które spędzają więcej czasu w „myśleniu” i „odzwierciedleniu” pracy poprzez złożone problemy, opisując kroki wymagane do rozwiązania zadania. Podstawową zasadą jest to, iż każdy problem można rozwiązać dzięki głębokiego myślenia, rozumowania i czasu, podobnie jak to, jak ludzie rozwiązują problemy. Spędzając więcej czasu – a tym samym oblicz – na problem, LLM może przynieść lepsze wyniki. Zjawisko to znane jest jako skalowanie czasu testu, w którym model dynamicznie przydziela zasoby obliczające podczas wnioskowania do rozumu poprzez problemy. Modele rozumowania mogą ulepszyć doświadczenia użytkowników na komputerach PC, głęboko rozumiejąc potrzeby użytkownika, podejmowanie działań w ich imieniu i umożliwiając im przekazanie informacji zwrotnych na temat procesu myślowego modelu-wdrażanie agencyjnych przepływów pracy do rozwiązywania złożonych, wieloetapowych zadań, takich jak analiza badań rynku, wykonywanie wykonywania, wykonywanie skomplikowane problemy matematyczne, kod debugowania i wiele innych.

Różnica Deepseek

Rodzina modeli destylowanych DeepSeek-R1 oparta jest na dużym modelu 671 miliardów parametrów mieszanki eksploatacji (MOE). Modele MOE składają się z wielu mniejszych modeli ekspertów do rozwiązywania złożonych problemów. Modele DeepSeek dalej dzielą pracę i przypisują subtelnie mniejszym zestawom ekspertów. Deepseek zastosował technikę zwaną destylacją do zbudowania rodziny sześciu mniejszych modeli studentów-od 1,5-70 miliardów parametrów-od dużego modelu Deepeek 671 miliarda parametrów. Możliwości rozumowania większego modelu DeepSeek-R1 671-miliardowy parametrów zostały nauczane dla mniejszych modeli studentów LLamy i QWen, co skutkuje potężnymi, mniejszymi modelami rozumowania, które działają lokalnie na komputerach RTX AI z szybką wydajnością.

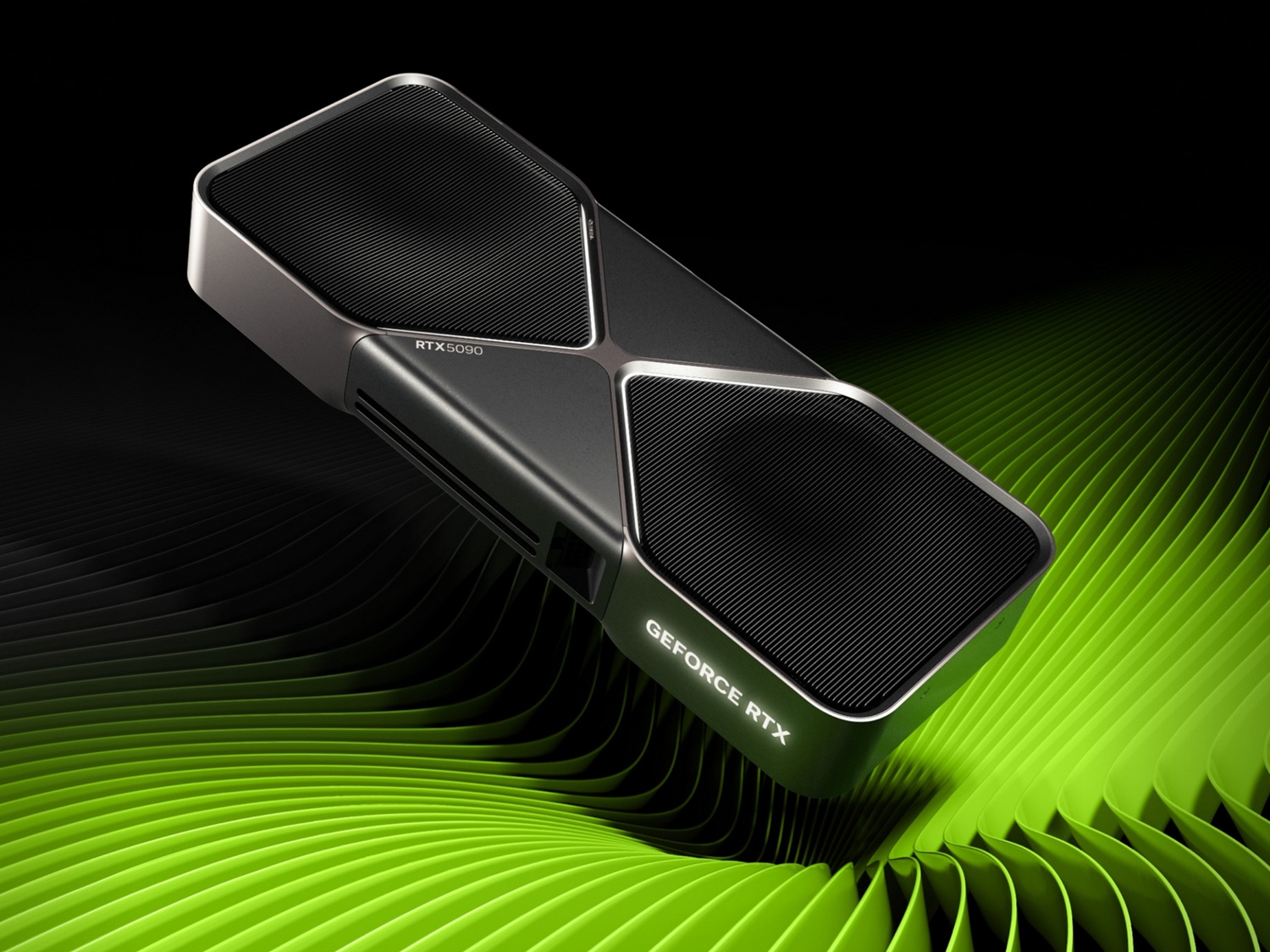

Szczytowa wydajność na RTX

Szybkość wnioskowania ma najważniejsze znaczenie dla tej nowej klasy modeli rozumowania. GPU z serii Geforce RTX 50, zbudowane z dedykowanych rdzeni tensorowych piątej generacji, oparte są na tej samej architekturze GPU Nvidia Blackwell, która napędza wiodącą na świecie innowacje AI w centrum danych. RTX w pełni przyspiesza Deepseek, oferując maksymalną wydajność wnioskowania na PCS.

Wydajność przepustowości destylowanej rodziny modeli DeepSeek-R1 w procesor GPU na PC:

Doświadcz Deepeek na RTX w popularnych narzędziach

Nvidia RTX AI Platform Oferuje najszerszy wybór narzędzi AI, zestawy i modele oprogramowania, otwieranie dostępu do możliwości DeepSeek-R1 na ponad 100 milionach komputerów AI NVIDIA RTX na całym świecie, w tym zasilanych procesorem graficznym GeForce RTX 50 Series. Wysoko wydajne procesory graficzne RTX sprawiają, iż możliwości AI zawsze są dostępne-nawet bez połączenia internetowego-i oferują niskie opóźnienia i zwiększoną prywatność, ponieważ użytkownicy nie muszą przesyłać wrażliwych materiałów ani wystawiać zapytania na usługę online.

Doświadcz siły komputerów AI DeepSeek-R1 i RTX poprzez rozległy ekosystem oprogramowania, w tym Llama.cppW OllamaW LM StudioW WszystkoJan.ai, Gpt4all i OpenWebui, do wnioskowania. Plus użyj Bezlotny Aby dopracować modele o niestandardowe dane.

![Recenzja Komputronik Ultimate R770 [J14]. Solidna maszyna z opcją rozbudowy](https://static.android.com.pl/uploads/2025/01/recenzja-komputronik-ultimante-r770-j14-15.jpg)