Rynek technologii komputerowych się zmienia, a nowe trendy wyłaniają zwycięzców i przegranych. Wśród tych ostatnich mogą znaleźć się już niedługo marki, które niegdyś postawiły na gaming.

Pamiętacie jeszcze czasy gdy to gaming napędzał rozwój technologii komputerowych? Z wypiekami na twarzy masy graczy czekały na nową generację procesorów czy układów graficznych, które obiecywały więcej klatek w coraz bardziej wymagających grach. Wówczas świat technologii komputerowych rzeczywiście był “CPU/GPU-centryczny”. To jednak odeszło do lamusa. Dziś to rozwoju nadają centra danych, coraz bardziej zaangażowane w obliczenia na potrzeby złożonych modeli AI.

Gdy gaming rósł jako jedyny

Nieco ponad dekadę temu sytuacja na rynku komputerów osobistych wydawała się nieco dziwna. Napęd do jej rozwoju nie spoczywał w środowisku korporacyjnym, ale na biurku zwykle młodego użytkownika konsumenckiego – gracza. Po 2011, rekordowym (ok. 365 mln sztuk komputerów) roku rynek komputerów zaczął hamować. W latach 2013 – 2018 nastąpiło zjawisko cokolwiek niecodzienne. Wówczas narracja brzmiała: “PC umiera, wszyscy przechodzą na mobile”, a jedynym bastionem, który przeczył tej tezie i generował marże dla takich firm jak Asus, MSI, Nvidia czy Intel, byli gracze. To wtedy producenci zaczęli masowo tworzyć submarki gamingowe (rozkwit ROG, Predator, Omen, Legion), widząc, iż to jedyna deska ratunku dla ich przychodów. Jon Peddie Research (JPR) raportował wtedy, iż o ile wolumen sprzedaży zwykłych “blaszaków” spadał, o tyle wartość rynku hardware’u dla graczy (High-End) rosła, przekraczając w 2016 roku pułap 30 mld dolarów globalnie. Inne lata w tym okresie miały podobną charakterystykę.

Gaming całkiem nieźle przeżył także czas pandemii. Ba, można wręcz powiedzieć, iż firmy, które zainwestowały w marki gamingowe we wcześniejszych latach, zyskały niezwykły zastrzyk przychodów. IDC raportowało, iż rok 2020 przyniósł największy wzrost sprzedaży komputerów od dekady (ponad 13% r/r), a rok 2021 zakończył się wynikiem blisko 350 mln sztuk (poziom niewidziany od 2012 r.). To również IDC jako pierwsze alarmowało o gwałtownym hamowaniu rynku w 2022 roku (spadki rzędu 15-20% w poszczególnych kwartałach). To samo załamanie w Q4 2022 roku Gartner nazwał „największym kwartalnym spadkiem w historii prowadzenia statystyk” (czyli od połowy lat 90.). Jon Peddie Research natomiast już pod koniec 2021 roku wskazywał na rodzący się wpływ nowego zjawiska na rynek jednego, kluczowego komponentu: kart graficznych.

Krypto kradnie karty

W 2022 roku doświadczyliśmy po raz pierwszy w takiej skali zjawiska, które było niezłym sygnałem zapowiadającym to, co widzimy obecnie. Tzw. kryzys GPU był napędzany popytem związanym z kryptowalutami. Ich “kopanie” polegało w znacznej mierze na GPU. Komponent stworzony z myślą o gamingu znalazł więc zastosowanie we wzbogacaniu się “kryptowalutowych inwestorów”. Mówiąc wprost: rozrywka musiała uznać wyższość zysku.

Ceny kart graficznych poszybowały wówczas w górę, przy jednoczesnym spowolnieniu całego rynku komputerów osobistych. Rynek w znacznym stopniu nasycił się komputerami podczas pandemii, a słupki sprzedaży w efekcie pozostawały zdecydowanie dalekie od imponujących.

Postpandemiczna korekta i odbicie na rynku

W 2022 i 2023 roku notowano historyczne spadki dostaw (nawet o 20-30% kwartał do kwartału). Wystąpienia szefów największych firm (Pata Gelsingera z Intela czy Jensena Huanga z Nvidii) podczas kwartalnych omówień wyników w latach 2023-2024 często zawierały frazę „Inventory Correction” (korekta stanów magazynowych) jako główną przyczynę słabszych wyników, co bezpośrednio potwierdzało tezę o nasyceniu rynku.

Rok 2023 byłby wyjątkowo słaby także na polskim rynku, ale sprzedaż w znaczącym stopniu uratował wówczas program “Laptop dla ucznia”, który został ogłoszony w maju, a początek realizacji był, oczywiście przypadkowo, zgodny z najgorętszym okresem kampanii wyborczej. Program zresztą rezonował na sprzedaż w latach kolejnych.

Pewnym wzmocnieniem był też jasny komunikat Microsoftu o zakończeniu wsparcia dla Windows 10 w październiku 2025 roku. Chociaż nowszy Windows 11 z trudem przebija 50% udziału w rynku, to jednak pewien naturalny cykl życia komputerów, także tych kupowanych masowo w czasie pandemii, pomaga w utrzymaniu rozsądnych wyników sprzedaży.

AI = koniec tanich komponentów

Jednak to nie system operacyjny, nie wymiana liczących już sobie około 5 lat “pandemicznych” maszyn, a już na pewno nie gaming (do czego jeszcze wrócę), są głównymi architektami rynku PC w 2026 roku. Tenże architekt narodził się pod koniec 2022 roku i, chociaż z początku niepozorny, dziś jest niekwestionowanym czynnikiem numer jeden. Mowa oczywiście o boomie na AI, który swój początek zaliczył wraz z premierą ChataGPT. AI oczywiście istniało już wcześniej, ale dopiero masowe i konsumenckie zastosowania, jakie przyniosły LLMy uruchomiły prawdziwą popularność.

Dziś AI odciska piętno na każdym obszarze życia i pracy. Chociaż wciąż zwykle robi to pośrednio, trudno nie zauważyć tego kolosalnego wpływu. Patrząc natomiast ze strony czysto technicznej, nietrudno zadać sobie pytanie: ile infrastruktury potrzeba, aby ludzie na całym świecie mogli korzystać z popularnych LLMów? Odpowiedź: dużo, bardzo dużo, a z czasem coraz więcej.

Rosnące zapotrzebowanie ze strony AI jest wieloaspektowe: potrzeba coraz więcej energii elektrycznej, wody (do chłodzenia wzrastających centrów danych), przestrzeni, ale też komponentów, zwłaszcza układów graficznych. To właśnie te ostatnie są przyczyną problemów producentów kart graficznych. Brzmi mało logicznie? Już tłumaczę.

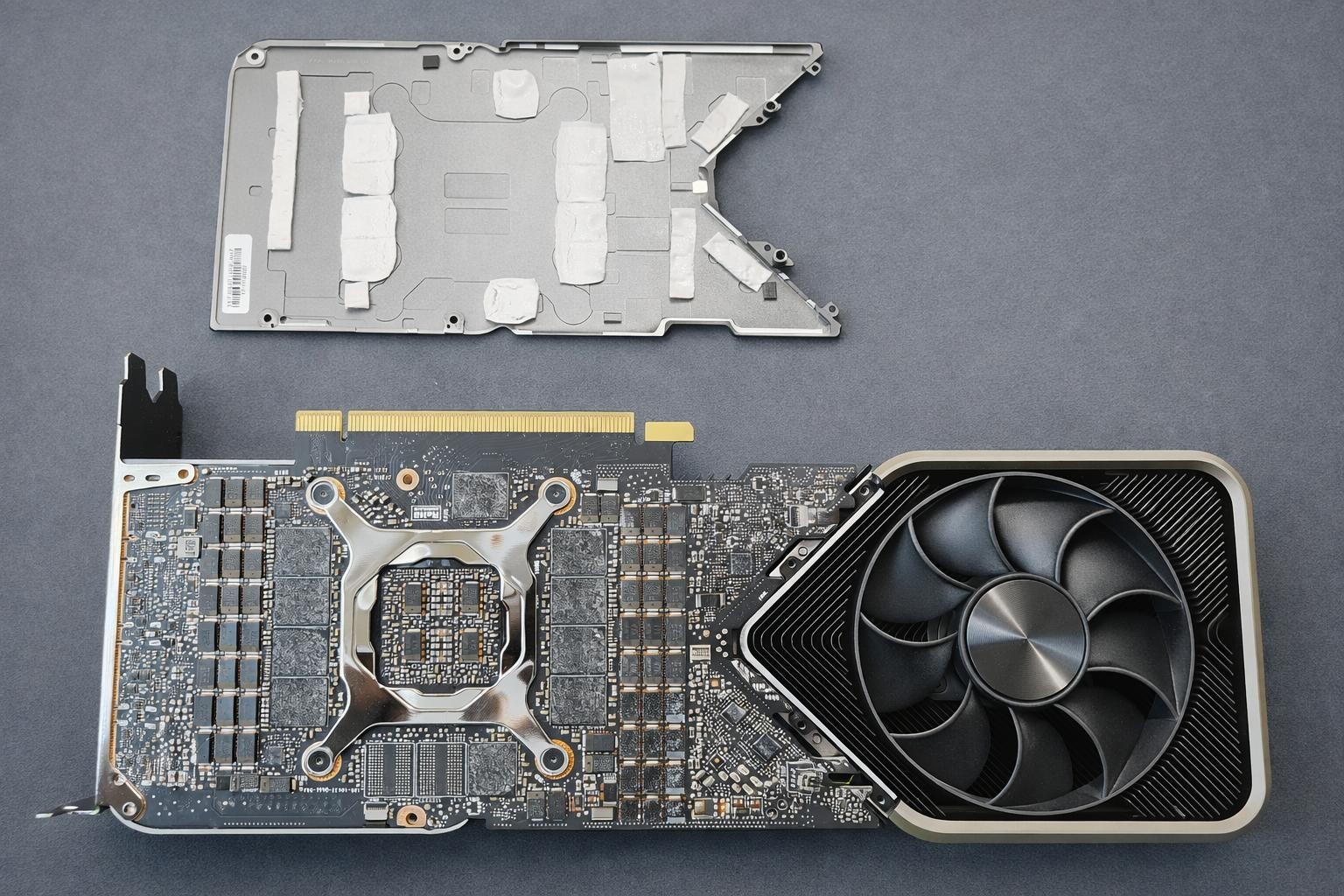

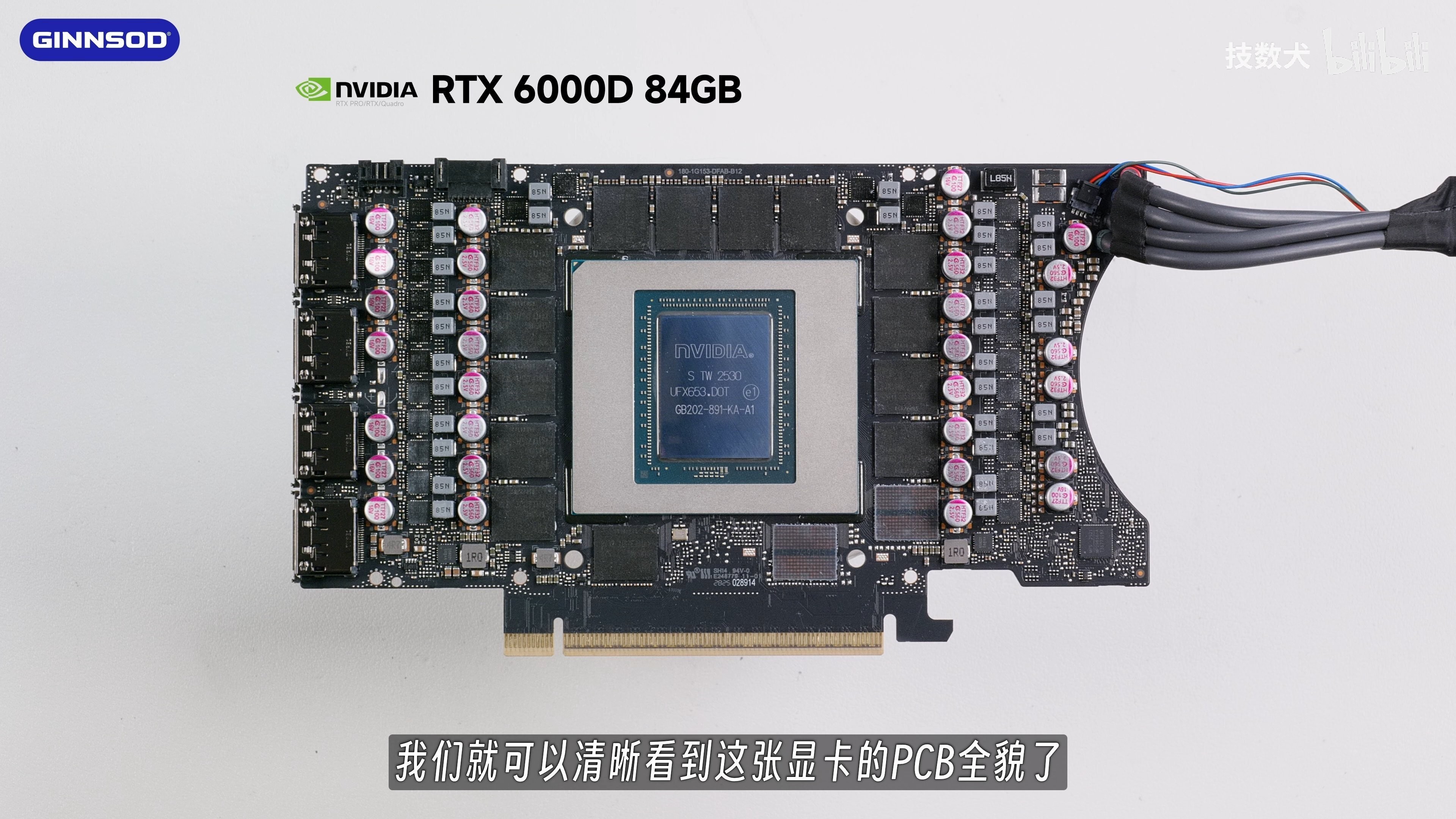

Otóż popularne, konsumenckie karty graficzne budowane są przez firmy, które wytwarzają je na mocy umów z dostawcami chipów GPU (AMD i NVIDIA) oraz pamięci, których karta potrzebuje by móc np. przechowywać tekstury. Owe pamięci mają na ogół formę zgrupowanych na jednej lub obu stronach płytki PCB kości typu GDDR kolejnych generacji. To szybkie pamięci o stosunkowo niewielkiej pojemności, idealne do pracy z grafiką 3D. Ich wada? Są dość danie. Przynajmniej w porównaniu do modułów HBM.

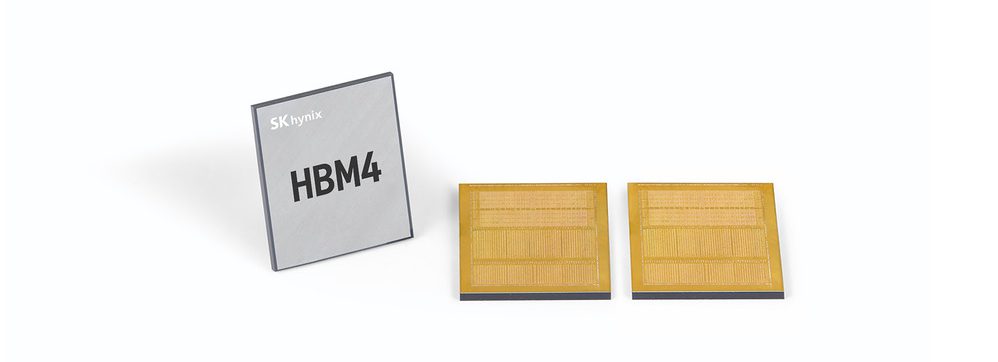

Dla wytwórców pamięci, a więc firm Micron, SK Hynix i Samsung, znacznie korzystniejszym jest produkowanie wspomnianych już HBM’ów. Czym są te pamięci? To przede wszystkim pamięć stosowana w akceleratorach AI, takich jak Nvidia H100 czy AMD Instinct MI210. Karty te są produkowane na zlecenie twórców GPU lub producentów serwerów (jak Dell czy HPE). W praktyce więc, producenci kart graficznych znanych konsumentom (ASUS, MSI, Gigabyte, Zotac, Sapphire itd.) nie czerpią zysków z tego biznesu. A ten jest dochodowy znacznie bardziej niż produkcja kolejnych generacji pamięci GDDR. Stąd też przestawienie się linii produkcyjnych czołowych dostawców pamięci na wytwarzanie HBM’ów.

W praktyce, oznacza to sytuację, w której dostawy pamięci innych typów (GDDR, RAM, NAND) zaczynają topnieć. O ile część z nich może być zapewniona przez mniejszych dostawców (jak tajwańska Nanya czy chiński CXMT), tak układy typów GDDR6 i GDDR7, stosowanych w aktualnych generacjach kart graficznych typów konsumenckich, może po prostu zabraknąć. Ich odbiorcą jest bowiem gracz – konsument, a więc element rynku, którego interes jest ostatecznie na samym końcu. Na pierwszym miejscu znajdują się bowiem inwestorzy w akcje big techów.

A te dziś żyją z AI. Czy raczej z udostępniania mocy obliczeniowej na potrzeby AI, zwłaszcza trenowania modeli, w tym własnych. Potęgi Microsoftu, OpenAI, Anthropic czy Google stoją dziś na setkach tysięcy akceleratorów AI, z których każdy wykorzystuje układy pamięci typu HBM. Większość z owych akceleratorów to dzieło Nvidii, która jest dziś jednym z największych beneficjentów boomu AI i zwyczajnie nie potrzebuje zysków z innych obszarów rynku. Są one zwyczajnie zbyt małe.

Co dalej z rynkiem kart graficznych?

Co zatem czeka producentów kart graficznych? Tego nie wiem. Mogę pobawić się w spekulacje. Zakładam, iż ci z nich, których działalność jest bardziej zdywersyfikowana, jak w przypadku ASUS, MSI czy Gigabyte, poradzą sobie z trudnym okresem i, chociaż poobijani, wyjdą z niego cało. Co do marek mniejszych, jak PNY, Inno3D, Gainward, Zotac, Sapphire, Palit, XFX czy PowerColor… cóż, nie zwiastuję niczego dobrego. Chociaż każda z tych firm posiada w portfolio coś więcej niż tylko “grafiki”, tak są to raczej kategorie poboczne. Niska dywersyfikacja portfolio może oznaczać poważne problemy i, zapewne, upadek części z mniejszych brandów.

A co z graczami? Tu sprawa jest chyba jaśniejsza: poradzą sobie. Chociaż, jak sądzę, w inny sposób niż dotychczas. Zamiast polegać na nieopłacalnej rozbudowie domowego PC, mogą skierować się w stronę streamingu. Już teraz doświadczenie użytkownika płynące z GeForce Now w wydaniu płatnym nie różni się specjalnie od uruchamiania gier na własnym komputerze. Abonamenty wyższych poziomów staną się niejako koniecznością dla graczy. Beneficjentem tego stanu będzie, ponownie, Nvidia. Paradoksalnie, brak dostępności kart graficznych opartych na układach tego producenta przyniesie mu realne, wymierne zyski.

Pozostanie oczywiście grupa entuzjastów esportu, gdzie streaming nie wchodzi w grę, oraz pewna pula graczy, którzy zadowolą się przez kilka lat posiadanym na biurku PC. Rozwój wymagań sprzętowych gier nie jest dziś tak szybki jak dekadę czy dwie temu, a w efekcie kilkuletni, mocny w momencie premiery, komputer, przez cały czas może radzić sobie przynajmniej znośnie.

Jak będzie w praktyce, zobaczymy. Nie mam jednak wątpliwości, iż wygranym będzie Nvidia, a przegranym konsument. Takie prawo rynku.

2 godzin temu

2 godzin temu