Układy Ryzen 8000 są oczywiście szybsze i sprawniejsze od swoich poprzedników z ubiegłej generacji. Rzucają też istotne wyzwanie pod tym względem konkurencji, głównie Intelowi. Ale to wszystko nieważne. Przynajmniej takie można było odnieść wrażenie podczas premiery. Chipy te mają bowiem zaoferować coś jeszcze istotniejszego.

Czym charakteryzuje się dobry układ centralny dla PC (celowo unikam mikroprocesor, bowiem już dawno jego rola wykracza poza CPU)? Ma oferować jak najwyższą wydajność obliczeniową przy stosunkowo niewielkim zużyciu energii i emisji ciepła. To na swój sposób zabawne, ale przede wszystkim bardzo znamienne, iż o tych parametrach AMD przy okazji premiery Ryzenów 8000 mówiło najmniej.

Znaczy się, w teorii przynajmniej, nic z tymi osiągami nie jest nie tak. Nie zabrakło informacji o wynikach w benchmarkach (o których szerzej w dalszej części materiału), a z tych wynika, iż nowe Ryzeny są nie tylko lepsze od modeli z serii 7000 – co nie powinno być zaskoczeniem – ale też, co dużo ciekawsze, podobno są istotnie lepsze od odpowiedników ze strony Intela. Tyle iż o tych osiągach przedstawiciele firmy mówili najmniej. Skupili się przede wszystkim na koprocesorze, czyli module NPU. I nic dziwnego.

Na trwającej właśnie rewolucji SI najwięcej zyskują wielkie korporacje. AMD chce wyrównać szanse, a układy Ryzen 8000 to pierwszy krok w tym kierunku. No dobrze, w sumie to drugi. Znaczy się, trzeci.

Lisa Su, prezes AMD, na premierze układów Ryzen 8040 w San Jose. Spider’s Web jest obecny na tym wydarzeniu

Lisa Su, prezes AMD, na premierze układów Ryzen 8040 w San Jose. Spider’s Web jest obecny na tym wydarzeniuTermin sztuczna inteligencja jest dziś stanowczo nadużywany – wszak opisuje znacznie więcej zjawisk, niż podbijająca przebojem rynek GenAI, czyli generatywna SI. Nie zmienia to jednak faktu, iż GenAI jest w trakcie transformacji całej branży IT. I wielu innych. Tyle iż na dziś niemal w każdym przypadku usługi oparte o GenAI służą przede wszystkim wielkim korporacjom, które są za nie odpowiedzialne. Dopiero przy okazji ich klientom, korporacyjnym i indywidualnym. Niemal każda usługa oparta o GenAI hostowana jest w chmurze publicznej, a znaczna część tych usług wykorzystuje dane użytkowników do samodoskonalenia się.

To oczywiście nie wynika z jakiegoś Niecnego Złowrogiego Planu Dominacji Nad Światem, a ze zwykłych realiów. Na dziś modele SI napędzające te usługi wymagają bardzo dużej mocy obliczeniowej i cyfrowych zasobów – więc hostowanie ich lokalnie byłoby w większości przypadków skrajnie nieefektywne. Ale czy aby na pewno?

AMD bardzo chce tu przejąć miano lidera innowacji, ale niestety miano to należy się Apple’owi. To właśnie Apple uznał wprowadzenie NPU – koprocesorów akcelerujących przeliczenia związane z uczeniem maszynowym i sztuczną inteligencją – do sprzedawanych konsumentom komputerów za dobry pomysł. Efekty widać: oprogramowanie wykorzystujące Apple Neural Engine działa znacznie sprawniej i szybciej na komputerach Mac, a wbudowane w Apple Silicon NPU w wydajny sposób akcelerują przeliczenia, najczęściej na komputerach Mac związane z obróbką multimediów.

AMD jest drugą firmą, która wprowadziła komputery z NPU dla mas. Mówi, iż jest pierwszą – ale chodzi tu o świat układów x86. Za to w istocie już w ubiegłym roku można było kupić komputery z układami Ryzen 7000, które zawierały wbudowane NPU. Fakt faktem kilka z tego wynikało, bowiem w świecie PC z Windowsem twórcy gier i aplikacji dopiero się budzą z wdrażaniem obsługi NPU do swoich produktów, przez co użytkownicy tych komputerów mogli rzeczone NPU docenić tylko za sprawą… lepszej jakości wideorozmów. Ryzen 7000 miał być poligonem doświadczalnym, zaś Ryzen 8000 traktowany jest jako dojrzały produkt. Rynkowy debiut, jeżeli zignorujemy minioną nibytestową generację i Apple’a. Należy też wspomnieć, iż Intel z opóźnieniem, ale też wdrożył NPU do swoich układów, od dawna robi to też Qualcomm.

AMD to nie wszystko w świecie procesorów. Nie przegap tych tekstów:

Po co NPU w twoim PC? Chodzi o więcej niż tylko wyższa wydajność.

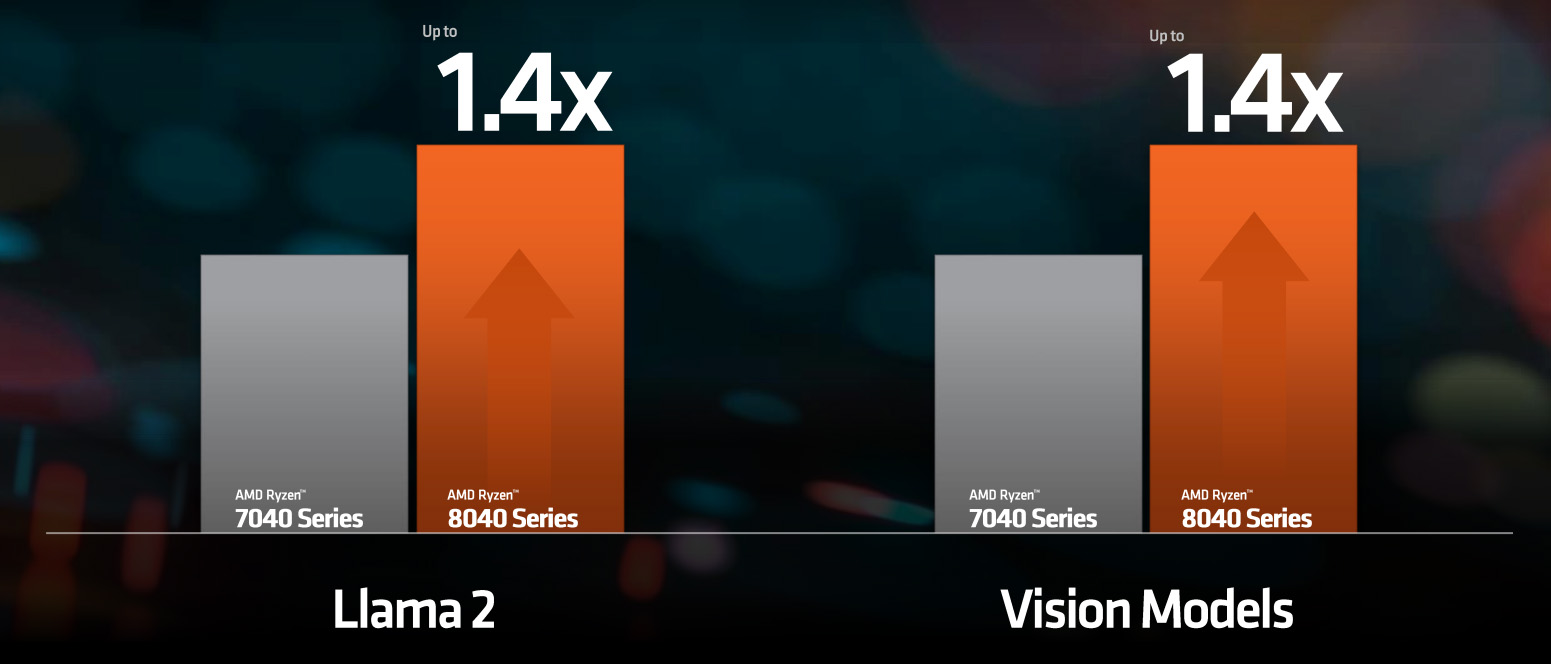

Ryzen 7000 kontra Ryzen 8000 – wydajność NPU (źródło: AMD)

Ryzen 7000 kontra Ryzen 8000 – wydajność NPU (źródło: AMD)Choć oczywiście również i o wydajność chodzi. Samo NPU zostało opracowanę przez firmę Xilinx, którą AMD przejął niespełna dwa lata temu. Ryzen 8040 na samym tylko NPU oferuje wydajność 16 TOPS (tera operations per second), a gdy dołączyć do tego wbudowane GPU i CPU w testach osiąga wynik 39 TOPS. Dla porównania, wyniki Ryzena 7040 to 10 TOPS i 33 TOPS. Podobnież w przetwarzaniu dużego modelu językowego LLAMA 2 i Vision Models (ResNet50 i Inception v4) jest o 1,4 wydajniejszy niż poprzednik.

Nie bez powodu AMD podaje wyniki zarówno gołego NPU, jak i całego układu. Ryzen 8040 jest bowiem zbudowany tak, by wszystkie jego elementy składowe w jakiś sposób akcelerowały przeliczenia związane z SI i ML. Zawarte w Ryzenie 8040 CPU o architekturze Zen 4 przetwarza bardzo użyteczny w kontekście tych przeliczeń zestaw instrukcji AVX 512 VNNI. Nie należy też zapominać o wbudowanym GPU, od którego zaczął się szał na sprzętową akcelerację uczenia maszynowego – w nowym chipie AMD znaleźć można Radeona o mikroarchitekturze RDNA 3.

Drugim z powodów, jaki podaje AMD, jest ochrona prywatności. Co prawda zagrożenie z tym związane jest znikome, gdy użytkownik pyta ChatGPT o wspaniały przepis na zupę cebulową. Problem zaczyna się, gdy użytkownik chce wykorzystać GenAI do pracy. Zdarzały się już przypadki, gdy model SI zasysał dane użytkowników biznesowych i się z nich uczył. Dane poufne, które nigdy nie powinny trafić do innych. Lokalne przetwarzanie SI gwarantuje, iż żaden zewnętrzny podmiot nie przywłaszczy sobie danych użytkownika.

Trzecim są koszty. Usługi oparte o SI, które są hostowane w chmurze, to często usługi płatne, rozliczane w ramach cyklicznego abonamentu. W niektórych zastosowaniach znacznie sensowniejszym będzie jednorazowy wydatek na sprzęt, którego koszt użytkowania będzie znacznie niższy niż cykliczne opłaty.

Czwartym jest wymóg stałej łączności z chmurą, co nie zawsze jest możliwe. Fakt faktem prawdopodobnie mowa tu o marginalnych przypadkach, z uwagi na wszechobecność Internetu, nietrudno jednak wyobrazić sobie sytuację, w której użytkownik potrzebuje skorzystać z systemu GenAI, a na przykład w danej chwili pracuje w samolocie i nie może się połączyć z siecią.

Piątym, o którym AMD nie wspomniał, jest fakt, iż firmie rozwój w ramach małych firm czy choćby entuzjastów jest bardzo na rękę. Firma zarabia co prawda ponoć kosmiczne pieniądze na swoich akceleratorach Instinct i układach Epyc, masowo kupowanych przez operatorów centrów danych. przez cały czas jednak dostaje na tym polu łupnia od Nvidii, która na tym korporacyjnym rynku zarabia dużo, dużo więcej. Tak zwane market disruption leży tu ściśle w interesie AMD. Dobrze się składa, iż to również interes użytkowników.

Do czego przyda się nowe, jeszcze lepsze NPU? Gdzie są aplikacje na Windowsa i Linuxa? AMD ma plan.

Podczas prezentacji przedstawiciel AMD ujął wprost, chyba choćby lekko sarkastycznie, iż w świecie dużych firm programistycznych, jak się okazuje, trzeba odbyć bardzo wiele wizyt. Na szczęście rzeczone wizyty przyniosły efekty. Firma zapowiedziała, iż coraz więcej systemu Microsoftu, Adobe, Zooma, Bytedance’a (właściciel TikToka) ma właśnie wdrażaną obsługę NPU według otwartych standardów, właśnie pod naciskiem firmy. Otwarte standardy oznaczają implementacje, które mogą działać również na układach Intela i Qualcomma. A rzeczone wdrożenia najczęściej polegają na przekierowaniu obliczeń do NPU, które wcześniej były kierowane do GPU.

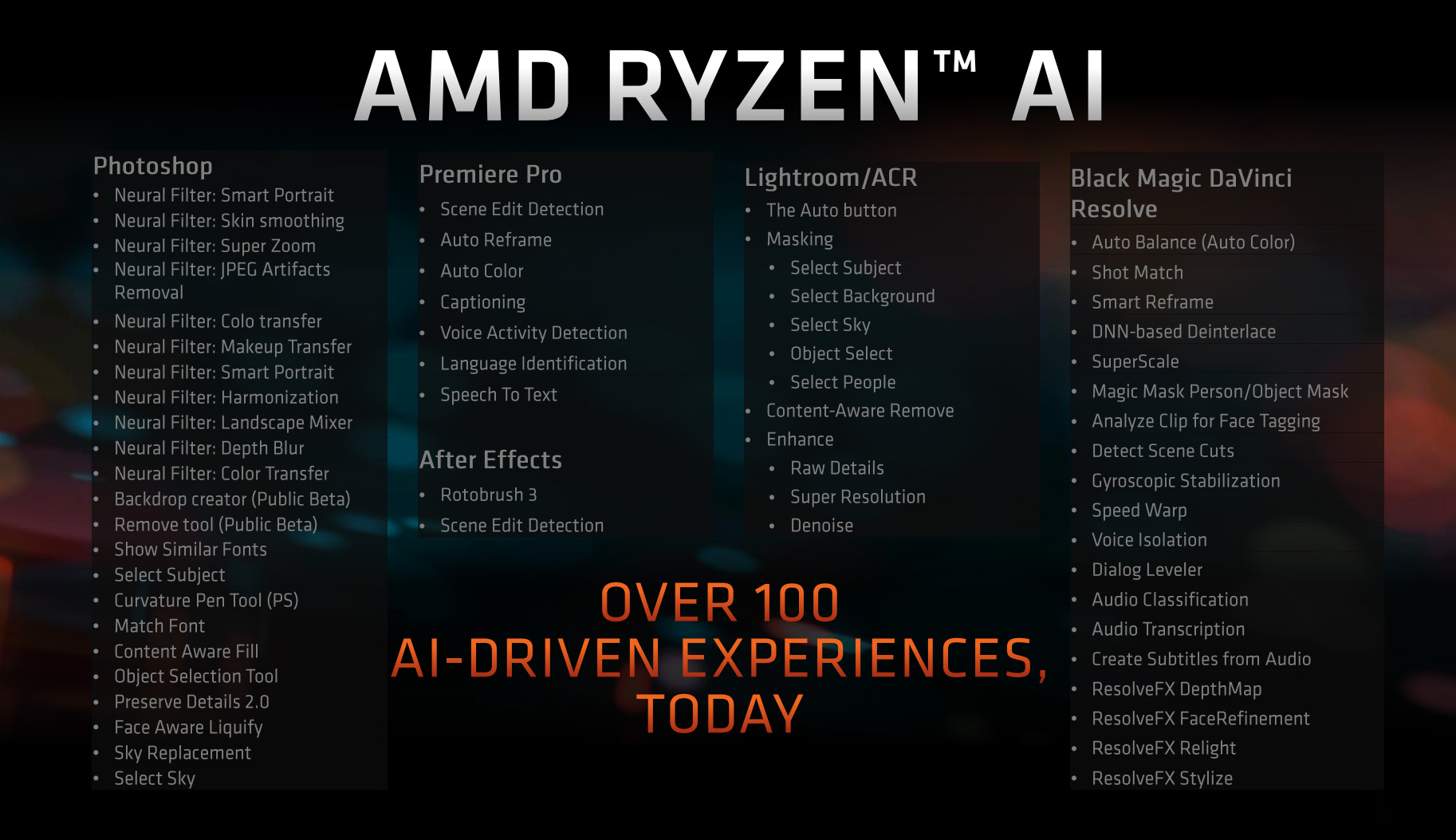

AMD chwali się rosnącą ilością oprogramowania, które obsługuje akcelerację przeliczeń SI

AMD chwali się rosnącą ilością oprogramowania, które obsługuje akcelerację przeliczeń SIEfekty widać, przynajmniej na demonstracjach od AMD. Filtry neuronowe Photoshopa, automatyczne wykrywanie elementów w Premiere Pro, automatyczne mechanizmy Lightrooma czy inteligentne funkcje edycji DaVinci Resolve działały nieporównywalnie szybciej, zużywając przy tym ponoć mniej energii. To oznacza, iż już dziś (no dobrze, od początku przyszłego roku w większości przypadków) kupno komputera z Ryzenem 8000 zapewni wymierne korzyści u niektórych użytkowników.

A co z mniejszymi firmami deweloperskimi? AMD przecież ich wszystkich nie odwiedzi. Firma ma dwie wzajemnie się uzupełniające strategie. Po pierwsze, swoista gamifikacja rozwoju aplikacji przez rozmaite konkursy na wdrożenia do aplikacji obsługi NPU. Po drugie: zapewnienie tym deweloperom jak najlepszych narzędzi do pracy. Oczywiście open-source’owych i kompatybilnych z innym sprzętem i standardami.

Najważniejszym będzie tu prawdopodobnie AMD Ryzen AI Software Platform, czyli kompleksowe narzędzie dla programistów, którzy chcą integrować modele uczenia maszynowego z aplikacjami. Platforma ta pozwala programistom na uruchamianie modeli uczenia maszynowego wytrenowanych w ramach PyTorch lub TensorFlow. Platforma ta wspiera kwantyzację modeli do formatu INT8 i zapisywanie ich w formacie ONNX. Można również korzystać z Microsoft Olive, z kwantyzatorem Vitis AI jako wtyczką.

dr Lisa Su i Pavan Davuluri, CVP działu PC w Microsofcie

dr Lisa Su i Pavan Davuluri, CVP działu PC w MicrosofcieCzy to wystarczy? Nie sposób przewidzieć. Strategia wydaje się jednak słuszną. Zacząć od dużych firm, by te dały przykład – a tym mniejszym zapewnić możliwość upgrade’u przy jak najniższym możliwym koszcie.

Ja bardzo przepraszam, to wszystko z SI pięknie i ładnie, ale czy Ryzen 8000 jest szybki? Czy na laptopie z Ryzenem 8040 pójdzie GTA i nie będą zamulać apki?

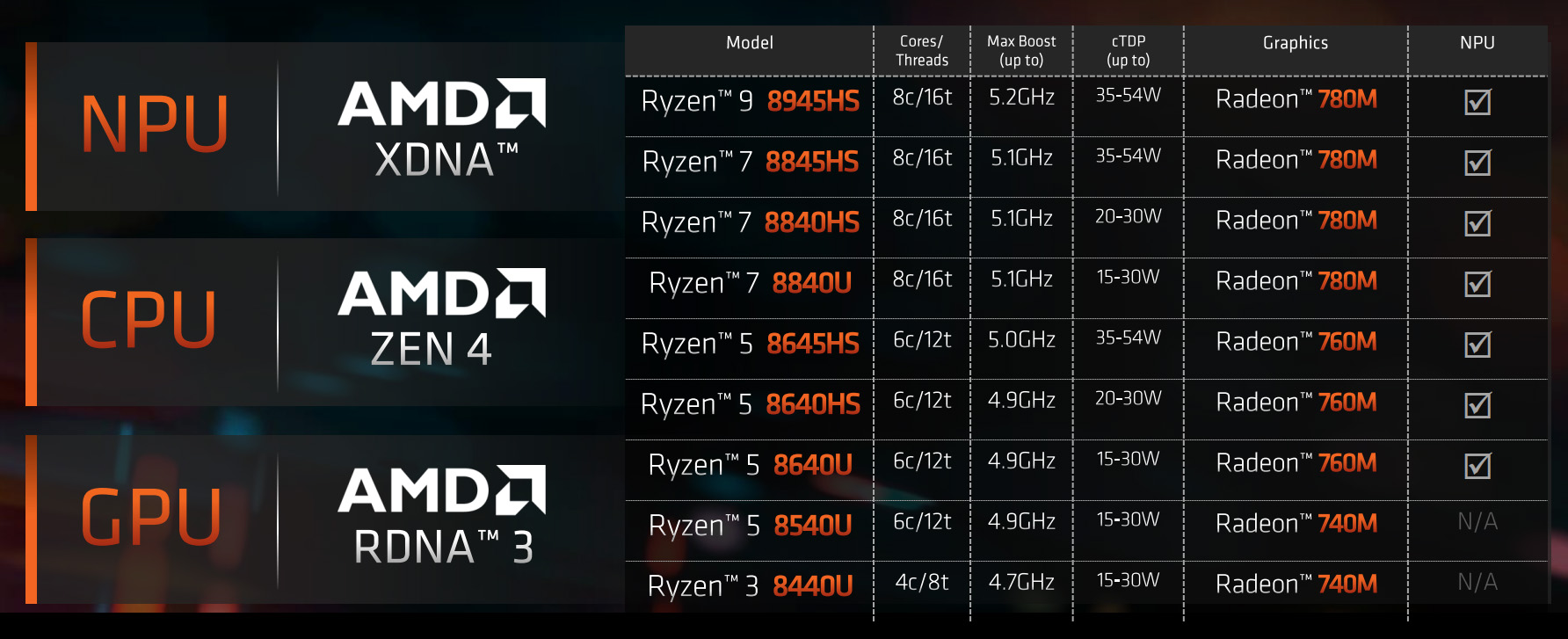

AMD Ryzen 8040 – modele

AMD Ryzen 8040 – modeleRyzen 8040 będzie oferowany w następujących wariantach:

- Ryzen 9 8945HS z ośmioma dwuwątkowymi rdzeniami, taktowany z częstotliwością do 5,2 GHz, o TDP 35-54W, z Radeon 780M GPU i z NPU XDNA;

- Ryzen 7 8845HS z ośmioma dwuwątkowymi rdzeniami, taktowany z częstotliwością do 5,1 GHz, o TDP 35-54W, z Radeon 780M GPU i z NPU XDNA;

- Ryzen 7 8840HS z ośmioma dwuwątkowymi rdzeniami, taktowany z częstotliwością do 5,1 GHz, o TDP 20-30W, z Radeon 780M GPU i z NPU XDNA;

- Ryzen 7 8840U z ośmioma dwuwątkowymi rdzeniami, taktowany z częstotliwością do 5,1 GHz, o TDP 15-30W, z Radeon 780M GPU i z NPU XDNA;

- Ryzen 5 8645HS z sześcioma dwuwątkowymi rdzeniami, taktowany z częstotliwością do 5 GHz, o TDP 35-54W, z Radeon 760M GPU i z NPU XDNA;

- Ryzen 5 8640HS z sześcioma dwuwątkowymi rdzeniami, taktowany z częstotliwością do 4,9 GHz, o TDP 20-30W, z Radeon 760M GPU i z NPU XDNA;

- Ryzen 5 8640U z sześcioma dwuwątkowymi rdzeniami, taktowany z częstotliwością do 4,9 GHz, o TDP 15-30W, z Radeon 760M GPU i z NPU XDNA;

- Ryzen 5 8640U z sześcioma dwuwątkowymi rdzeniami, taktowany z częstotliwością do 4,9 GHz, o TDP 15-30W, z Radeon 740M GPU;

- Ryzen 3 8440U z czterema dwuwątkowymi rdzeniami, taktowany z częstotliwością do 4,7 GHz, o TDP 15-30W, z Radeon 740M GPU.

Jak widać dwa układy z linii są rzeczonego NPU pozbawione. A jak z samą wydajnością?

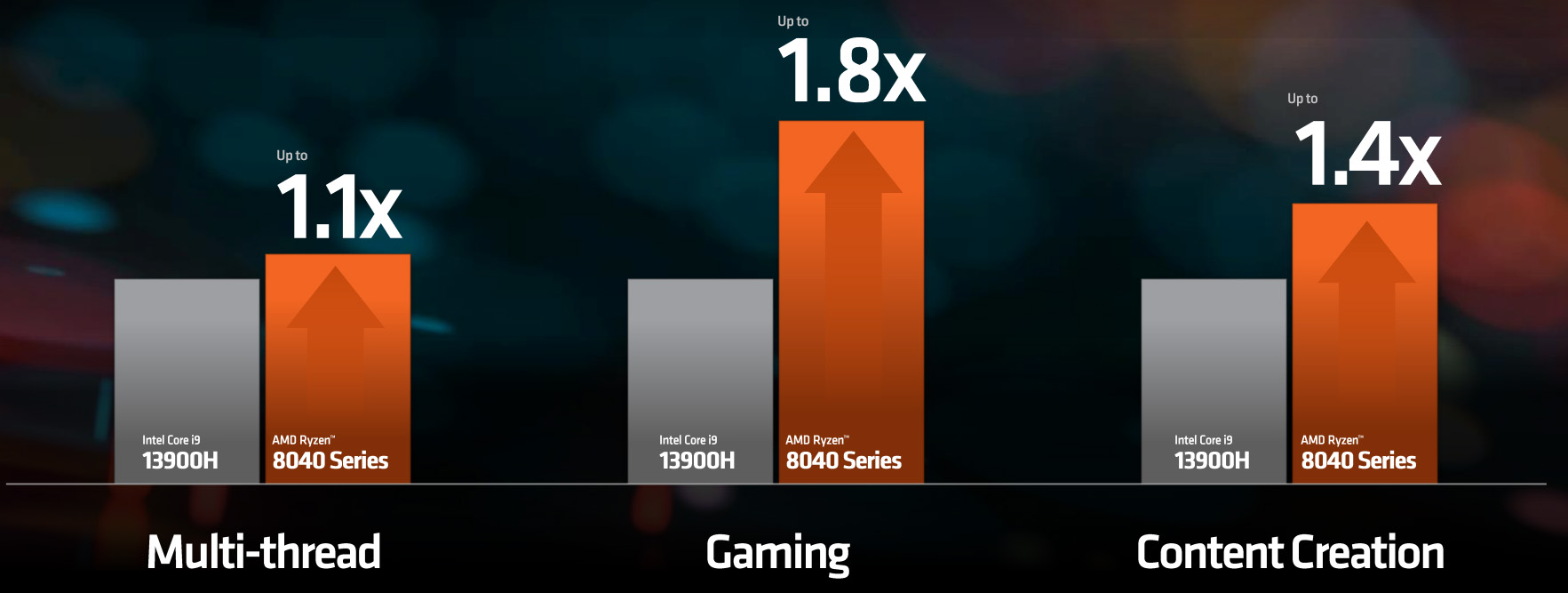

AMD podało pomiary dla komputera z Ryzenem 9 8940H z 16 GB RAM, pamięcią Samsung 980 Pro NVMe i Windowsem 11, porównując je z PC z Intelem Core i9-13900H, 16 GB RAM i pamięcią SSD. Sprawdzono wydajność w grach (na niskich ustawieniach i w 1080p) Borderlands 3. F1 2022, Far Cry 6, Grand Theft Auto 5, Hitman 3, League of Legends, Shadow of the Tomb Raider, Tiny Tinas Wonderland I WoTenCore. A także w oprogramowaniu Blender, POVRay, Handbrake, LAME, Davinci Resolve, Photoshop, PCMark 10, Cinebench R23 i Geekbench 6.

Ryzen 9 z linii 8040 kontra Intel Core i9-13900H (źródło: AMD)

Ryzen 9 z linii 8040 kontra Intel Core i9-13900H (źródło: AMD)Z takiego porównania wyszło, iż PC z wskazanym układem AMD jest 1,1 raza szybszy od komputera z wskazanym układem Intela w obliczeniach wielowątkowych, 1,8 raza szybszy w grach i 1,4 raza szybszy w aplikacjach do tworzenia treści. Dość ogólne porównanie, ale dające budzący dużo entuzjazmu obraz sytuacji. Szczegółowe pomiary są już wyraźnie zadaniem dla naszej redakcji, gdy dotrą do nas pierwsze komputery z nowymi Ryzenami.

AMD podkreśla, iż Ryzen 8040 to dopiero początek czegoś znaczenie większego.

Pierwsze komputery z Ryzenem 8040 pojawią się w sprzedaży w pierwszym kwartale przyszłego roku. Ale również w 2024 r., prawdopodobnie w drugiej jego połowie, pojawią się pierwsze układy o nazwie tymczasowej Strix Point. Zawierać będą XDNA 2, czyli NPU kolejnej generacji, które ma być aż trzykrotnie wydajniejsze od tego, które można znaleźć w bieżących czipach.

Demokratyzacja dostępu do AI to nie jest misja charytatywna ze strony AMD, a bardzo zmyślny pomysł jak ominąć dominację Nvidii na rynkach korporacyjnych. Firma odnosi sukcesy na tymże rynku korpo, ale znacznie mniejsze niż jego bezpośredni konkurent – przynajmniej w zakresie akceleratorów AI, takich jak AMD Instinct. Dlatego też odrobiła lekcje z historii IT, w której za każdym razem dominacja zabetonowanego na najbardziej majętnych klientów rynkowego lidera obchodziły młode startupy z ofertą dla użytkownika masowego i małych firm.

Na szczęście na tym korzystamy my, użytkownicy – zwłaszcza iż AMD wybiera drogę open-source i wszelkie innowacje, w jakie tu inwestuje, będą mogły być w pewnym zakresie wykorzystane na produktach konkurencji. Wykluczenie Big Techów z usług opartych o GenAI to oczywiście mrzonka, tym niemniej AMD podało dość powodów, by mieć komputer z NPU i nie polegać wyłącznie na aplikacjach SI hostowanych w chmurze.