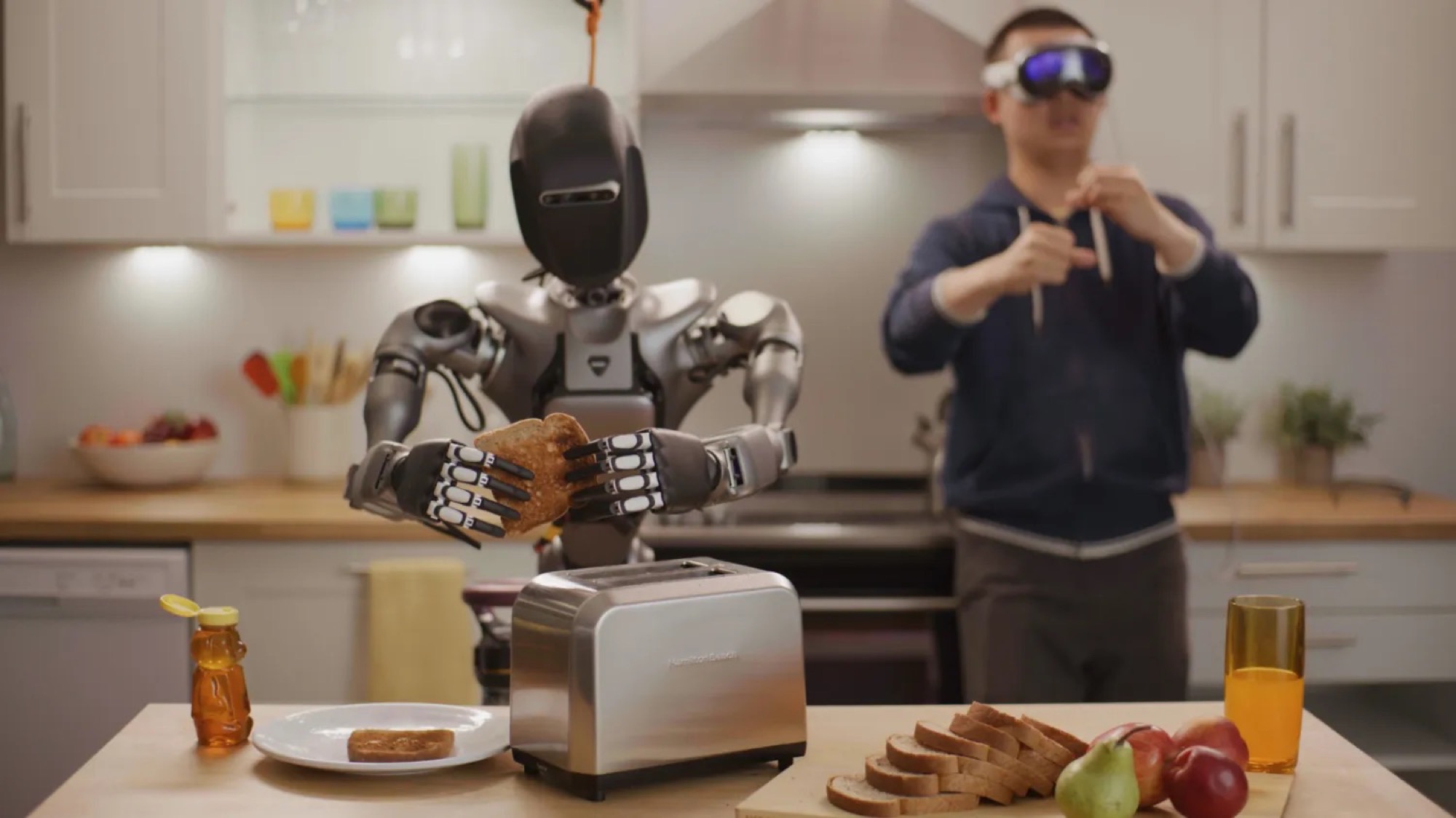

NVIDIA wykorzystuje zestaw Apple Vision Pro do rejestrowania zdalnych demonstracji i kontrolowania robotów humanoidalnych.

Proces ten obejmuje użycie Vision Pro do nagrywania teleoperowanych demonstracji, które są następnie symulowane w NVIDIA Isaac Sim.

Dane te są przetwarzane przez mikroserwis MimicGen NIM do generowania syntetycznych zbiorów danych.

Training foundation models for humanoid robots requires an incredible amount of data. One way of capturing human demonstration data is using teleoperation, but this is becoming an increasingly expensive and lengthy process.

An NVIDIA AI- and Omniverse-enabled teleoperation reference workflow, demonstrated at the SIGGRAPH computer graphics conference, allows researchers and AI developers to generate massive amounts of synthetic motion and perception data from a minimal amount of remotely captured human demonstrations.

First, developers use Apple Vision Pro to capture a small number of teleoperated demonstrations. Then, they simulate the recordings in NVIDIA Isaac Sim and use the MimicGen NIM microservice to generate synthetic datasets from the recordings.

The developers train the Project GR00T humanoid foundation model with real and synthetic data, enabling developers to save time and reduce costs. They then use the Robocasa NIM microservice in Isaac Lab, a framework for robot learning, to generate experiences to retrain the robot model. Throughout the workflow, NVIDIA OSMO seamlessly assigns computing jobs to different resources, saving the developers weeks of administrative tasks.

Oświadczenie NVIDIA:

Trening modeli fundamentalnych dla robotów humanoidalnych wymaga niesamowitej ilości danych. Jednym ze sposobów przechwytywania danych demonstrujących człowieka jest wykorzystanie teleoperacji, ale staje się to coraz bardziej kosztownym i długotrwałym procesem.

Referencyjny przepływ pracy dla teleoperacji z obsługą NVIDIA AI i Omniverse, zademonstrowany na konferencji grafiki komputerowej SIGGRAPH, pozwala badaczom i twórcom sztucznej inteligencji generować ogromne ilości syntetycznych danych dotyczących ruchu i percepcji z minimalnej ilości zdalnie przechwyconych ludzkich demonstracji.

Po pierwsze, deweloperzy używają Apple Vision Pro do przechwytywania niewielkiej liczby teleoperowanych demonstracji. Następnie symulują nagrania w NVIDIA Isaac Sim i wykorzystują mikrousługę MimicGen NIM do generowania syntetycznych zestawów danych z nagrań.

Deweloperzy szkolą humanoidalny model Project GR00T dzięki rzeczywistych i syntetycznych danych, co pozwala deweloperom zaoszczędzić czas i obniżyć koszty. Następnie używają mikrousługi Robocasa NIM w Isaac Lab, frameworku do uczenia się robotów, do generowania doświadczeń w celu ponownego trenowania modelu robota. W trakcie całego procesu NVIDIA OSMO płynnie przypisuje zadania obliczeniowe do różnych zasobów, oszczędzając deweloperom tygodnie zadań administracyjnych.

Model humanoidalny GR00T jest trenowany z wykorzystaniem rzeczywistych i syntetycznych danych, co pozwala oszczędzić czas i koszty.

Czy tak wygląda nasza przyszłość? Jak się na nią przygotować? Więcej o tym pisałem w jednym z ostatnich wydań mojego newslettera „Bo czemu nie?”.

1 rok temu

1 rok temu