Jeśli generowanie klipów wideo przez AI kojarzyło wam się z długim oczekiwaniem na wynik, chińskie ShengShu Technology właśnie zmienia zasady gry.

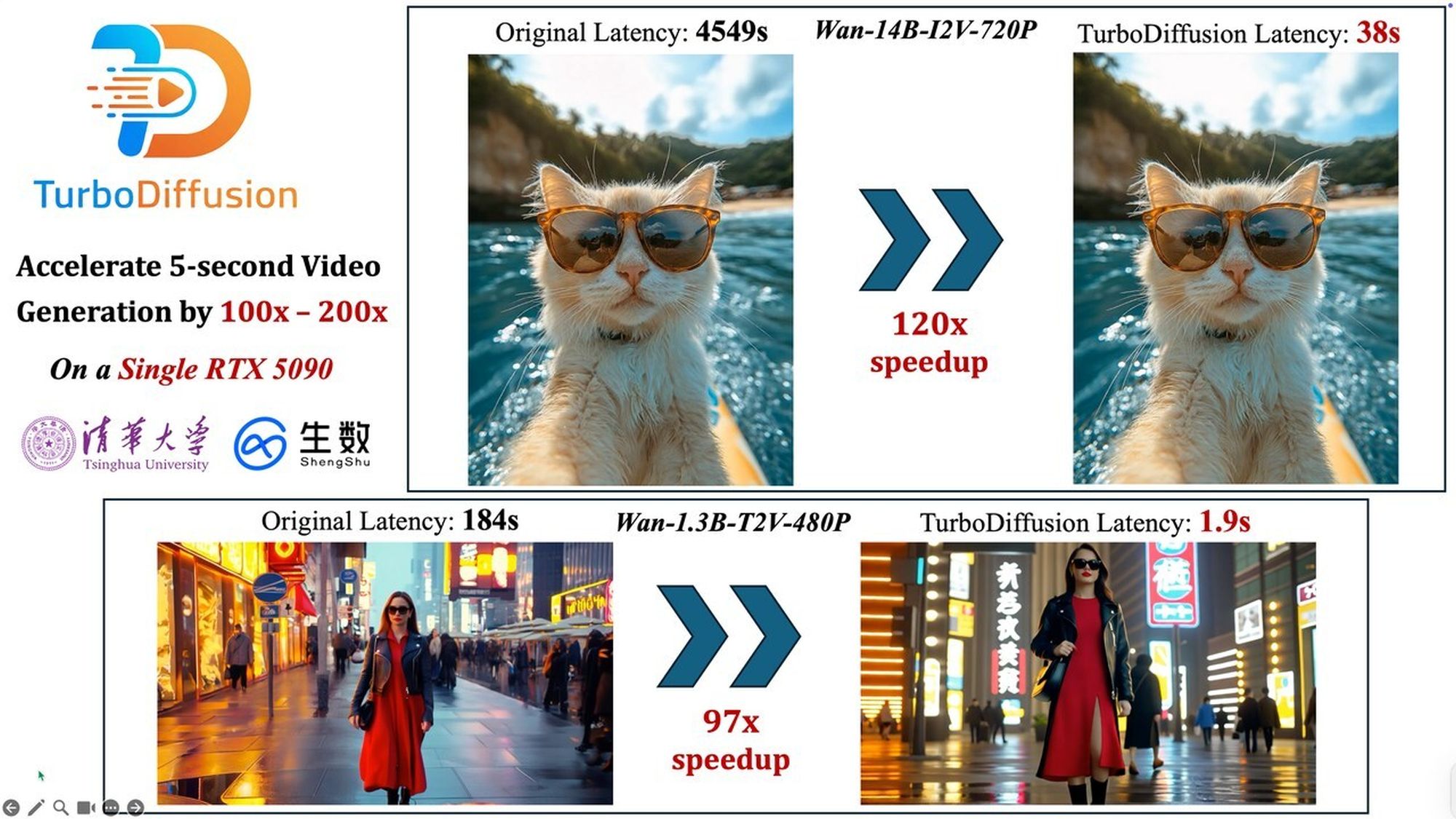

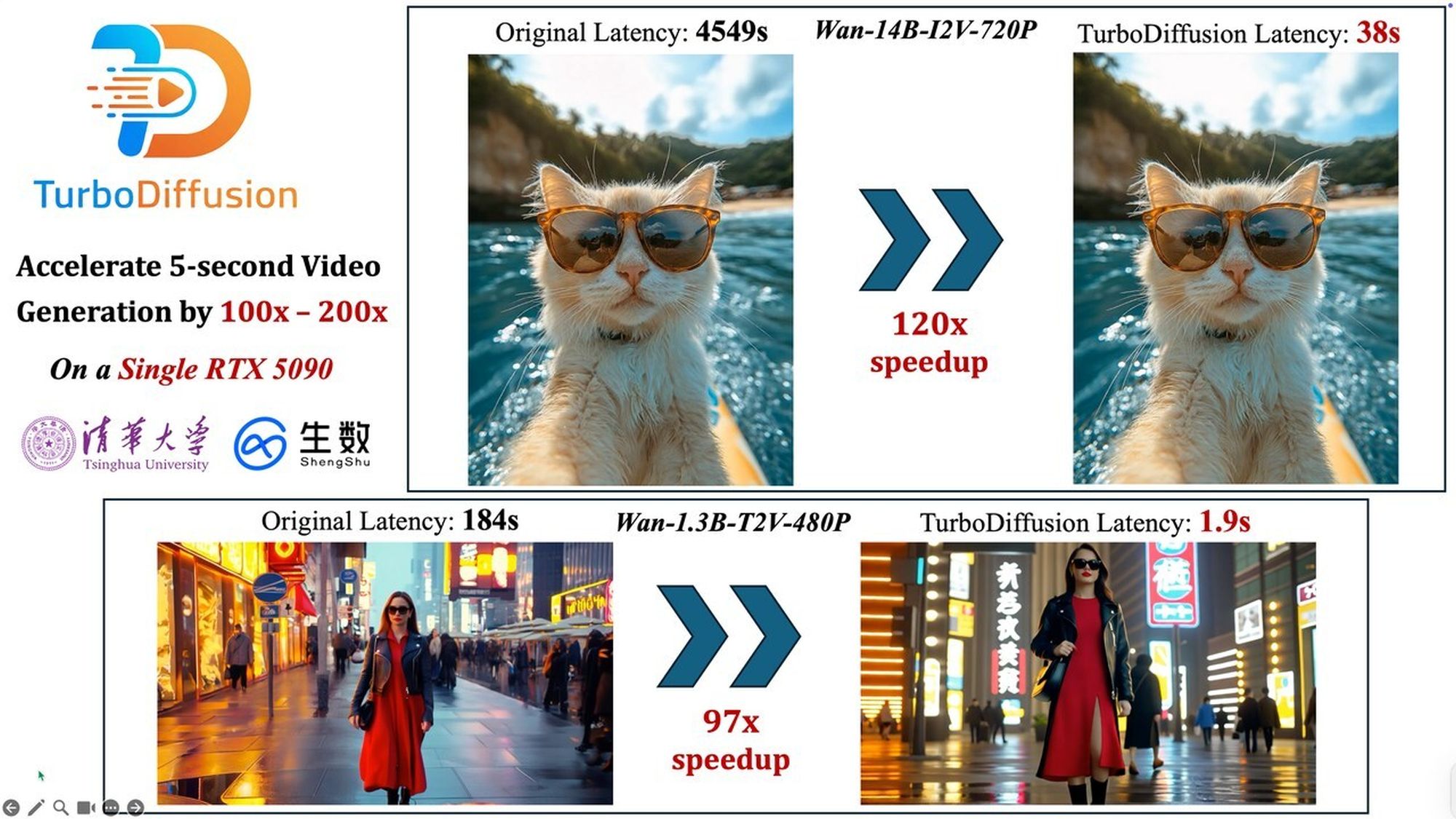

Nowy framework TurboDiffusion pozwala generować wideo w czasie zbliżonym do rzeczywistego, osiągając wyniki choćby 200 razy szybciej niż dotychczasowe modele.

ShengShu Technology we współpracy z laboratorium TSAIL Uniwersytetu Tsinghua udostępniło kod źródłowy rozwiązania o nazwie TurboDiffusion. Twórcy określają to wydarzenie mianem „momentu DeepSeek” dla modeli wideo – czyli punktem zwrotnym, który pozwala na masowe i tanie wdrażanie technologii, która dotąd była droga i powolna.

Z 15 minut do 8 sekund

Największe wrażenie robią twarde dane z testów. Zastosowanie TurboDiffusion do autorskiego modelu Vidu pozwoliło na wygenerowanie 8-sekundowego klipu w jakości 1080p w zaledwie 8 sekund. Dla porównania – wcześniej ten sam proces zajmował około 900 sekund (15 minut). Oznacza to przejście z mozolnego renderowania do generowania treści niemal w czasie rzeczywistym.

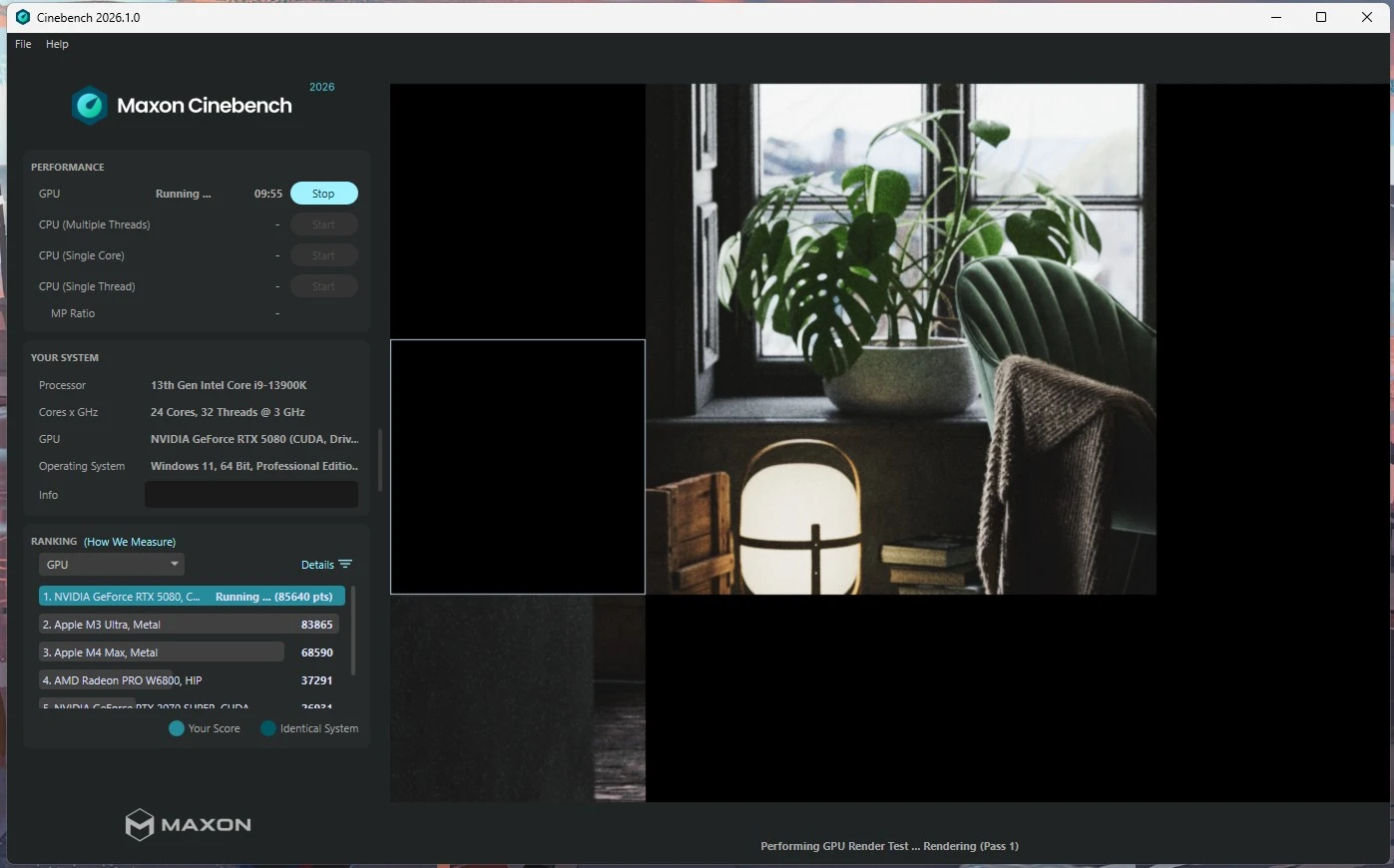

Co istotne dla entuzjastów sprzętu, tak drastyczny skok wydajności (od 100 do 200 razy szybciej) osiągnięto na pojedynczej karcie graficznej RTX 5090. Owszem, to bardzo drogi sprzęt (ok. 15 000 zł), ale tańszy niż… centrum danych.

Jak oni to zrobili? Cztery filary przyspieszenia

ShengShu i Tsinghua twierdzą, iż nie jest to wynik jednej sztuczki, ale połączenia czterech zaawansowanych technik optymalizacji, które nie degradują jakości obrazu:

- SageAttention: przeniesienie obliczeń atencji na niskobitowe rdzenie Tensor Core (rozwiązanie to jest już wdrażane m.in. przez NVIDIA, Google i ByteDance).

- Sparse-Linear Attention (SLA): trenowalna, rzadka atencja, która dokłada kolejne 17-20x przyspieszenia do powyższego.

- Destylacja kroków (rCM): redukcja liczby kroków potrzebnych do wygenerowania wideo do zaledwie 3–4, przy zachowaniu wysokiej jakości.

- Akceleracja warstw liniowych: kwantyzacja wag i aktywacji do 8 bitów (W8A8), co drastycznie zmniejsza zapotrzebowanie na pamięć VRAM.

Kod TurboDiffusion został udostępniony jako open-source, co oznacza, iż niedługo rozwiązania te mogą trafić do szerokiego grona twórców i innych modeli AI.

Google Photos trafi natywnie na telewizory Samsunga. W pakiecie edycja AI i Nano Banana

Jeśli artykuł Koniec renderowania w nieskończoność. TurboDiffusion skraca czas generowania wideo o… 200 razy nie wygląda prawidłowo w Twoim czytniku RSS, to zobacz go na iMagazine.

6 godzin temu

6 godzin temu