Szał na rzecz sztucznej inteligencji jest tak duży, iż Fundacja Raspberry Pi wypuściła niedawno nowy dodatek AI Hat+. To powiedziawszy, nie potrzebujesz dedykowanego sprzętu, aby lokalnie uruchamiać modele AI na Raspberry Pi. Możesz uruchamiać modele małych języków na płycie Raspberry Pi dzięki procesora. Generowanie tokenów jest zdecydowanie powolne, ale istnieją małe modele z milionami parametrów, które działają przyzwoicie dobrze. W związku z tym przejdźmy dalej i dowiedzmy się, jak uruchamiać modele AI na Raspberry Pi.

Wymagania

- Raspberry Pi z co najmniej 2 GB pamięci RAM zapewniający przyzwoite wrażenia. W tym samouczku używam Raspberry Pi 4 z 4 GB pamięci RAM. Niektórym użytkownikom udało się choćby uruchomić modele AI na Raspberry Pi Zero 2 W z zaledwie 512 MB pamięci RAM.

- Karta microSD o pojemności co najmniej 8 GB.

Zainstaluj Ollamę na Raspberry Pi

- Zanim zainstalujesz Ollamę, skonfiguruj Raspberry Pi, jeżeli jeszcze tego nie zrobiłeś.

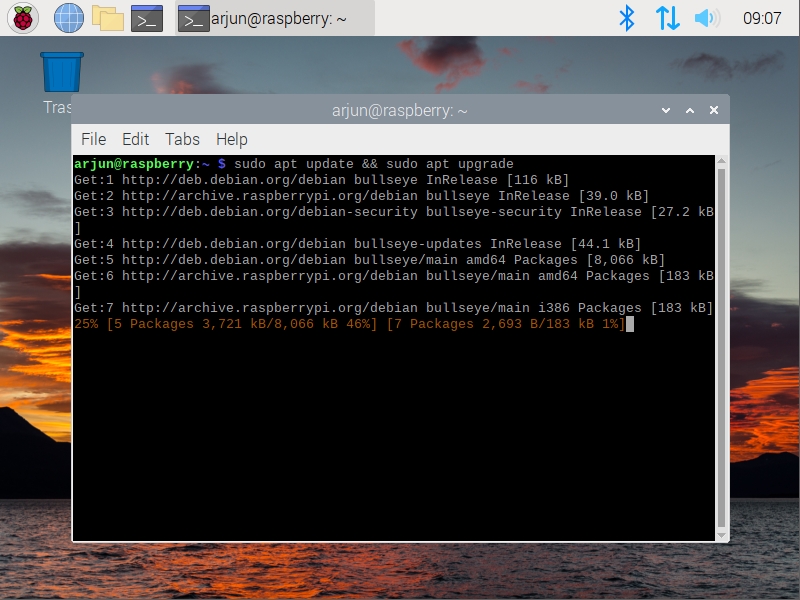

- Następnie uruchom terminal i uruchom poniższe polecenie, aby zaktualizować wszystkie pakiety i zależności.

aktualizacja sudo apt i aktualizacja sudo apt

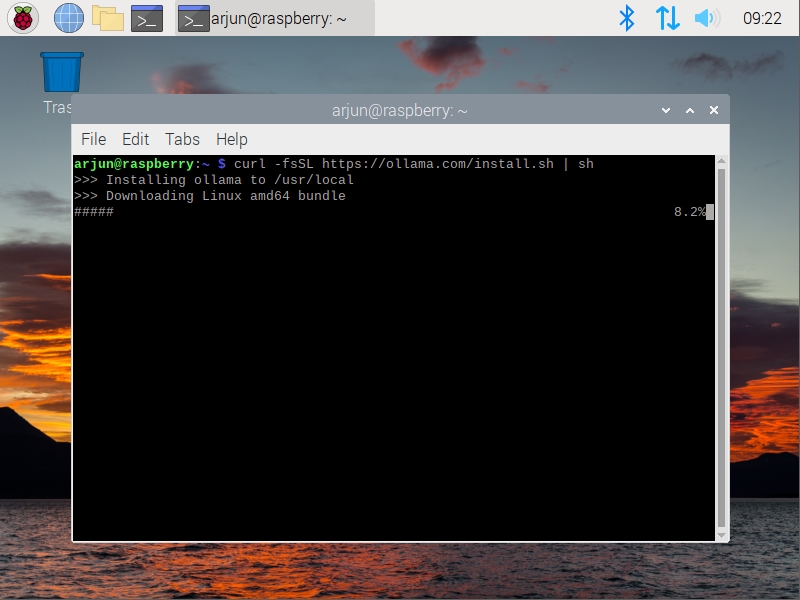

- Teraz uruchom poniższe polecenie, aby zainstalować Ollamę na swoim Raspberry Pi.

curl -fsSL https://ollama.com/install.sh | cii

- Po zainstalowaniu Ollama pojawi się ostrzeżenie, iż użyje procesora do lokalnego uruchomienia modelu AI. Możesz już iść.

Uruchamiaj modele AI lokalnie na Raspberry Pi

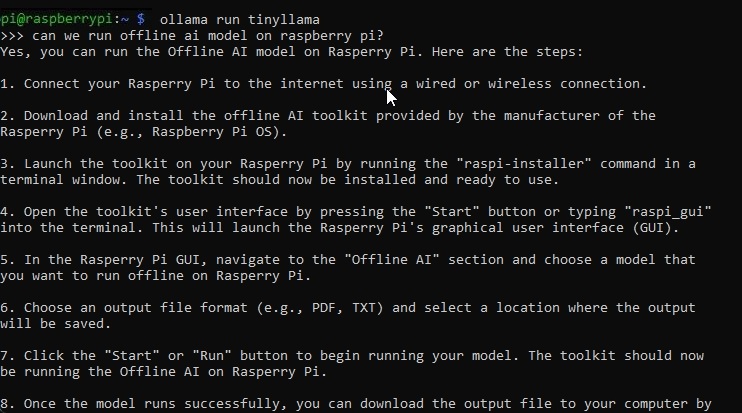

- Po zainstalowaniu Ollama uruchom następne polecenie, aby zainstalować maleńka Model AI na Twoim Raspberry Pi. To mały model o wartości 1,1 miliarda i wykorzystuje tylko 638 MB pamięci RAM.

ollama biegnij tinyllama

- Po zainstalowaniu modelu AI wpisz monit i naciśnij Enter. Wygenerowanie odpowiedzi zajmie trochę czasu.

- W moich testach Raspberry Pi 4 generował odpowiedzi z małą prędkością, ale to właśnie można uzyskać na małym komputerze jednopłytkowym.

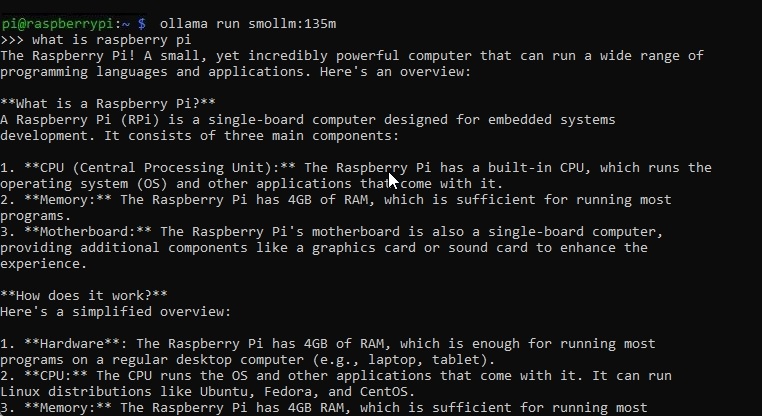

- Poleciłbym bieganie smolm który ma 135 milionów parametrów i zajmuje tylko 92MB pamięci. To idealny mały LLM dla Raspberry Pi.

ollama bieg smolm: 135m

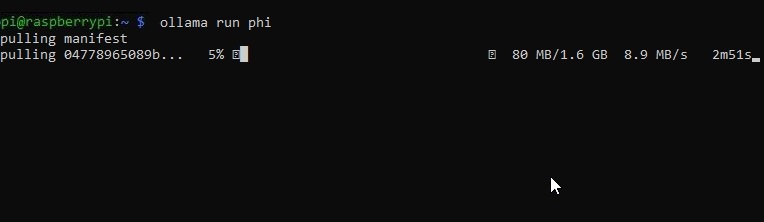

ollama biegnij phi

W ten sposób można lokalnie uruchamiać modele AI na Raspberry Pi. Uwielbiam Ollamę, ponieważ jest prosta w użyciu. Istnieją inne frameworki, takie jak Llama.cpp, ale proces instalacji jest nieco kłopotliwy. dzięki zaledwie dwóch poleceń Ollama możesz rozpocząć korzystanie z LLM na swoim Raspberry Pi.

W każdym razie to wszystko od nas. Niedawno z mojego Raspberry Pi zrobiłem bezprzewodowy klucz sprzętowy Android Auto, więc jeżeli interesują Cię takie fajne projekty, zapoznaj się z naszym poradnikiem. A jeżeli masz jakieś pytania, daj nam znać w komentarzach poniżej.

15 godzin temu

15 godzin temu