Google zaprezentowało siódmą generację własnych procesorów Tensor Processing Unit. Nowy układ o nazwie Ironwood oraz jego skalowalna architektura Ironwood Pod wyznaczają nowy standard w przetwarzaniu AI, zapewniając do 10× wyższą wydajność na chip niż poprzednia generacja. Superpody łączące 9 216 układów osiągają moc 42,5 ExaFLOPS – ponad stukrotnie większą niż flagowy system NVIDII. Równocześnie firma wprowadziła procesory Axion oparte na architekturze Armv9, zaprojektowane z myślą o efektywności energetycznej i integracji z nowymi akceleratorami AI.

Ironwood: nowy układ TPU z przełomową wydajnością

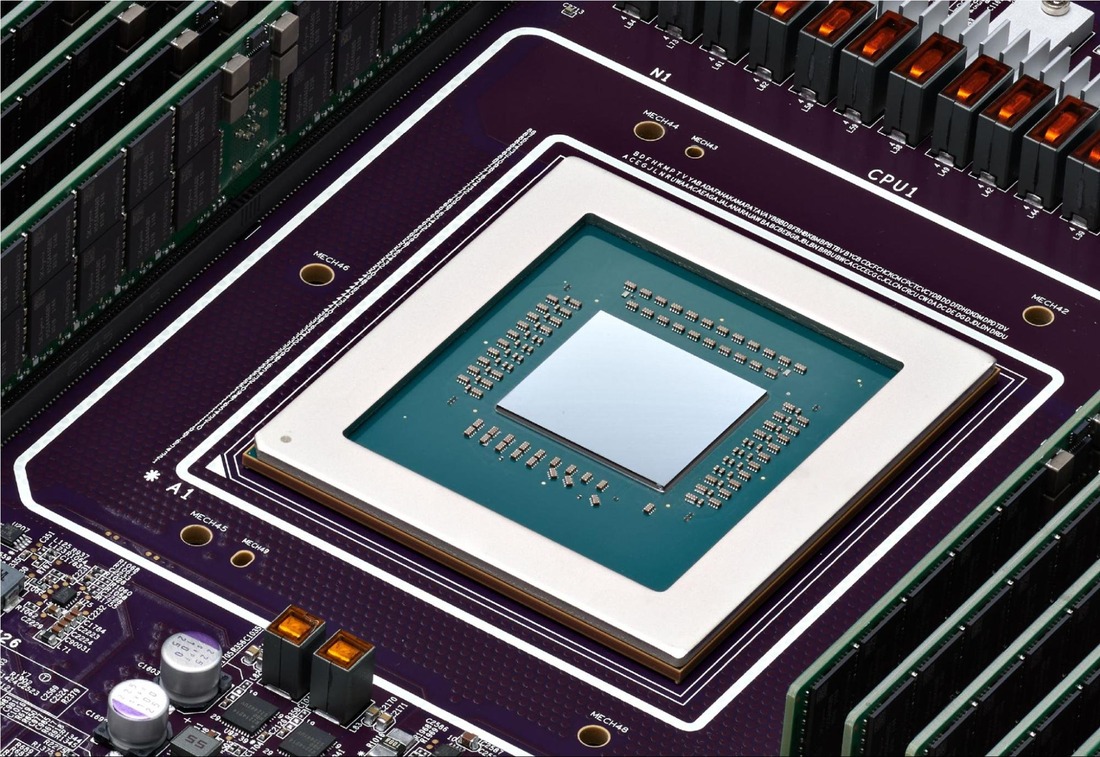

Według Google, pojedynczy układ TPU v7 Ironwood oferuje 4 614 TFLOPS (FP8) mocy obliczeniowej oraz 192 GB pamięci HBM3E, co stanowi sześciokrotność pojemności poprzedniego modelu TPU v6e (Trillium). Dzięki temu Ironwood może obsługiwać większe modele i złożone zestawy danych bez konieczności częstych transferów między chipami.

Google deklaruje 10× wyższą szczytową wydajność w porównaniu z TPU v5p oraz ponad 4× lepszą efektywność energetyczną względem Trillium – zarówno w treningu, jak i inferencji. Układ jest chłodzony cieczą i współpracuje z siecią Inter-Chip Interconnect (ICI), której przepustowość sięga 9,6 Tb/s w konfiguracjach wielochipowych.

Ironwood został zaprojektowany jako procesor uniwersalny dla dużych modeli, od treningu LLM-ów i reinforcement learningu po inferencję o bardzo niskich opóźnieniach. To właśnie ten drugi obszar, szybka i tania obsługa zapytań, staje się dziś kluczowym elementem rywalizacji między dostawcami akceleratorów AI.

Ironwood Pods i Superpods: 9 216 układów w jednej domenie obliczeniowej

Prawdziwa potęga Ironwooda ujawnia się w skali. Google opracowało nową architekturę Ironwood Pod, w której pojedyncze układy są łączone w jeden zintegrowany system superkomputerowy. Każdy pod może zawierać do 9 216 układów TPU Ironwood, połączonych w ramach ultraszybkiej sieci ICI.

W tej konfiguracji pod osiąga 42,5 ExaFLOPS mocy obliczeniowej w FP8 oraz 1,77 PB współdzielonej pamięci HBM3E. Jak zauważa Tom’s Hardware, to wynik ponad stukrotnie przewyższający możliwości systemu NVIDIA GB300 NVL72 (0,36 ExaFLOPS). Każdy pod może być dodatkowo zintegrowany z innymi w ramach sieci Jupiter, tworząc klastry liczące setki tysięcy TPU, z dynamicznym przełączaniem połączeń optycznych (Optical Circuit Switching) dla maksymalnej niezawodności.

Tak rozumiany Ironwood Superpod jest częścią platformy Google AI Hypercomputer – zintegrowanego środowiska łączącego obliczenia, sieć, pamięć masową i oprogramowanie w jedną, współprojektowaną architekturę.

Wdrożenia i partnerzy

Nowe układy nie są wyłącznie demonstracją technologiczną. Anthropic planuje wykorzystać do 1 miliona TPU Ironwood w rozwoju modeli Claude, co znacząco zwiększy ich skalę i dostępność. Lightricks, twórca generatywnego modelu LTX-2, chwali usprawnioną efektywność treningu oraz wyższą jakość generowanych obrazów i wideo. Essential AI wykorzystuje Ironwooda do budowy otwartych modeli typu frontier.

Według TrendForce, Google produkuje Ironwooda wspólnie z Broadcomem, a pełne wdrożenie układów planowane jest na 2026 r. Analitycy prognozują, iż dostawy TPU Google’a wzrosną w tym czasie o ponad 40% rok do roku, co utrzyma firmę na pozycji lidera wśród dostawców centrów danych AI.

Axion: Armv9 dla zrównoważonych środowisk AI

Drugim filarem nowej generacji układów Google jest Axion – pierwszy procesor ogólnego przeznaczenia firmy zbudowany w architekturze Arm Neoverse V9. Google wprowadza nowe instancje Axion N4A i C4A metal, oferujące do 96 vCPU, 768 GB pamięci DDR5 oraz 100 Gb/s łączności.

Axion ma zapewniać do 2× lepszy stosunek ceny do wydajności niż porównywalne jednostki x86, a jego niski pobór mocy sprawia, iż idealnie uzupełnia wyspecjalizowane akceleratory TPU. Procesory obsługują m.in. mikrousługi, bazy danych, analitykę danych oraz serwery aplikacyjne wspierające inferencję AI.

Pierwsze wdrożenia potwierdzają potencjał platformy. Vimeo odnotowało 30% poprawę wydajności transkodowania, ZoomInfo uzyskało 60% lepszy stosunek kosztów do wydajności, a Rise ograniczyło zużycie CPU o 15% bez utraty stabilności pracy.

1 miesiąc temu

1 miesiąc temu