W modelach iPhone’a 16 funkcja Visual Intelligence (wizualna inteligencja) pozwala korzystać z aparatu, aby dowiedzieć się więcej o miejscach i obiektach wokół siebie. Może również podsumowywać tekst, czytać tekst na głos, tłumaczyć tekst, wyszukiwać elementy w Google, zadawać pytania ChatGPT i nie tylko. A dzięki najnowszej aktualizacji iOS 18.4 od Apple, modele iPhone 15 Pro również mogą korzystać z tej funkcji.

Do niedawna Visual Intelligence było funkcją ograniczoną do modeli iPhone 16 z przyciskiem Camera Control, który był niezbędny do aktywacji funkcji. Jednak w lutym Apple zadebiutowało iPhone’em 16e, który nie posiada przycisku Camera Control, a mimo to obsługuje Visual Intelligence. Wynika to z faktu, iż urządzenie jest dostarczane z wersją iOS, która zawiera Inteligencję wizualną jako opcję przypisywaną do przycisku akcji urządzenia.

Apple potwierdziło później, iż to samo ustawienie dostosowywania Visual Intelligence pojawi się w modelach iPhone 15 Pro za pośrednictwem aktualizacji oprogramowania. Ta aktualizacja to iOS 18.4 i jest już dostępna. jeżeli jeszcze jej nie zaktualizowałeś, możesz to zrobić, otwierając Ustawienia ➝ Ogólne ➝ Aktualizacja oprogramowania.

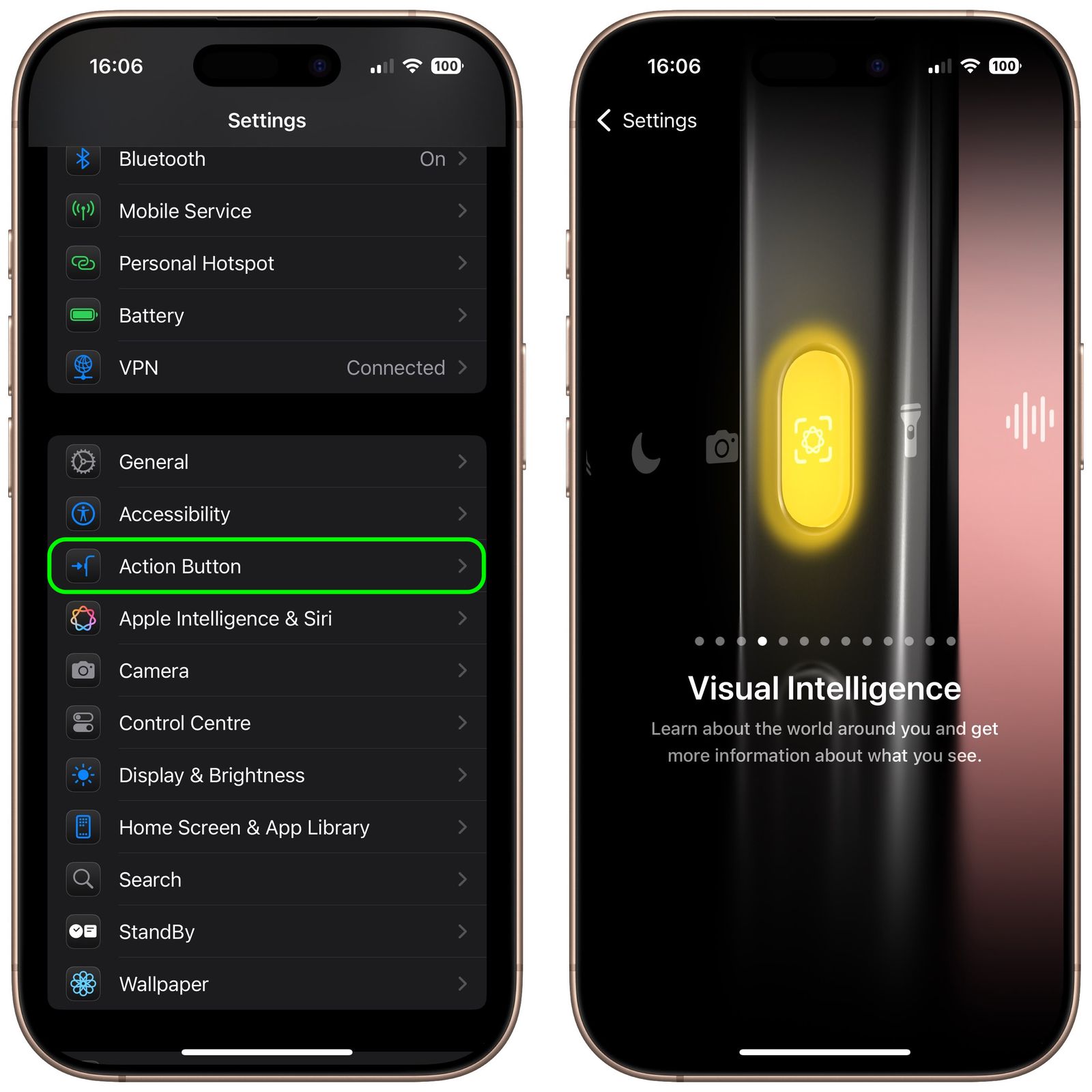

Po zaktualizowaniu urządzenia można przypisać Visual Intelligence do przycisku akcji urządzenia w następujący sposób:

- Otwórz Ustawienia na telefonie iPhone 15 Pro.

- Stuknij opcję Przycisk akcji.

- Przesuń palcem do Visual Intelligence.

Interfejs Visual Intelligence zawiera widok z aparatu, przycisk do robienia zdjęcia oraz dedykowane przyciski „Zapytaj” i „Szukaj”. Zadaj zapytania ChatGPT, a wyszukiwarka wyśle obraz do wyszukiwarki Google.

Korzystając z Visual Intelligence, możesz zrobić zdjęcie dzięki przycisku migawki, a następnie wybrać opcję lub wybrać opcję w widoku kamery na żywo. Nie możesz używać zdjęć, które zrobiłeś wcześniej.

Źródło: MacRumors