Kilka dni temu Apple oficjalnie ogłosiło pierwsze nowe funkcje iOS 19 i innych systemów, których premiera odbędzie się już za trzy tygodnie na WWDC 2025. Są to przede wszystkim ułatwienia dostępu, które – zdaniem Tima Cooka – “są częścią DNA firmy Apple”.

Poniżej znajdziecie pełną listę 6 nowych funkcji i 13 udoskonaleń dotychczasowych funkcjonalności.

iOS 19 – nowe funkcje dostępności

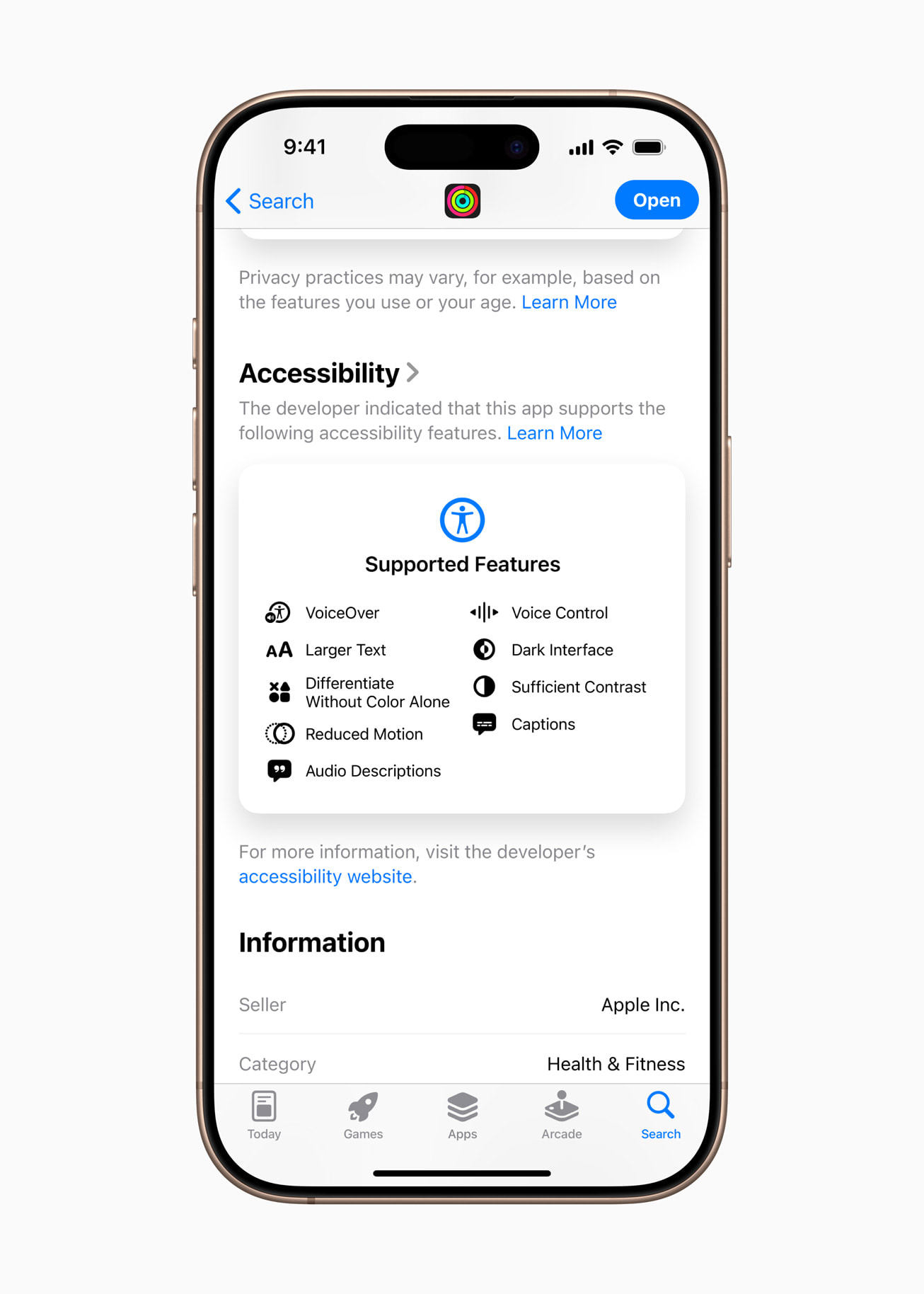

1. Accessibility Nutrition Labels

“Accessibility Nutrition Labels” to nowa sekcja prezentująca ułatwienia dostępu w aplikacjach i grach w App Store.

Dzięki nowym etykietom użytkownik jeszcze przed pobraniem aplikacji dowie się, czy będzie ona dla nich dostępna, a programiści zyskają możliwość poinformowania o działających w aplikacji funkcjach oraz ich obsłudze.

Będzie to dotyczyło między innymi takich funkcjonalności, jak:

- VoiceOver

- Sterowanie głosowe

- Większy tekst

- Zwiększ kontrast

- Redukuj ruch

- napisy

2. Nowa Lupa na Maca

Wprowadzona w 2016 roku na iPhone’a i iPada funkcja “Lupa” daje osobom niewidomym lub niedowidzącym narzędzia do powiększania, odczytywania tekstu i wykrywania znajdujących się w pobliżu obiektów.

W tym roku Lupa zadebiutuje na Macu. Aplikacja “Lupa na Maca” łączy się z aparatem w telefonie użytkownika, przybliżając przedmioty z otoczenia, np. ekran czy tablicę. Lupa współpracuje z kamerą Continuity iPhone’a oraz kamerami podłączonymi przez port USB, a dzięki funkcji “Widok blatu” pomaga w odczytywaniu dokumentów.

Użytkownicy korzystający z kilku aktywnych okien mogą pracować wielozadaniowo, na przykład wyświetlać prezentację na kamerze internetowej i jednocześnie śledzić tekst w książce dzięki funkcji Widok blatu.

Co więcej, Lupa na Maca została zintegrowana z inną funkcją dostępu, Accessibility Reader, która przetwarza tekst z fizycznego otoczenia użytkownika na specjalny, dający się odczytać format.

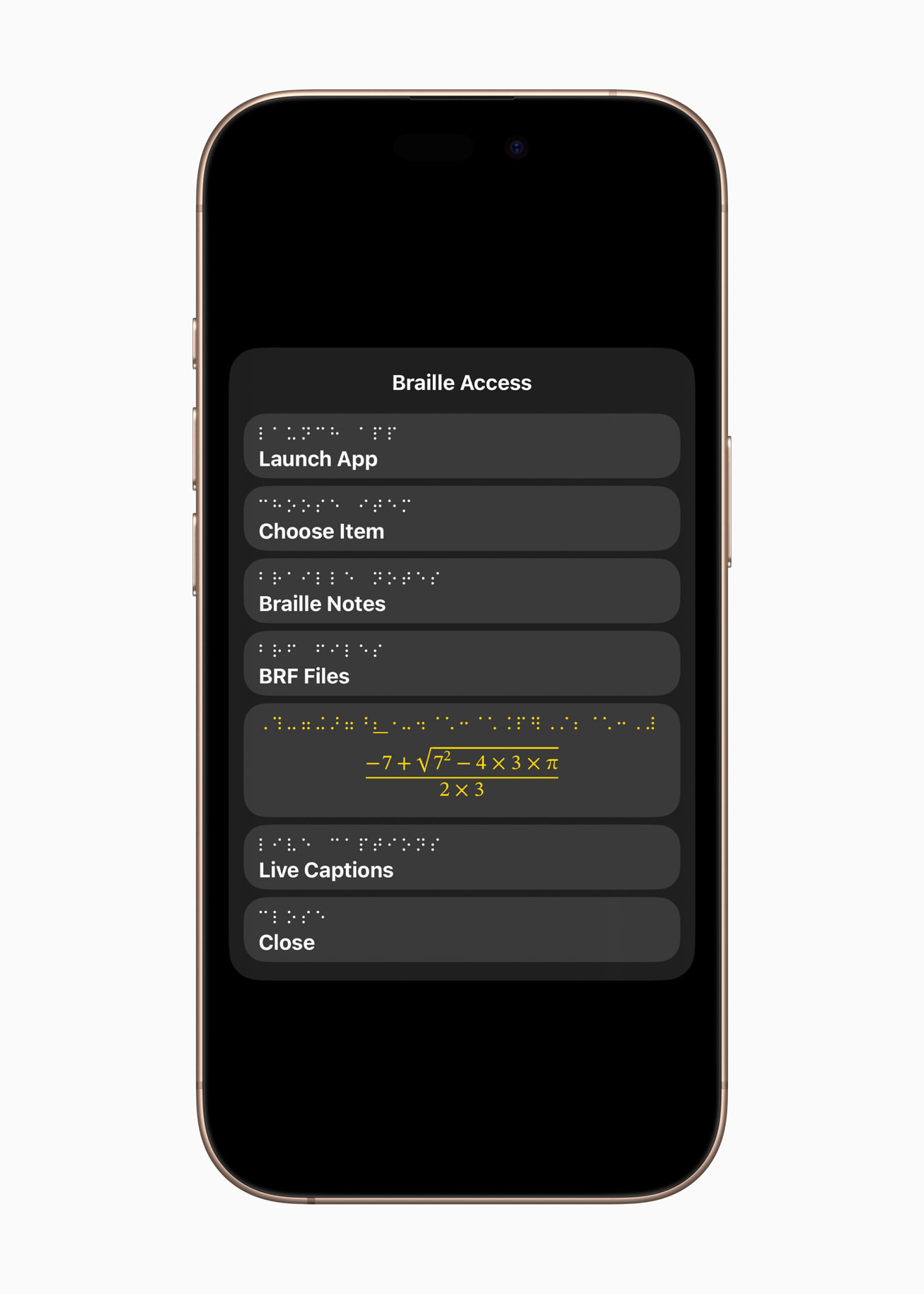

3. Braille Access

Funkcja Braille Access zmienia iPhone’a, iPada, Maca i Apple Vision Pro w pełni wyposażony notatnik brajlowski, całkowicie zintegrowany z ekosystemem Apple.

Dzięki wbudowanej funkcji uruchamiania aplikacji użytkownicy będą mogli łatwo otworzyć dowolną aplikację, wprowadzać pismo Braille’a dzięki funkcji Wejście ekranu Braille’a lub podłączonego monitora brajlowskiego.

Braille Access daje też możliwość szybkiego robienia notatek pismem Braille’a oraz wykonywania obliczeń dzięki Nemeth Braille, czyli kodu brajlowskiego często używanego podczas lekcji matematyki czy przyrody.

Do tego zintegrowana funkcja Napisy na żywo umożliwia transkrypcję rozmów w czasie rzeczywistym bezpośrednio na monitorze brajlowskim.

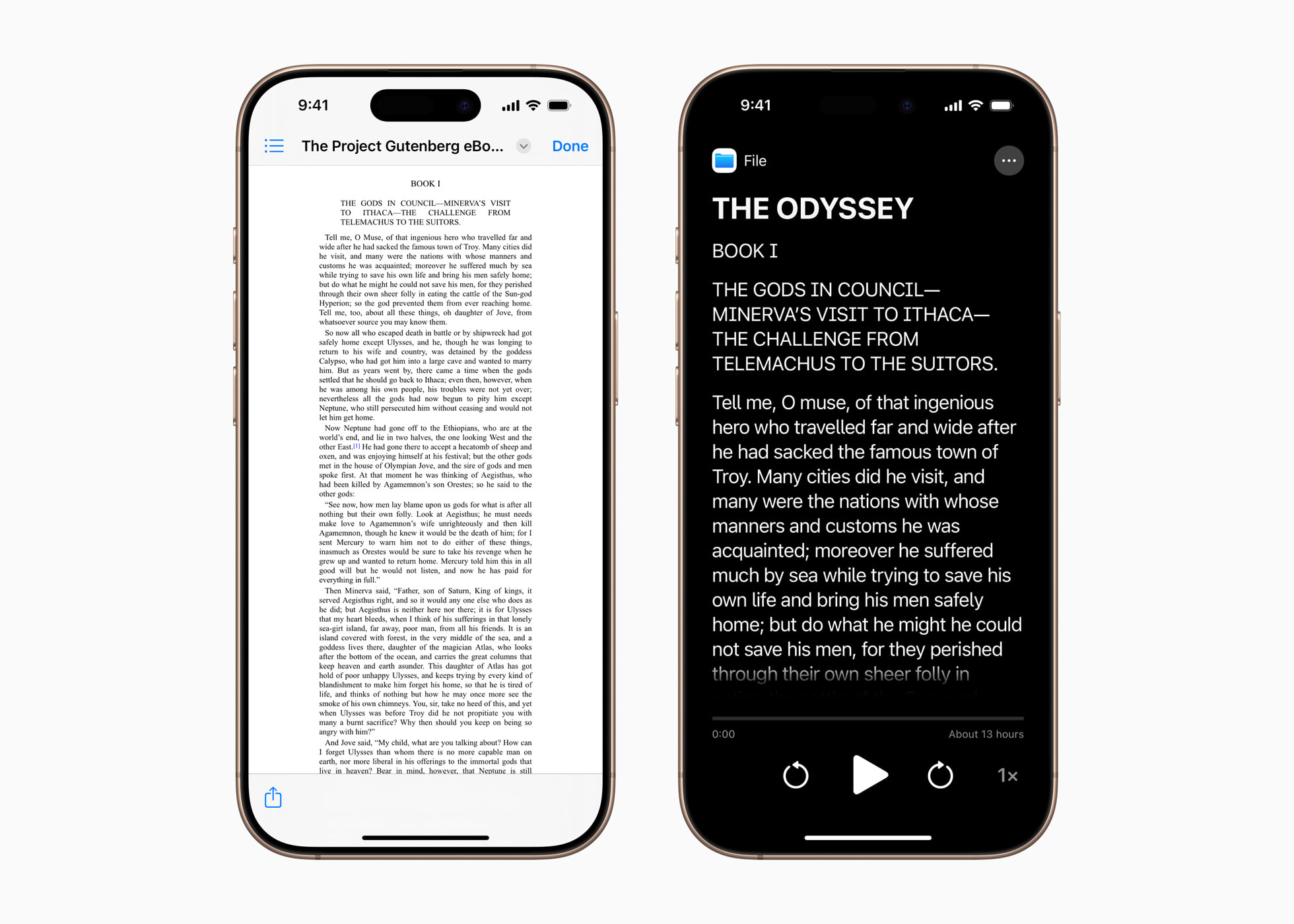

4. Accessibility Reader

Accessibility Reader to nowy, dostępny w całym systemie (na iPhonie, iPadzie, Macu i Apple Vision Pro) tryb odczytu, ułatwiający czytanie osobom z różnymi niepełnosprawnościami, jak dysleksja czy niedowidzenie.

Daje użytkownikom nowe sposoby dostosowywania tekstu i skupiania się na treściach, które chcą przeczytać, z szerokimi opcjami czcionki, koloru i odstępów, a także obsługą treści mówionych.

Rozwiązanie Accessibility Reader można uruchomić w dowolnej aplikacji. Jest ono również zintegrowane z aplikacją Lupa dla iOS, iPadOS i macOS, pozwalając użytkownikom na odczytywanie tekstu z fizycznego otoczenia, na przykład książek czy menu.

5. Podpisy na żywo na Apple Watchu

Niesłyszący lub niedosłyszący użytkownicy Apple Watcha będą mogli sterować na nim funkcją Live Listen, wzbogaconą o wiele nowych opcji, w tym Napisy na żywo w czasie rzeczywistym.

Live Listen zmienia iPhone’a w zdalny mikrofon, umożliwiając strumieniowane treści bezpośrednio do AirPodsów, aparatu słuchowego (z certyfikatem Made for iPhone) lub słuchawek Beats.

Po rozpoczęciu sesji na iPhonie, użytkownicy mogą dzięki funkcji Napisy na żywo jednocześnie słuchać odtwarzanych na nim materiałów audio i czytać ich transkrypcję na Apple Watch sparowanym z iPhonem.

Apple Watch staje się pilotem, który pozwala włączyć lub wyłączyć sesję Live Listen bądź cofnąć się do momentu, w którym użytkownikowi coś uciekło.

Użytkownicy Apple Watch mogą sterować sesjami Live Listen z odległości, zatem bez konieczności wstawania podczas spotkania czy lekcji.

Z funkcji Live Listen można korzystać razem z rozwiązaniami wspierającymi zdrowie słuchu dostępnymi w AirPods Pro 2, w tym funkcją aparatu słuchowego jakości klinicznej.

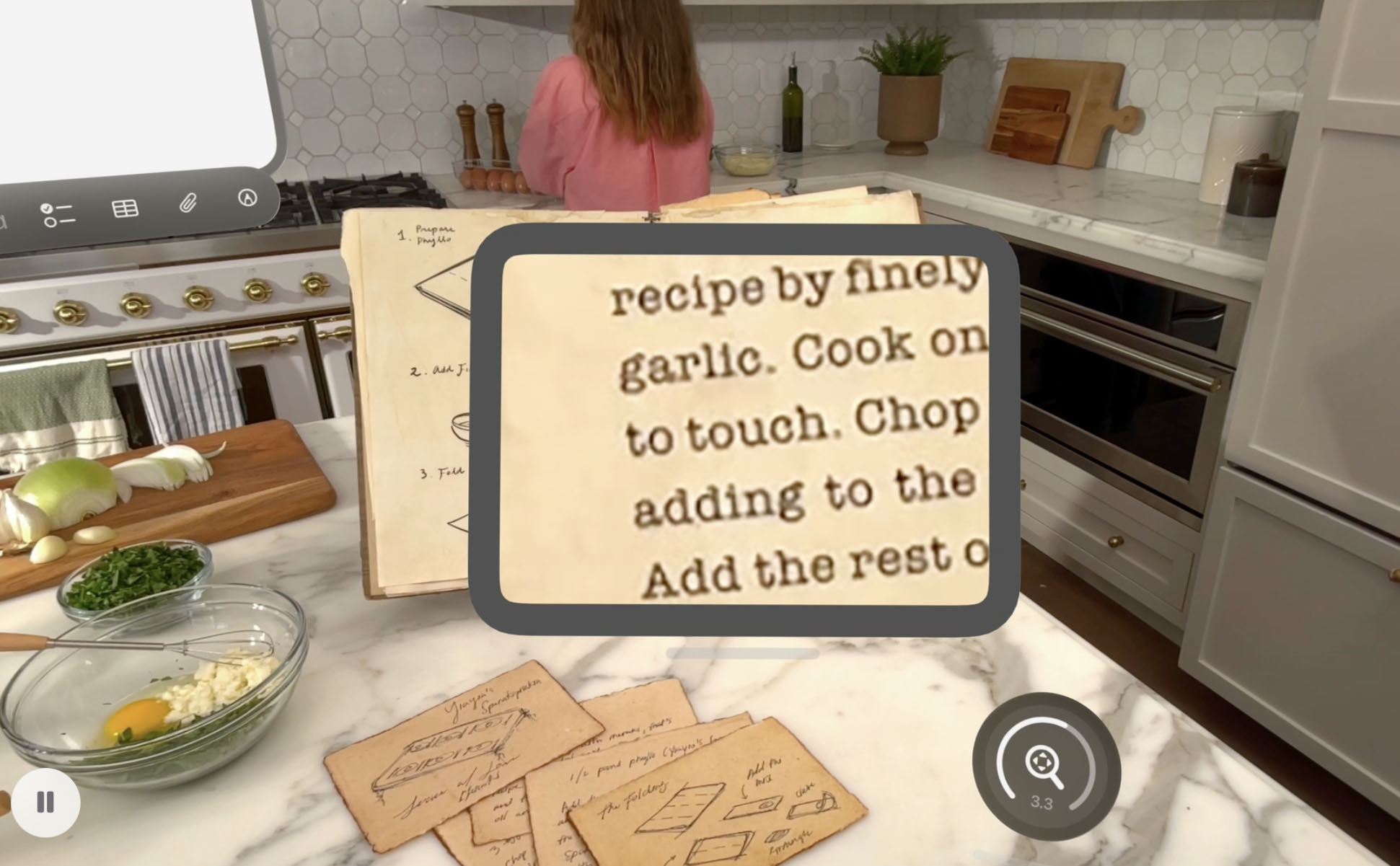

6. Udoskonalony widok w Apple Vision Pro

Nowa wersja visionOS poszerzy dotychczasowe ułatwienia dostępu dla użytkowników niewidomych lub niedowidzących za pośrednictwem zaawansowanego systemu kamer w goglach Apple Vision Pro.

Aktualizacje funkcji Zoom pozwolą użytkownikom powiększyć wszystko w zasięgu ich wzroku – łącznie z elementami otoczenia – dzięki kamery głównej.

Dzięki wewnętrznym algorytmom uczenia maszynowego funkcja “Rozpoznawanie na żywo” będzie wspierać osoby korzystające z rozwiązania VoiceOver poprzez opisywanie na głos ich otoczenia, odczytywanie dokumentów, wyszukiwanie przedmiotów i wiele innych czynności.

Deweloperzy rozwijający funkcje dostępu będą mogli w swoich zatwierdzonych aplikacjach skorzystać z nowego interfejsu API dającego dostęp do kamery głównej.

Użytkownicy zyskają w ten sposób więcej sposobów na poznawanie otaczającego ich świata bez użycia rąk, np. poprzez bieżącą, indywidualną pomoc w rozpoznawaniu przedmiotów, na przykład w aplikacji Be My Eyes.

Uaktualnienia dotychczasowych funkcji:

- Funkcję Dźwięki tła będzie można łatwiej spersonalizować za sprawą nowych ustawień korektora, opcji automatycznego zatrzymywania po określonym czasie oraz kilku nowych czynności automatyzacji dostępnych w aplikacji Skróty.Dźwięki tła ograniczają rozpraszacze i pomagają użytkownikom w koncentrowaniu się i relaksacji. Rozwiązanie to jest skuteczne zwłaszcza dla osób cierpiących na szumy uszne.

- Dla osób zagrożonych utratą mowy przydatna będzie funkcja Głos indywidualny, która dzięki użyciu najnowszych wewnętrznych algorytmów uczenia maszynowego oraz sztucznej inteligencji ma działać jeszcze szybciej, wygodniej i wszechstronniej.Do wygenerowania płynnego i naturalnego głosu potrzebować będzie niespełna minuty i tylko 10 zarejestrowanych fraz.Funkcja Głos indywidualny obsługiwać będzie dodatkowo język hiszpański (w Meksyku).

- Funkcja Wizualizacja ruchu pojazdu, która pomaga złagodzić objawy choroby lokomocyjnej w czasie podróży pojazdem, pojawi się na Macu i zyska nowe opcje personalizacji animowanych kropek na iPhonie, iPadzie i Macu.

- Użytkownicy korzystający z rozwiązania Śledzenie oczu na iPhonie i iPadzie będą mogli dokonywać wyborów poprzez użycie przełącznika lub funkcji zatrzymanie.

Wprowadzone w ramach tej aktualizacji udoskonalenia, takie jak nowy licznik czasu zatrzymania, mniejsza liczba czynności podczas pisania przy użyciu przełączników czy obsługa funkcji QuickPath dla iPhone’a i Vision Pro, sprawiają, iż pisanie na klawiaturze ze Śledzeniem oczu lub Sterowaniem przełącznikami staje się na iPhonie, iPadzie i Apple Vision Pro jeszcze prostsze.

- Funkcja Śledzenie głowy, działająca podobnie do Śledzenia wzroku, pozwoli sterować iPhonem i iPadem dzięki ruchów głowy.

![]()

- Użytkowników z poważną niepełnosprawnością narządu ruchu wspierać będzie w systemach iOS, iPadOS i visionOS nowy protokół funkcji Sterowania przełącznikami przeznaczony dla interfejsów BCI (Brain Computer Interfaces) stanowiących rozwijającą się technologię umożliwiającą sterowanie urządzeniem dzięki ruchów ciała.

- Dostęp wspomagany zostanie poszerzony o nową, specjalną aplikację Apple TV z uproszczonym odtwarzaczem. Deweloperzy zyskają również dodatkowe narzędzia w interfejsie API funkcji “Dostęp wspomagany” do tworzenia rozwiązań skrojonych pod potrzeby użytkowników z ograniczeniami intelektualnymi i rozwojowymi.

- Haptyka muzyki na iPhonie ma stać się bardziej osobista dzięki opcji zastosowania jej do całej piosenki bądź tylko ścieżki wokalnej oraz możliwości dostosowania ogólnej intensywności stuknięć, tekstury i wibracji.

- Funkcja Rozpoznawanie dźwięku zostanie rozbudowana o nową opcję rozpoznawania imion, dzięki której niesłyszący lub niedosłyszący użytkownicy będą wiedzieć, kiedy ktoś wypowie ich imię.

- Sterowanie głosowe zyska nowy tryb programowania w aplikacji Xcode przeznaczony dla programistów z ograniczoną sprawnością ruchową. W ramach tego ułatwienia dostępna będzie również synchronizacja słowników na różnych urządzeniach oraz obsługa dodatkowych języków: angielskiego (Singapur), arabskiego (Arabia Saudyjska), chińskiego mandaryńskiego (Tajwan), hiszpańskiego (Ameryka Łacińska), koreańskiego, rosyjskiego, tureckiego i włoskiego.

- Pakiet języków w funkcji Podpisy na żywo zostanie poszerzony o język angielski (Indie, Australia, Wielka Brytania, Singapur), chiński mandaryński (Chiny kontynentalne), francuski (Francja, Kanada), hiszpański (Ameryka Łacińska, Hiszpania), japoński, kantoński (Chiny kontynentalne, Hongkong), koreański i niemiecki (Niemcy).

- W ramach zapowiadanych aktualizacji funkcja CarPlay zyska obsługę Dużej czcionki. Dzięki odświeżonej funkcji Rozpoznawanie dźwięku niesłyszący lub niedosłyszący kierowcy i pasażerowie korzystający z CarPlay otrzymają teraz powiadomienia o płaczu dziecka, a nie tylko dźwękach dochodzących z zewnątrz pojazdu, takich jak odgłos klaksonu czy syreny.

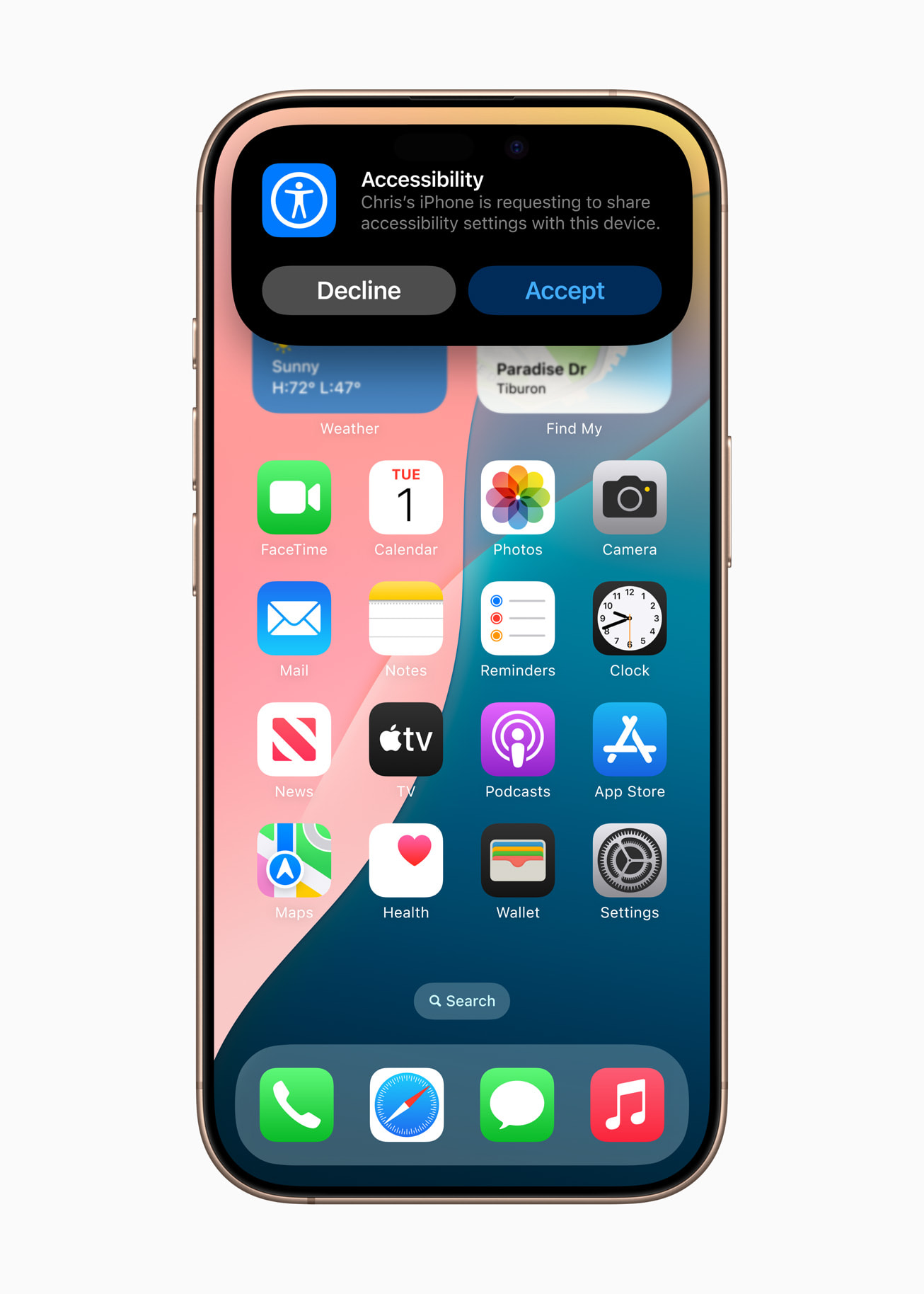

- Za pomocą funkcji udostępniania ustawień dostępności użytkownicy będą mogli gwałtownie przenieść na jakiś czas ustawienia własnych ułatwień dostępu na innego iPhone’a lub iPada. To rozwiązanie świetnie sprawdzi się, kiedy trzeba pożyczyć urządzenie znajomego lub skorzystać z infokiosku, na przykład w kawiarni.

Konferencja WWDC 2025 rozpocznie się już 9 czerwca. Spodziewamy się premiery:

- iOS 19

- iPadOS 19

- watchOS 12

- macOS 16

- tvOS 19

- visionOS 3

Na razie nie wiadomo, czy podczas WWDC 2025 Apple zaprezentuje również nowe urządzenia.

Wszystko, co do tej pory wiemy o najważniejszym z nowych systemów – iOS 19 – znajdziecie tutaj.

4 miesięcy temu

4 miesięcy temu