Ponieważ modele są dozwolone do iteracyjnie „myśleć” poprzez problem, tworzą one więcej tokenów wyjściowych i dłuższych cykli generowania, więc jakość modelu przez cały czas skaluje się. Znaczące obliczanie czasu testowego ma najważniejsze znaczenie dla umożliwienia wnioskowania w czasie rzeczywistym, jak i odpowiedzi wyższej jakości z modeli rozumowania, takich jak DeepSeek-R1, wymagające większych wdrażania wnioskowania. R1 zapewnia wiodącą dokładność zadań wymagających logicznego wnioskowania, rozumowania, matematyki, kodowania i zrozumienia języka, jednocześnie zapewniając wysoką wydajność wnioskowania.

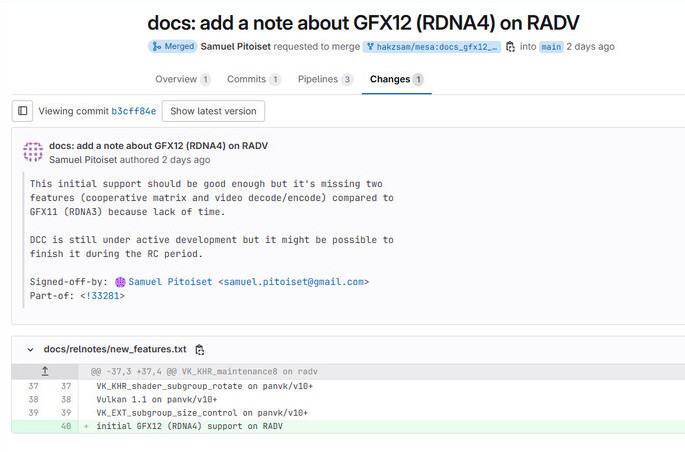

Aby pomóc programistom bezpiecznie eksperymentować z tymi możliwościami i budować własnych wyspecjalizowanych agentów, model 671 miliardów parametrów DeepSeek-R1 jest teraz dostępny jako podgląd mikrousług NVIDIA NIM build.nvidia.com. MicroService DeepSeek-R1 NIM może dostarczyć do 3872 tokenów na sekundę na jednym systemie NVIDIA HGX H200. Deweloperzy mogą testować i eksperymentować z interfejsem programowania aplikacji (API), który ma być dostępny niedługo jako mikrousług NIM, część platformy systemu NVIDIA AI Enterprise.

MicroService DeepSeek-R1 NIM upraszcza wdrożenia przy wsparciu standardowych interfejsów API. Przedsiębiorstwa mogą zmaksymalizować prywatność bezpieczeństwa i danych, uruchamiając mikrousługę NIM na preferowanej infrastrukturze komputerowej przyspieszonej. Korzystając z odlewni NVIDIA AI z oprogramowaniem NVIDIA NEMO, Enterprises będzie również w stanie stworzyć dostosowane mikrousługi DeepSeek-R1 NIM dla specjalistycznych agentów AI.

Deepseek-R1-doskonały przykład skalowania czasu testowego

DeepSeek-R1 to duży model mieszanki ekspertów (MOE). Zawiera imponujące 671 miliardów parametrów-10 razy więcej niż wiele innych popularnych LLM open source-wspierając dużą długość kontekstu wejściowego 128 000 tokenów. Model wykorzystuje również ekstremalną liczbę ekspertów na warstwę. Każda warstwa R1 ma 256 ekspertów, przy czym każdy token został kierowany do ośmiu oddzielnych ekspertów równolegle do oceny.

Dostarczanie odpowiedzi w czasie rzeczywistym dla R1 wymaga wielu procesorów GPU o wysokiej wydajności obliczeniowej, związanych z komunikacją o dużej przepustowości i niskiej opóźnień w celu podążania szybkim tokenem do wnioskowania. W połączeniu z optymalizacjami systemu dostępne w mikrouserdzie NVIDIA NIM, pojedynczy serwer z ośmioma GPU H200 połączonymi przy użyciu NVLink i NVLink Switch może uruchomić pełny model 671 miliardów parametrów Deepseek-R1 na sekundę do 3872 tokenów na sekundę. Ta przepustowość jest możliwa dzięki zastosowaniu silnika transformatora FP8 Architektury NVIDIA Hopper w każdej warstwie – i 900 GB/s przepustowości NVLINK dla komunikacji ekspertów MOE.

Wykorzystanie każdej operacji zmiennoprzecinkowej na sekundę (klapy) wydajności z GPU ma najważniejsze znaczenie dla wnioskowania w czasie rzeczywistym. Architektura NVIDIA Blackwell nowej generacji zapewni skalowanie czasu testowania na modelach rozumowania, takich jak DeepSeek-R1, gigantyczne wzmocnienie z rdzeniami tensorowymi piątej generacji, które mogą dostarczyć do 20 Petaflopów Peak FP4 Comput Perowce i 72-GPU NVLINK DOMANE DODZNAJNOŚCI NVLINK do wnioskowania.

Zacznij teraz z mikrousługą DeepSeek-R1 NIM

Deweloperzy mogą doświadczyć DeepSeek-R1 NIM MicroServiceteraz dostępne build.nvidia.com. Zobacz, jak to działa:

Dzięki NVIDIA NIM przedsiębiorstwa mogą z łatwością wdrażać DeepSeek-R1 i zapewnić wysoką wydajność potrzebną dla agencyjnych systemów AI.

Widzieć ogłoszenie dotyczące informacji o oprogramowaniu.