Generatywna sztuczna inteligencja to na dziś jedna z najbardziej rozwojowych branż informatyki. Niestety, również najdroższych. Koszt rozwoju tej technologii i całkowitego wykorzystania jej potencjału wykracza poza możliwości większości przedsiębiorstw. Jest jedna firma, która chce to zmienić – a przy okazji dołączyć do największych potęg IT świata.

Pod koniec minionego miesiąca wydarzyła się rzecz dla niektórych trudna do przewidzenia. Kapitalizacja rynkowa Nvidii przekroczyła bilion dolarów, tym samym rzeczona Nvidia dołączyła do bardzo nielicznego grona największych spółek technologicznych świata. Jedynymi innymi firmami, które zdołały przekroczyć barierę biliona, są Microsoft, Alphabet, Apple i Amazon. Nie udało się tego osiągnąć żadnemu innemu producentowi lub projektantowi układów scalonych. choćby Intelowi.

No właśnie, a jak wygląda wycena największych dostawców chipów na świecie?

Dla przypomnienia, kapitalizacja rynkowa jest miarą wartości firmy na rynku akcji i jest obliczana przez pomnożenie liczby akcji w obrocie przez cenę jednej akcji.

- Kapitalizacja rynkowa Intela na dzień 16 czerwca 2023 r. wynosiła 151,69 mld dol,, co oznacza wzrost o 39,08 proc. w porównaniu z 109,07 miliarda dolarów na dzień 16 czerwca 2022 roku.

- Kapitalizacja rynkowa AMD na ten sam dzień wynosiła 193,37 mld dol., co oznacza wzrost o 27,47 proc. w porównaniu z 151,69 mld dol. rok temu.

- Qualcomm to 136,66 mld dol. (spadek o 9,91 proc. z 151,69 mld dol.

Nijak ma się to do biliona Nvidii. Jej kapitalizacja rynkowa jest tak wysoka, ponieważ firma jest liderem w produkcji i sprzedaży chipów i kart graficznych, które są wykorzystywane do różnych zastosowań, w tym i przede wszystkim do sztucznej inteligencji. Nvidia odnotowała znaczący wzrost przychodów i zysków w ostatnich kwartałach, dzięki rosnącemu popytowi na jej produkty do centrów danych, gier, obliczeń i renderowania. To pierwsze jest szczególnie istotne.

Chipy Nvidii są jednak bardzo drogie. Akcelerator Nvidia H100 to wydatek 30 tys. dol., a do tego jeszcze dochodzi wysokie zużycie energii i wysokie koszty oprogramowania. Mimo tego Nvidia, według ostrożnych szacunków, kontroluje 80 proc. rynku układów do przetwarzania SI. Nvidia nie jest jednak na rynku samotna.

Intel i Qualcomm na dziś nie rzucają jej żadnego większego wyzwania. Być może dlatego, iż do przetwarzania danych przez generatywną SI szczególnie dobrze sprawdzają się układy o budowie i architekturze nieodległej kartom graficznym. Akceleratory ML/SI i układy NPU bezpośrednio wywodzą się z kart graficznych – tyle iż zamiast przeliczać śledzenie promieni w scenie 3D, przetwarzają dane według modeli SI. Skoro na tym swoją potęgę zbudował producent kart graficznych GeForce, to gdzie się podziewa producent kart graficznych Radeon?

AMD jest obecne na rynku akceleratorów SI już od pewnego czasu, jednak do tej pory firma wyraźnie nie miała równie atrakcyjnej oferty. Przez ostatnie miesiące jednak różnymi kanałami sugerowała, iż szykuje coś bardzo ważnego. Dla przyszłości swojej, generatywnej SI i być może też Nvidii. Przede wszystkim jednak dla firm zajmujących się sztuczną inteligencją i ich klientów – czyli nas.

Duże Modele Językowe za względnie niską cenę. AMD demonstruje innowacyjne układy scalone, jeszcze mocniej będzie wspierać open-source.

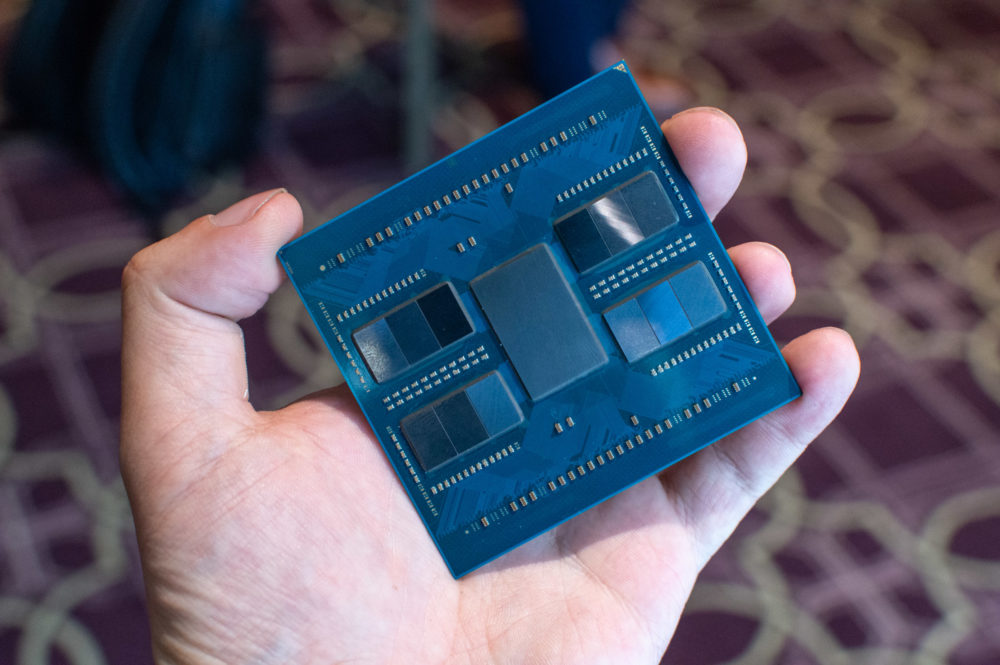

AMD Instinct MI300X to najnowszy chip firmy do akceleracji przeliczeń związanych z SI. Zdaniem firmy to najbardziej zaawansowany układ tego typu, choć niestety na dziś nie sposób jeszcze to zweryfikować. Układ zbudowany jest według mikroarchitektury CDNA 3 i obsługuje do 192 GB pamięci HBM3. To ostatnie ma być szczególnie ważne.

Lisa Su, dyrektorka generalna AMD, z chipem MI300X w ręku

Lisa Su, dyrektorka generalna AMD, z chipem MI300X w rękuZa sprawą dużej ilości pamięci możliwe jest, zdaniem AMD, znaczna oszczędność kosztów. By udowodnić lansowaną tezę, przedstawiciele firmy podczas premiery zaprezentowali nam, dziennikarzom, pokaz na żywo działającego Dużego Modelu Językowego na pojedynczym MI300X. Konkretniej, zaprezentowanego niedawno przez Amazon modelu Falcon-40 cechującego się 40 mld parametrów.

Wraz ze zwiększającą się ilością pamięci, zmniejsza się zapotrzebowanie na moc samego układu GPU/NPU, jak wykazały przeróżne eksperymenty AMD z Microsoftem, Metą i Amazonem. To oznacza, iż klienci do zrealizowania swoich celów wydajnościowych będą musieli nie tylko wydać mniej na układy scalone – o ile wybiorą AMD – ale też późniejszy koszt operacyjny będzie niższy.

Na tym jednak plan się nie kończy, podobnie jak przetwarzanie algorytmów SI nie kończy się na układzie scalonym. Jednym z istotnych atutów Nvidii jest własnościowa i zamknięta platforma programowa CUDA. Tymczasem AMD ogłosiło istotne i korzystne zmiany dla swojej platformy programowej ROCm, które jest głównie oprogramowaniem typu Open-Source Software, które pozwala programistom na dostosowywanie i kształtowanie swojego systemu dla GPU do własnych potrzeb, przy jednoczesnej współpracy z społecznością innych programistów i wzajemnym pomaganiu sobie w rozwiązywaniu problemów.

Chmury Mety, Amazonu i Microsoftu będą wykorzystywać chipy AMD. Na zdjęciu, po prawej, Nidhi Chappel z dyrekcji działu Azure HPC & AI

Chmury Mety, Amazonu i Microsoftu będą wykorzystywać chipy AMD. Na zdjęciu, po prawej, Nidhi Chappel z dyrekcji działu Azure HPC & AIAMD ROCm to zbiór sterowników, narzędzi rozwojowych i interfejsów API umożliwiających programowanie GPU od niskopoziomowego jądra do aplikacji użytkownika końcowego. Jest napędzany przez Heterogeneous-computing Interface for Portability (HIP) firmy AMD, czyli otwarte środowisko programowania GPU w C++ . HIP pozwala programistom ROCm tworzyć przenośne aplikacje na różnych platformach, uruchamiając kod na różnych urządzeniach, od dedykowanych kart graficznych do gier po klastry HPC o mocy egzaskalowej.

ROCm obsługuje modele programowania takie jak OpenMP i OpenCL, a także zawiera wszystkie niezbędne kompilatory, debugery i biblioteki OSS. AMD ROCm jest w pełni zintegrowany z frameworkami ML takimi jak PyTorch i TensorFlow. Może być wdrażany na wiele sposobów, w tym dzięki kontenerów takich jak Docker, Spack lub własnej kompilacji ze źródła.

AMD ROCm, czyli open-source’owa odpowiedź na Nvidia CUDA

AMD ROCm, czyli open-source’owa odpowiedź na Nvidia CUDAAMD przy okazji premiery MI300X ogłosiło jeszcze głębszą integrację z PyTorchem, co w efekcie oznacza, iż programiści mogą korzystać z modeli PyTorch na akceleratorach AMD bez jakichkolwiek czynności wdrożeniowo-konfiguracyjnych. To ma działać out of the box. I podobno działa.

AMD Instinct MI300X. Jak działa układ stworzony dla generatywnej sztucznej inteligencji?

AMD Instinct MI300X samodzielnie poradzi sobie z Falcon-40B czy GPT3.5

AMD Instinct MI300X samodzielnie poradzi sobie z Falcon-40B czy GPT3.5To pierwszy akcelerator Instinct pozbawiony jakichkolwiek układów CPU i polegający wyłącznie na układach GPU (podwójny układ CDNA 3 z 192 GB pamięci HBM3). Układ ma konstrukcję chipletową i składa się z ośmiu chipletów GPU i czterech I/O. Surowa wydajność samego chipu graficznego nie jest znana, choć AMD chwali się licznymi wykresami zestawiającymi MI300X z konkurencją (i oczywiście stawiające ją w niekorzystnym świetle). Obecność tak dużej ilości pamięci i użyteczność takiej konstrukcji są jednak faktem, a nie teorią.

W istocie, zaproszeni na premierę przedstawiciele Mety, Microsoftu i Amazonu zgodnie twierdzili, iż na dziś największym wyzwaniem sprzętowym związanym z Dużymi Modelami Językowymi i generatywną sztuczną inteligencją jest pamięć. Operatorzy chmur skupują masowo chipy do przetwarzania SI, jednak ponoć na dziś to nie moc obliczeniowa samych GPU i NPU jest problemem – a niewystarczająca ilość pamięci.

AMD Instinct MI300X, mający 192 GB ośmiokanałowej pamięci HBM3 brzmi jak strzał w dziesiątkę. Jedyny problem leży w tym, iż układy będą dostępne dopiero za jakiś czas, choć jeszcze w tym roku. Nvidia nie ma tak skrojonego na miarę produktu dla Dużych Modeli Językowych, tym niemniej należy pamiętać, iż pod koniec 2023 r. pojawić się mają chipy Nvidia Hopper.

AMD Instinct Platform, czyli osiem układów MI300X do hostowania licznych instancji LLM

AMD Instinct Platform, czyli osiem układów MI300X do hostowania licznych instancji LLMWydaje się mało prawdopodobne, by Nvidia w tak krótkim czasie mogła zmienić ich konstrukcję, by stanowiły skuteczniejsza odpowiedź na nowe układy AMD Instinct. Z drugiej jednak strony nierozsądnym jest zakładanie, iż korekty będą potrzebne. Być może Hopper z szyną pamięci NVLink okaże się jeszcze lepszym wyborem, na dziś tego nie wiemy. Wydaje się to jednak wątpliwe, mając na uwadze plany rozwojowe Nvidii. AMD ma też niezmiennie potencjalny atut sojuszu ze społecznością open source, niechętnie patrzącą na własnościowe CUDA.

Sztuczna inteligencja to nie wszystko. Tradycyjne aplikacje również, zdaniem AMD, powinny być tańsze.

AMD Instinct MI300X to bezpośrednia i mocna odpowiedź na Nvidia H100. MI300X dołącza do zaprezentowanego wcześniej akceleratora MI300A o bardziej tradycyjnej konstrukcji (łączącej CPU Zen 4 i GPU CDNA 3). Tym niemniej, choć generatywna sztuczna inteligencja jest szczególnie rozwojową dziedziną IT, nie oznacza, iż nie rośnie zapotrzebowanie na przetwarzanie danych w bardziej tradycyjny sposób.

AMD Epyc czwartej generacji. Podobno dalej gra wideo Crysis się na nim tnie.

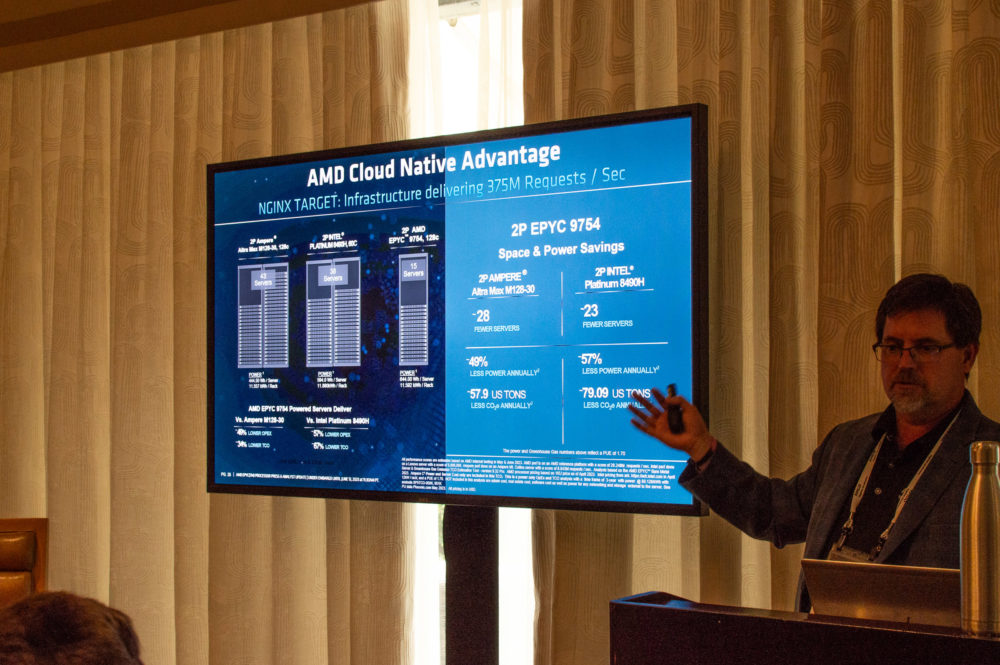

AMD Epyc czwartej generacji. Podobno dalej gra wideo Crysis się na nim tnie.Nowa propozycja od AMD dla operatorów chmur i firm potrzebujących hostować aplikacje jest układ scalony Epyc 97×4 o mikroarchitekturze Zen 4c. Ma na pokładzie 128 rdzeni CPU, a więc o 32 więcej od sztandarowego do tej pory Epyca 9004. Zwiększenie gęstości tranzystorów w porównaniu do układów o mikroarchitekturze Zen 4 ma zapewnić podobną wydajność przy istotnie niższym zużyciu energii – a więc w efekcie przy niższym całkowitym koszcie operacyjnym.

AMD dość jasno się wyraziło, iż z jego punktu widzenia Epyc 97×4 to już nie tylko rywal dla innych chipów serwerowych x86, ale też układ mający ostudzić entuzjazm klientów wobec serwerowych procesorów o architekturze ARM. Zen 4c to mikroarchitektura mająca zapewnić znacznie wyższą sprawność energetyczną. Przy zachowaniu zgodności z aplikacjami x86, bez konieczności wprowadzania dodatkowych warstw emulacji, wirtualizacji bądź translacji, co negatywnie wpływałoby na wspomnianą sprawność.

Nowe chipy Epyc to nie tylko deklasacja konkurencji od Intela i Nvidii. AMD rzuca wyzwanie producentom układów o architekturze ARM.

Nowe chipy Epyc to nie tylko deklasacja konkurencji od Intela i Nvidii. AMD rzuca wyzwanie producentom układów o architekturze ARM.Wall Street, o dziwo, nie jest pod wrażeniem. Inwestorzy czekają na pierwsze wdrożenia.

Mimo bardzo udanej premiery ceny akcji AMD w zasadzie nie drgnęły mocniej w żadną stronę. To dziwne, biorąc pod uwagę jak duże zamieszanie firma zrobiła wokół premiery. Spider’s Web był jednym z bardzo wielu specjalistycznych mediów z całego świata, zaproszonych na to wydarzenie. Wśród zaproszonych i występujących na scenie gości byli menadżerowie i szefowie Mety, Microsoftu i Amazonu. Pojawił się też dyrektor generalny Hugging Face. Trudno o większy prestiż wydarzenia – a mimo tego AMD nie zmniejszyło na giełdzie dystansu do Nvidii.

Lisa Su, dyrektorka generalna AMD, nie pozostawiła jednak zaproszonym gościom żadnych złudzeń. Panią Su warto słuchać z uwagą, to jedna z wybitniejszych postaci w branży i to jej decyzje wyprowadziły kilka lat temu AMD z beznadziejnego kryzysu i nakierowały firmę na trajektorię wysokiego wzrostu. – Sztuczna inteligencja to największe dla nas wyzwanie, o znaczeniu strategicznym. Wartość rynku akceleratorów SI na dziś to około 30 mld dol., za cztery lata ma być to 150 mld dol. – deklarowała ze sceny. Zauważyła też, iż generatywna SI w raptem pół roku całkowicie zmieniła branżę operatorów chmurowych i twórców aplikacji i, jak dodała, to dopiero początek.

Lisa Su z chipem Epyc 4 w dłoni. Warto zwrócić uwagę, iż AMD korzysta ze zbliżonej mikroarchitektury w chipach dla PC. Innowacje dla korporacji i centrów danych trafiają więc po czasie również do użytkowników końcowych.

Lisa Su z chipem Epyc 4 w dłoni. Warto zwrócić uwagę, iż AMD korzysta ze zbliżonej mikroarchitektury w chipach dla PC. Innowacje dla korporacji i centrów danych trafiają więc po czasie również do użytkowników końcowych.Niezależne od bieżącej wyceny giełdowej, AMD nie musi się martwić o rynek zbytu dla układów Epyc i Instinct. Świadczą o tym nie tylko pozory w formie zaproszonych na konferencję gości od partnerów, ale również i praktyka – chipy Epyc są już od długiego czasu masowo kupowane między innymi przez operatorów Azure’a i Amazon Web Services. Popyt na nowe akceleratory Instinct jest również wysoki. Tak na dobrą sprawę to AMD nie musi pokonać Nvidii, by odnieść sukces. Ów rynek rośnie tak szybko, iż wystarczy nadążać, by budować potęgę.

To nadążanie to wyraźnie nie jest jednak taka prosta sprawa, patrząc na zaległości niemal dowolnej innej zajmującej się układami scalonymi firmy. Kompetentna i mocna odpowiedź AMD była wręcz rynkowi bardzo potrzebna – w przeciwnym razie wyceniana na ponad bilion dolarów Nvidia nie miałaby żadnych przeszkód, by dyktować branży swoje warunki. Fakt, iż AMD stawia na open source zamiast na własnościowe technologie jest istotną wisienką na torcie – a kto wie, czy nie czymś jeszcze ważniejszym.

Przyzwoitość nakazuje jednak zauważyć, iż całe wydarzenie było jednym wielkim festiwalem obietnic. Prawdopodobnie dlatego Wall Street pozostał niewzruszony, czekając cierpliwie na pierwsze raporty od klientów AMD. U reszty przedstawicieli branży da się jednak wyczuć ekscytację. Tego rodzaju konkurencja, nastawiona na wojnę cenową i oszczędności w kosztach operacyjnych, to korzyść dla wszystkich zainteresowanych. W tym dla użytkowników końcowych, bo za sprawą powyższego innowacyjne usługi i aplikacje będą się na ich telefonach i komputerach pojawiać szybciej – i w jeszcze korzystniejszej cenowo formie.

2 lat temu

2 lat temu